Laboratorium zaawansowanej elektroniki i automatyki 17

Napędem rewolucji przemysłowej, rozpoczętej w połowie XVIII wieku w Anglii, była maszyna parowa Jamesa Watta z 1776 roku osiągająca 1.2% sprawności. Watt udoskonalił maszynę Newcomena z 1712 roku osiągającą 0.5% sprawności. Watt dodał maszynie parowej regulator odśrodkowy obrotów ale regulatory stosowano już wcześniej. Regulacje temperatury odkryto w 1624 roku a regulacje ciśnienia w 1681 a inne regulacje później. W latach osiemdziesiątych XIX wieku u szczytu rozwoju kolejne rozprężanie pary w trzycylindrowej maszynie parowej dawało sprawność 7-8%. Sprawność do 15% osiągały maszyny parowe o wysokich parametrach pary przegrzanej z przegrzewem międzystopniowym. Osiągnięcia w dziedzinie silników parowych wyprzedzały naukę termodynamiki i teorie sterowania. Oczywiście lepsza turbina parowa wyparła maszynę parową. Najlepsze elektrownie cieplne osiągają sprawność powyżej 50% a więc skok w efektywności jest ogromny.

Uboga w ropę naftową do silnika Diesla III Rzesza w czasie II Wojny masowo produkowała wojenne parowe lokomotywy. Maszyna parowa o mocy 2500 KM napędzała statki Liberty, których w okresie II Wojny w USA wyprodukowano aż rekordowe w historii 2751 sztuk. Był to zmodyfikowany brytyjski model statku firmy Joseph L. Thompson & Sons z Sunderlandu z 1879 roku. Mimo iż bardzo przestarzały był tani i bardzo łatwy w budowie co pozwalało zaprząc do produkcji wiele prostych technologicznie firm. Jeden z egzemplarzy statku Liberty wbudowano w 4 dni i 15 godzin.

Popularyzacja w Europie kolejowej trakcji elektrycznej wynikała z dostępności taniego węgla do opalania elektrowni i stosunkowo „wysokiej” ceny ropy naftowej. Ale NRD mając subsydiowaną ropę naftową z ZSRR stosowała lokomotywy z silnikiem Diesla a na własnym węglu używała lokomotyw parowych. Po 1967 roku odremontował wojenne lokomotywy parowe III Rzeszy i dalej ich używał. Gdy Związek Radziecki w 1980 roku zażądał od NRD za ropę dolarów po cenie rynkowej ( wcześniej postąpił tak z Polską ) rozpoczęto w NRD spóźnioną, pośpieszną elektryfikacje.

W lokomotywach parowych stosowano ulepszenia wykorzystania ciepła oraz mechanizacje (podawanie węgla do paleniska kotła ) i prostą automatyzacje ale zostały one wyparte przez lokomotywy z silnikiem Diesla i lokomotywy elektryczne. Warto zauważyć że sprawność doskonalonej lokomotywy parowej wzrosła z niecałego procenta do ponad 10% w ostatnich modelach i pewnie dalej by rosła.

Najcięższa Polska lokomotywa parowa z 1958 roku, Ty51 ważyła prawie 190 ton. Konstrukcja była kopią nowoczesnego modelu Ty246, czyli ponad 100 "trumanów", których Polska gratis dostała od USA w ramach dostaw UNNRA w 1946 roku. Parowozy te ciągnęły w Polsce pociągi o ciężarze dochodzącym do 3000 ton mimo iż producent ich absolutne maksimum określił na 2200 ton. Z racji nowoczesności i komfortu pracy maszyniści mówili że "otworzyły im się oczy" i nazywali lokomotywę "amerykańską limuzyną". Widać nasze co najmniej 20 letnie opóźnienie w lokomotywach parowych, które przecież są bardzo proste technologicznie.

Wraz z doskonaleniem lokomotyw doskonalono systemy sterowania ruchem jako że wypadki ciężkich i szybkich pociągów stały się bardzo kosztowne.

W USA ropa naftowa zaczęła wypierać węgiel jako surowiec energetyczny już w latach czterdziestych XX wieku co było powodem de-elektryfikacji kolei i masowego użycia lokomotyw Diesla. Duży silnik Diesla lokomotywy ma znacznie lepszą sprawność niż elektrownia cieplna. Dodatkowo straty mocy występowały w przesyle a sieć przesyłowa i trakcja elektryczna są dość drogie. Elektryfikacja w USA była więc ekonomicznym nonsensem.

Zatem o wyborze paliw / zasilania decydowały czynniki ekonomiczne.

Podobnym nonsensem jest obecnie samochód elektryczny do którego ładowania energii elektrycznej dostarcza elektrownia cieplna zasilana węglem, olejem lub gazem. Samochód elektryczny ma sens gdy energia będzie pochodzić że źródeł odnawialnych.

Postanowiona przez rządy rewolucja energetyczna nie ma co do skali precedensu w historii. "Porozumienie paryskie, podpisane przez 194 kraje i Unię Europejską, ma na celu ograniczenie wzrostu globalnej temperatury do znacznie poniżej 2°C i kontynuowanie wysiłków na rzecz ograniczenia go do 1,5°C w celu uniknięcia katastrofalnych skutków zmian klimatycznych."

W Polityce Energetycznej Polski do 2040 roku podano: "Koszty realizacji polityki klimatycznej w latach 2021–2040 mogą wynieść nawet ok. 1 600 mld PLN. W sektorze paliwowo-energetycznym mogą one wynieść 867–890 mld zł, zaś w sektorach pozaenergetycznych ok. 745 mld PLN."

Czyli polska czteroosobowa rodzina miesięcznie przez 19 lat ma ponosić 760 zł kosztów ( o wartość pieniądza z 2020 roku ) związanych z unijną polityką klimatyczną.

Polskie firmy nie produkują reaktorów atomowych, turbin wiatrowych czy paneli fotowoltaicznych co zdaje Polskę na dewastujący gospodarkę wielki import. Sytuacja bogatszych krajów gdzie są producenci tych rzeczy jest o wiele lepsza.

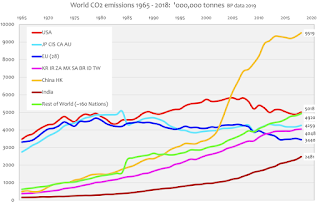

Mocne w „zielonej” energetyce są Chiny emitujące jednak najwięcej CO2, które były centrum gospodarczym globu przez wieki i możliwe że wracają na swoją daną pozycje.

Sumaryczna emisja dwutlenku węgla przez kraje Europejskie wróciła do poziomu z 1967 roku. Sama Europa więc świata nie zbawi i być może środki zainwestowane poza Europą dadzą znacznie większe efekty w ograniczeniu emisji CO2 niż inwestowane w Europie.

O ile sama idea pracy reaktora jądrowego jest prosta to elektrownia jądrowa jest bardzo skomplikowana głównie przez rozbudowane ponad miarę systemy bezpieczeństwa. Stąd wiele wysiłków aby sam generator z otoczeniem był biernie o wiele bezpieczniejszy a nawet bezpieczny. Gdyby w Fukushimie reaktory były biernie bezpieczne praktycznie nic wielkiego by się nie stało.

Ponieważ ciągle zmieniane są przepisy dotyczące bezpieczeństwa to budowa elektrowni jądrowej ciągnie się w nieskończoność.

Po mniejszych i większych awariach okazuje się że przepisy są i tak lekceważone.

Choć pożar w tunelu kablowych powinien być absolutnie wykluczony to nie jest. Po utracie połączeń brak informacji i sterowania stwarza bardzo niebezpieczną sytuacje. Oczywiście zwarciowo znacznie bezpieczniejsze są do przesyłania informacji światłowody niż przewody. Przestrzegać trzeba ostrego zakazu krzyżowania się niezależnych systemów. Bez tego ciężka awaria jednego systemu prędzej czy później przenosi się na kolejny system i tak aż do osiągnięcia dna.

Systemy z pełną lub częściową redundancją stosowane są w samolotach, satelitach ale też na statkach i w potencjalnie niebezpiecznych instalacjach przemysłowych. Ale różne drobne środki bezpieczeństwa są szeroko stosowane. Przez termoparę przepuszcza się niewielki prąd monitorujący jej stan i nie mający na pomiar żadnego wpływu. Gdy nastąpi przerwa w termoparze fałszywa temperatura ma być odkryta i jednocześnie bezpieczna dla systemu.

Popularny sensor temperatury RTD PT100 może mieć połączenie czteroprzewodowe. Inteligentny kondycjoner może w razie uszkodzenia przewodu pracować w przełączonej konfiguracji 4, 3 lub 2 przewodowej.

Monitorowana może być izolacja przewodów do konstrukcji systemu „izolowanego”. Informacje o tym że coś złego dzieje się z izolacją dostaniemy z wyprzedzeniem. Zdarza się że na technika otwierającego „szczelną” skrzynkę połączeniową leci z niej na niego woda !

Tematowi redundancji poświęcone są dalsze ćwiczenia.

Automatyzowane są procesy ciągłe, wsadowe i dyskretne.

W elektrowni cieplnej regulowane są głównie ciągłe strumienie mas paliwa, wody i pary wodnej. Ogólnie o zadaniach automatyki decyduje więc sama konstrukcja elektrowni. Automatyzacja dotyczy też jednak skomplikowanych procesów uruchomienia bloku elektrowni.

Jak dotychczas słabo automatyzowany jest proces decyzyjny a są decyzje o potężnym ciężarze gatunkowych ważące na całe dekady rozwoju. Najlepiej problem ilustrować konkretnym przykładem

Wytwarzanie energii jest najbardziej uciążliwym środowiskowo procesem jaki w gigantycznej skali zastosował człowiek.

Tylko z powodu emisji pyłów PM2.5 rocznie w świecie umiera około 9 mln ludzi a w tym w Chinach 2.5 mln a w Polsce około 100 tysięcy ludzi.

Polska energetyka emituje rekordowe w Europie 758 gram CO2 na każdą wytworzoną kilowatogodzinę.

W Polsce do ogrzewania domków i mieszkań w piecykach spala się rocznie 11 mln ton węgla podczas gdy we wszystkich krajach Unii Europejskiej 13 mln ton czyli w Polsce 85 % całości węgla. Sytuacja jest więc w Polsce nienormalna. Nic dziwnego że przy zimnej bezwietrznej pogodzie jest smog.

Elektrownia cieplna wytwarza energie elektryczna a odpadowe ciepło oddaje do rzeki, jeziora lub atmosfery. W kogeneracji elektrociepłownia ma trochę mniejszą sprawność w generacji energii elektrycznej ale wytwarza dużo ciepłą do ogrzewania domów ( w lecie do ochładzania ) i do wytworzenia ciepłej wody i całkowita sprawność jako suma energii elektrycznej i cieplnej jest znacznie większa. Polskie gospodarstwa domowe 72% energii konsumują w postaci ciepła. Ilość potrzebnego ciepła do ogrzewania wynika głównie z klimatu czyli tak zwanych stopniodni oraz izolacji termicznej domu i oczywiście jego powierzchni.

Problemem z elektrociepłownią dużej mocy jest jej wymuszona peryferyjna lokalizacja i znaczna długość rurociągów z gorącą wodą do ogrzewania. Rurociągi są kosztowne i powodują znaczną utratę ciepła. Ich długość nie powinna przekraczać 3 km ale rurociągi o dużej średnicy i bardzo dużym przepływie mogą być dłuższe.

W Europie w kogeneracji powstaje zaledwie 12% energii elektrycznej ale rządy zamierzają ten wskaźnik w rewolucji energetycznej szybko podwoić. Natomiast w Dani i Holandii przekracza on 60% a w Finlandii wynosi rekordowe w świecie 82%.

Węglowa elektrownia – elektrociepłownia jest duża rozmiarem na co składa się bocznica kolejowa do rozładowania węgla, place składowe węgla i popiołu, chłodnie kominowe o ile są stosowane, długa instalacja do wytwarzania z dwutlenku siarki w spalinach gipsu a niego płyt kartonowo - gipsowych i duża rozdzielnia wysokiego napięcia. Instalacja do wychwytu NOx też jest niemała a bardzo trudny wychwyt rtęci jest już w wielu krajach wymagany co powoduje zaniechanie budowy elektrowni węglowych.

Elektrownia gazowa jest znacznie prostsza, mniejsza i znacznie szybsza w budowie. Bardzo wysoka jest sprawność elektrowni na gaz ziemny z nowoczesną wysokotemperaturową turbiną gazową z której wylotowe gazy spalinowe o wysokiej temperaturze ogrzewają kocioł do wytwarzania pary do konwencjonalnej turbiny parowej. Jeśli tą konfiguracje zmodyfikujemy do systemu elektrociepłowni to sprawność sięga 80% a teoretycznie może przekroczyć 80%. Dodatkową zaletą jest małe obciążenie środowiska odpadową energią cieplną.

Teoretycznie mały zajmowaną powierzchnią ( teren z likwidowanych przestarzałych obiektów ) zwarty gazowy blok mocy elektrycznej 400-1000 MW i cieplnej potencjalnie można umieścić w „środku” metropolii, dla zmniejszenia długości rurociągów, tym bardziej że komin nie musi być wysoki jako że nie ma potrzeby rozpraszania pyłów i toksyn wysokim kominem jak w przypadku opalania węglem. Moc trzeba wyprowadzić podziemnymi torami kablowymi o napięciu ponad 400 KV i do większości „bliskich” odbiorców kablami napięcia 115 KV lub podobnym. Podziemne rozdzielnie wysokiego napięcia są już, w metropoliach gdzie grunty są horrendalnie drogie, budowane od lat.

Długość grubych rurociągów z gorącą wodą do ogrzewania metropolii ma wtedy rozsądną wartość.

Ogromną zaletą turbiny gazowej ( czyli pierwszego stopnia tej elektrociepłowni ) jest krótki czas uruchomienia na tle konwencjonalnych bloków cieplnych co przy dużej niestabilnej „zielonej” generacji wiatrakami i fotovolataiką ma ogromne znaczenie.

Energia chemiczna – cieplna w gazie jest dużo droższa niż w węglu ale można ją o wiele lepiej wykorzystać. No i nie zachodzi rujnowanie zdrowia populacji.

Inwestycje w elektrownie i system przesyłu energii cechują wysokie koszty inwestycyjne i stosunkowo długi cykl inwestycyjny. Stąd trzeba oszacować zapotrzebowanie na energie w przemyśle, usługach i gospodarstwach domowych w perspektywie 25-30 lat. Wziąć pod uwagę trzeba szanse pojawienia się konkurencyjnych technologii alternatywnych generacji energii elektrycznej i cieplnej. Elektrownie wywierają poważne skutki środowiskowe co trzeba brać pod uwagę. Inwestycje w elektrownie cieplne były w świecie do niedawna rentowe na poziomie 6-11% ale dodatkowa wymuszona usługa głębokiej regulacji mocy dostarczana gratis „zielonej” energetyce bardzo mocno zachwiała rentownością nierzadko sprowadzając ją poniżej zera.

Według danych z 2019 / 2020 roku ( są spotykane różne dane !) koszty ( bez kosztu kredytu mocno ważącego przy długotrwałych inwestycjach, zwłaszcza jądrowych ) inwestycji na1 KW mocy zainstalowanej elektrowni wynoszą:

combustion turbine - $710/kW

gas/oil combined cycle power plant - $1000/kW

onshore wind - $1600/kW

offshore wind - $6500/kW

solar PV (fixed) - $1060/kW (utility), $1800/kW

solar PV (tracking)- $1130/kW (utility) $2000/kW

battery storage power - $1380/kW

conventional hydropower - $2752/kW

geothermal - $2800/kW

coal (with SO2 and NOx controls)- $3500–3800/kW

advanced nuclear - $6000/kW

fuel cells - $7200/kW

W przypadku szybko rozwijających się technologi dobre prognozy i decyzje daje zjawisko „uczenia się” Szybko rosły szybkości procesorów i spadały koszty fotovoltaiki. Ale sprawność elektrowni cieplnych od końca lat siedemdziesiątych rośnie bardzo wolno.

Wszelkie przewidywania obciążone są niepewnością. Są zjawiska trudne do przewidzenia i sensownego wytłumaczenia.

Z regionów gdzie nabyto już znaczne ilości samochód elektrycznych i można już wyciągać wnioski statystyczne pochodzą informacje że ich właściciele robią nimi przebiegi o połowę mniejsze niż samochodami spalinowymi ! Obawiają się nimi jechać dalej, szczególnie w zimie.

Holandia wprowadzi zakaz sprzedaży samochodów spalinowych w 2030 roku a Francja w 2040 roku.

Epokowy wynalazek pieniądza spopularyzował handel hurtowy i detaliczny, handel w regionach i na kontynentach dzięki transportowi kolejowemu i dzięki transportowi morskiemu handel globalny. W USA w handlu detalicznym zatrudnionych jest ponad 11% wszystkich pracujących. W świecie handel detaliczny zatrudnia circa 9 - 17% pracowników.

Pokusa użycia w handlu tanich ( amortyzacja jest wieloletnia ) automatów zamiast drogich pracowników jest więc wielka

W Wielkiej Brytanii automaty do sprzedaży za monetę pojawiły się w latach osiemdziesiątych XIX wieku. Na całym świecie mechaniczne „automaty” do sprzedaży biletów za monety zyskały dużą popularność. „Vending machine” sprzedawały bilety, karty pocztowe, znaczki, gazety ( głównie w USA ), papierosy, zapałki, czekoladę, gumy do żucia, wyroby mydlane... W 1893 roku niemiecki producent Stollwerck miał conajmniej 15 tysięcy automatycznych maszyn sprzedających jego czekolady ! Automaty sprzedające miały sens tylko wtedy gdy cena towaru była okrągła ( wartość monety ) a pieniądz był stabilny.

W sklepie towar podawał sprzedawca co miało zapobiegać kradzieżom i przyjmował gotówką ( rzadziej czekiem ) zapłatę od nabywcy. Sklepy samoobsługowe pojawiły się w USA już w latach I Wojny Światowej. Klient po zrobieni zakupów stawał przed kasjerem który „nabijał”na kasę ceny kupionych przedmiotów.

Pierwsze kasy z mikroprocesorem pojawiły się w połowie lat siedemdziesiątych ale „Point Of Sale” czyli POS to faktycznie wynalazek drugiej połowy lat osiemdziesiątych. „Kasa” jest połączona siecią z komputerem magazynu i zarządu sklepu. Kasjer skanuje kody kreskowe na towarach wybranych przez klienta i położonych na taśmie z napędem a klient płaci gotówką, kartą płatniczą magnetyczną, kartą z chipem, kartą bezprzewodową lub smartfonem z personalizującą kartą SIM. Kasa ma ekran dla kasjera i drugi dla klienta oraz drukarkę paragonu. POS może mieć wagę dla towarów luzem lub klient wcześniej musi zważyć towar w plastikowej torbie i nakleić na nią wydrukowaną przez wagę etykietę. Ponieważ producentów elementów składowych dla POS jest wielu stworzono standardy komunikacji z peryferiami:

Logic Controls \ BemaTech

Epson Esc/POS

UTC Standard

UTC Enhanced

AEDEX

ICD 2002

Ultimate

CD 5220

DSP-800

ADM 787/788

HP

Ułatwiono też stworzenie oprogramowania POS. Microsoft w 1996 roku wypuścił OPOS czyli „OLE for POS”. OLE to popularny Object Linking & Enabling. Sun Microsystems, IBM i NCR w 1999 wypuścili JavaPOS. Niezależna od platformy JavaPOS jest dla Java tym czym OPOS dla Windows.

Oferowane POS są dedykowane do zastosowań. Przykładowo POS do restauracji nie ma ani wagi ani czytnika kodów kreskowych. Kasjer na ekranie dotykowym monitora dotyka nazwy dań i napojów. POS dla restauracji może być zintegrowany z systemem automatycznych zamówień co mocno system komplikuje. Są lokale gdzie już nie można płacić gotówką co nikomu nie utrudnia życia jako że w samych USA kart kredytowych ( a są też inne ) jest około 1300 milionów a więc każdy ma zwykle 4 karty kredytowe a niektórzy 10 kart lub cały portfel.

Wydajność POS z kasjerem ( jeśli stoi przed kasą kolejka ) zależy od:

-Sprawności manualnej i intelektualnej kasjera który musi szybko przesunąć towar etykietą w stronę skanera

-Niezawodnej pracy skanera kodu kreskowego aby nie trzeba było powtórnie skanować towaru

-Jakości etykiet na towarach aby nie trzeba było ręcznie wpisywać kodu towaru, zwłaszcza kilkakrotnie z błędami

-Dysponowania banknotami i monetami do wydania reszty. Przy braku trzeba rozmieniać i pożyczać z pomocą innych kasjerów ( też tracą czas) i czekać na doniesienie bilonu z magazyny lub zabranie jego nadmiaru

-Sprawności manualnej klientów pakujących towar do swojej torby

-Szybkości zapłaty. Część klientów dopiero wyciąga z torby portmonetkę a niej pieniądze lub karty płatnicze a po operacji chowa

-Szybkości pracy czytnika karty płatniczej lub smartfona

-Ilości klientów zgłaszających reklamacje z powodu oszustw z cenami praktykowanych przez sklepy

-Ilości klientów zgłaszających reklamacje z powodu wad zwracanego towaru

-Innych operacji

Ale „drogi” kasjer jak był tak nadal jest.

Kasy samoobsługowe ( Self CheckOut SCO lub Assisted Checkout ACO lub Self Service Checkout SSC ) które obsługują sami klienci wprowadził w USA gigant NCR.

Kluczowe dla działania SCO są dwie wagi. Wagą całego towaru podwiezionego z hali sklepu do SCO i towarów przesuniętych przed czytnikiem kodu paskowego. Program mając wagi towarów w bazie danych sprawdza czy zmiany stanu wag odpowiadają czytanemu towarowi i czy na koniec zeskanowany towar waży tyle samo co przywieziony z hali sklepu. Gdy SCO ma do zapłaty oprócz kart akceptować banknoty ma też skaner banknotów i całą drogą maszynę do wydawania reszty.

Kontrola wagami jest często niemożliwa w przypadku dużych towarów. Oszust może przykleić na kartonie drogiej rzeczy etykietę zdjętą z taniej rzeczy i dokonać oszustwa. W ten sposób oszukuje się na odbiornikach TVC czy komputerach. Ponieważ manipulacje i oszustwa przy SCO są bardzo łatwe zyskały dużą popularność co hamuje popularyzacje SCO, których mimo tego jest w świecie ponad pół miliona. Nie ma kasjera ale stanowiska obserwuje ochrona. O ile drobna kradzież jest w większości krajów świata wykroczeniem ( tak jak w Polsce ) to oszustwo z przeklejaniem etykiet na towarach jest traktowane jako przestępstwo. Za niewielkiej wagi oszustwo można znaleźć się w więzieniu.

Rozwiązaniem jest inteligenta analiza obrazu z kamery przy SCO lub automatyczne śledzenie kamerą klientów w sklepie.

SCO są jeszcze dość zawodne i to jest kolejna ich wada.

Gigantyczny Amazon.com słusznie zaczynał od internetowej sprzedaży książek. Ilość tytułów książek i czasopism była i jest ogromna. Stacjonarne księgarnie mają tylko niektóre ostatnio wydawane książki. Przewaga w ilości tytułów oferowanych przez Amazona nad stacjonarnymi księgarniami od początku była ogromna.

Ta przewaga dotyczy wszelkich towarów których jest bardzo dużo i lokalny sklep nie może ich mieć na stanie bowiem bardzo długo je przechowując zbankrutuje.

W USA sieć kolejowa zintegrowała gospodarczo cały kontynent. Bazująca na kolei sprawna i uczciwa poczta doskonale nadawała się do obsługi sprzedaży wysyłkowej. Długie czasy doręczania przesyłek i duża ilość zaginięć przesyłek zniechęcą potencjalnych klientów. Wydawane w potężnych nakładach gazety pełne były reklam. Łatwo można było zamówić towar z drugiego krańca USA. To w USA odkryto potencjał ogromnego rynku i produkcji masowej.

Do sprzedaży wysyłkowej nie nadają się zwykłe produkty spożywcze kupowane na miejscu.

Oczywiście Amazon i konkurencja ciągle automatyzują proces skompletowania internetowego zamówienia i jego wysłania do klienta. Ale chińska konkurencja chyba jest w automatyzacji o krok do przodu.

Kluczem do zrozumienia wielu procesów w niedawnej historii jest pojęcie "klasa średnia" Jest punktem odniesienia dla każdego ustroju i przybiera różne formy. Forma "klasy średniej" od razu wyznacza czy kraj się rozwija czy stagnuje i upadnie. Jeśli o awansie decydują zdolności i praca jednostki kraj się rozwija. Jeśli decydują chore układy, dojścia, koterie i korupcja kraj prędzej czy później upadnie.

W feudalizmie klasą średnią jest szlachta, w kapitalizmie burżuazja średnia i mała, w reżimie autorytarnym biurokracja a w partiokracji nomenklatura.

W wielu krajach małymi kapitalistami czyli ową klasą średnią byli bardzo liczni właściciele sklepików wypartych przez konkurencyjne duże obiekty handlowe. Na nic nie zdadzą się żale że klasa średnia się skurczyła.

Jak sama nazwa wskazuje automaty do sprzedaży napoi, przekąsek, papierosów i innych towarów szybko sprzedawalnych ( FMCG – Fast Moving Consumer Good ) są bezobsługowe. Mogą internetem raportować o stanie towaru i operacje logistyczną załadowania towaru w miejsce sprzedanego można zaplanować automatycznie.

Użyteczne pojęcie wrażliwości oznacza w elektronice, automatyce, przetwarzaniu sygnałów ...zmianę charakterystyki częstotliwościowej lub odpowiedzi czasowej na zmianę parametru / parametrów systemu. W dziedzinie częstotliwości wrażliwość układu regulacji ma związek z marginesem wzmocnienia i marginesem fazy i stąd żądanie obu minimalnych marginesów.

Podstawą algorytmów obliczania wrażliwości układów było ogólne twierdzenie teorii obwodów sformułowane przez badawcza koncernu Philips B. Tellegena w 1952 roku. W telekomunikacji szeroko stosowano filtry aktywne RC. Dla poszczególnych rodzajów filtrów symbolicznie ( bardzo uciążliwe ręczne rachunki ) wyliczono funkcje wrażliwości na wartości elementów RC i wzorów użyto w programach komputerowych. Im większa jest wrażliwość filtrów aktywnych tym wymagane są dokładniejsze i stabilniejsze elementy R i C ( czyli droższe a precyzyjne elementy RC są drogie ) i lepszy wzmacniacz operacyjny. Celem pracy programu komputerowego było stworzenie jak najtańszego filtru spełniającego podane wymagania. Filtry aktywne zostały w telekomunikacji wyparte przez filtry cyfrowe ale różna filtracja analogowa jest nadal nieunikniona i stosowana.

Przy korzystaniu z programów komputerowych „projektowanie” optymalnych układów sterowania nie jest trudne. Sprawa się komplikuje gdy zainteresujemy się wrażliwością systemu. Jedną z trudnych odmian optymalności jest sterowanie czasooptymalne. Chodzi o jak najszybsze uzyskanie zadanego punktu w przestrzeni stanów.

Przyśpieszenie jest całką z impulsu. Szybkość jest całką z przyśpieszenia. Droga jest całka z prędkości. Zacznijmy tam gdzie wszyscy kończą. W podręcznikach akademickich często przykładem jest kaskada dwóch integratorów. Wejściem ograniczonym do zakresu <-1..+1> ( lub innego ) jest przyspieszenie. Wyjście pierwszego integratora to prędkość a drugiego integratora droga. Chcąc jak najszybciej osiągnąć punkt docelowy ( zwykle ! ) wpierw maksymalnie przyspieszamy a potem hamujemy.

W przykładach celowo sprawę trochę skomplikowano. Mamy prędkość początkową -5 i dystans do celu 60. Sygnał sterujący -1 / +1 powiększono dla czytelności wykresu 10 razy.

Okazuje się że układ sterowania czasooptymalnego jest okropnie wrażliwy i to w specyficzny sposób. Na pierwszym wykresie pokazano prace idealnego układu ale nie w czasie ciągłym ale dyskretnym. Już na jeden interwał pojawiła się szpileczka.

Gdy współczynnik wzmocnienia procesu jest większy ( tu o 4% ) od założonego to po przełączeniu sterowania występuje w szerokopasmowej realizacji analogowej nieskończenie wiele przełączeń i trajektoria „ślizga” się po linii przełączeń. Obiekt uśrednia odpowiedź a szerokie pasmo pętli regulacji wyznacza ilość przełączeń.

Gdy współczynnik wzmocnienia procesu jest mniejszy od założonego ( tu o 2% ) to po przełączeniu sterowania, ponowne cykliczne przełączenie wystąpi dopiero po „przeregulowaniu” Wystąpi zatem nieskończenie wiele cykli przełączeń sterowania. Wartości odległości od celu tworzą postęp geometryczny i czas osiągnięcia celu jest skończony ale długi.

Wyliczenie czasu ( symboliczne ) osiągnięcia celu w przypadku ruchu ślizgowego i cykli jest możliwe. Ocenianą wartość wzmocnienia procesu oznaczono jako „a”. Oczywiście jest różna od wartości rzeczywistej procesu. Na jednym wykresie pokazano jednocześnie dwie funkcje dla a<1 czyli ślizgową i dla a>1 czyli cykliczną z „przeregulowaniem” . Ocena idealna jest dla a=1 a czas wynosi 1. Dla większego „a” mamy cykle z „przeregulowaniem”. Nawet bardzo mały błąd w ocenie „a” powoduje że od razu rośnie ( tak zwana wrażliwość szpilkowa ) czas osiągnięcia celu co zresztą widać na wykresach. Dla a=2 czas wynosi circa 270% a więc jest naprawdę źle. Z kolei dla a<1 mamy ruch ślizgowy i dla identycznego błędu oceny jak poprzednio czyli dla a=0.5 czas wzrósł do 120% czyli o 20% czyli niewiele.

Czyli konieczne jest wybranie bezpiecznej trajektorii ślizgowej. Czy ruch po trajektorii ślizgowej ma jakieś mankamenty ? Ma i to poważne. Wielokrotna gwałtowna pełna zmiana sterowania powoduje powstawanie różnych drgań w układzie mechanicznym ( ma on w dodatku wiele stopni swobody ) i mogą być one słabo tłumione. Zatem użycie modu ślizgowego w systemie przestawiania głowic twardego dysku HD jest wykluczone bowiem w pobliże celu szybko dotrzemy ale trzeba czekać na wygaśnięcie drgań w ramieniu i konstrukcji.

Przełączania ślizgowe są wykluczone dla długiego i siłą rzeczy elastycznego ramienia manipulatora użytego na promie kosmicznym.

Poza tym sterowanie czasooptymalne w wersji dyskretnej nie doprowadza dokładnie do celu i na koniec jest paskudna sekwencja -1,+1,-1...

Czyli prosty teoretyczny układ czasooptymalny jest zupełnie do niczego. Jest bezużyteczny.

Realny algorytm działa jednak bez zarzutu. Nie ma gwałtownego przejścia z +1 na ca -0.9 i na koniec z -1 na prawie zero. Gdy zbliżamy się do punktu docelowego następuje bezskokowe przejście na regulacje liniową jako że regulator liniowy jest już nienasycony i przydatny do finalnego zregulowania błędu.

Układ działa jak najbardziej poprawnie także w sytuacjach dziwnych gdy na przykład prędkość początkowa jest duża i przy maksymalnym hamowanie przejedziemy przez punkt docelowy i trzeba się cofnąć.

Czas to pieniądz ! Wbudowane komputerki trajektorie quasi - czasooptymalne wyznaczają także dla drogich dźwigów, maszyn CNC, robotów, rakiet, samolotów ale też instalacji przemysłowych.

Praca z cyklem - „przeregulowaniem” jest z reguły niedopuszczalna. O ile „przeregulowanie” w przypadku napędu HD tylko wydłuży czas pozycjonowania głowic i dostępu do informacji to w przypadku maszyny CNC, robota czy dźwigu doprowadziłoby do niszczącego uderzenia narzędzia lub przedmiotu. Uderzenie przenoszonym przez potężny dźwig kontenerem z drogą zawartością o statek , inne kontenery, ziemie czy samochód jest bardzo kosztowne.

Wzmocnienia obiektów można też estymować aby pracować szybko ale bezpiecznie.

Dla jasności sytuacji. Sterowanie czasooptymalne może być w pętli zamkniętej ( jak tutaj ) ale też nadążne i w pętli otwartej.

Młody Technik miał dział „Pomysły genialne, zwariowane i takie sobie” W tej poetyce można rozważać na przykład „czasooptymalny wzrost gospodarczy”

Sprawdzenie.

1.Dana jest kaskada trzech integratorów o stałych czasowych Tc=1. Stosując zasadę minimum rozwiąż zadanie sterowania czasooptymalnego przy ograniczonym sterowaniu <-1..+1> Sporządź diagram algorytmu sterowania.

Uwaga. Zadanie jest podwójnie trudne. Rutynowo uzyskuje się funkcje przełączeń, których nie da się zaprogramować nawet w podwójnej dokładności. Stąd naprowadzający do przekształceń wymóg sporządzenia diagramu.

2.Wyprowadź wzór na minimalny (idealny) czas dojścia do punktu V=0 i S=0 w kaskadzie dwóch integratorów z początkowych Vo i So. Stała czasowa integratorów wynosi 1 a sterowanie jest <-1..+1>

3.Po fazie czasooptymalnej sterowania stosowany jest dalej w kaskadzie dwóch integratorów regulator liniowy PD o wzmocnieniu K i Td takim że dobroć wynosi Q=0.707.

Podaj funkcje do oceny czy przy aktualnych V i S można już sensownie przejść na dalszą regulacje liniową. Czy na płaszczyźnie V i S funkcja tworzy jakieś krzywe ?

N.B.System jest wyższego rzędu i z tego wynika podane tu wzmocnienie K. W poetyce maksymalnie płaskiej charakterystyki częstotliwościowej odpowiedzi, „mała stała czasowa” to tutaj suma stałej czasowej filtru eliminującego efekty rezonansowe w ramieniu, stałej czasowej ramienia, odwrotności pasma wzmacniacza mocy do Voice Coil i okresu próbkowania sygnałów.

Cwiczenie

1.Od lat mikrokontrolery mają różne interfejsy szeregowe o różnym przeznaczeniu i szybkości. Quasi szeregowy sygnał pochodzi też ze starego najprostszego czytnika kodu kreskowego. Mikrokontrolery dedykowane do urządzeń z pilotem zdalnego sterowania mają odpowiedni interfejs otrzymujący sygnał z odbiornika sygnału z pilota. Początkowo scalony nadajnik i dekoder zdalnego sterowania ( jeszcze nie mikrokontroler ) do TVC były bardzo proste ( ale nie ich aplikacja ) ale implementacja Teletekstu w sensownej cenie zmusiła producentów mikroelektroniki do wypuszczenia mikrokontrolerów z interfejsem dekodera RC a pilot miał dużo i coraz więcej klawiszy wraz z rozbudową funkcjonalności TVC i innego sprzętu.

Duże koncerny mikroelektroniczne produkujące też wyroby rynkowe chciały narzucić swoje standardy: Philips RC-5 i później RC-6, Panasonic, NEC, Sharp, Motorola, Thomson, RCA.... Dokumentacje w załączeniu. Czyniono tak w nadziei że nabywcy kupią całą linie urządzeń danego producenta aby nie mieć wielu pilotów do obsługi.

Zaletą „standardu” Philipsa był sztywny przydział funkcji urządzenia RTV, odtwarzacza CD lub DVD do kodu i jeden pilot obsługiwał różne urządzenia od różnych producentów stosujących kod RC-5/6. Gdy różne pomysły Philipsa, na przykład zdjęcia na płycie CD ( pomysł był przed jego czasem ), nie chwyciły na rynku, zaleta stała się wadą bowiem kody - klawisze były martwe. Philips nie publikował uaktualnień swojego standardu i obserwując oscyloskopem DSO sygnał z odbiornika RC można było ustalić przydział nowych funkcji do kodu.

Nadajniki zdalnego sterowania stosują tanie rezonatory ceramiczne. Często o częstotliwości 455 i 503 KHz lub innej. Na oscylogramach pokazano napięcie na nadawczej diodzie LED pilota z rezonatorem 455 KHz z różnymi skalami czasu. Pojemność diody LED jest znaczna i trochę ona fajnie nieliniowo w czasie filtruje sygnał na sobie. LED anodą połączony do + baterii i stąd odwrócenie fazy sygnału jako że + baterii połączono z GND oscyloskopu. Pierwsza długa paczka impulsów o częstotliwości 37.92 KHz czyli 455 / 12 służy do ustalenia poziomu AGC w scalonym odbiorniki w urządzeniu jako że poziom odbieranego sygnału bardzo mocno może się zmienić. „Powolny” sygnał z wyjścia odbiornika RC nie ma tylko „wypełnienia” impulsów nośną bowiem jest zdetekowany. Po rozciągnięciu czasu widać że modulacja AM ma faktycznie nośną 37.92 KHz czyli w przybliżeniu 38 KHz.

Już na koniec lat osiemdziesiątych scalono odbiorniki podczerwieni z podczerwoną IR fotodiodą PIN, które w rozwiązaniu dyskretnym były dość skomplikowane mając kilkadziesiąt elementów.

Częstotliwość środkowa filtru w scalonym odbiorniku IR jest zawsze w jego nazwie. W tym wypadku jest to 38. Jest to najpopularniejsza częstotliwość modulacji. Stosowane są także częstotliwości modulacji 30, 33, 36, 40 i 56 KHz.

Z racji wielkomasowej produkcji przemysłowa cena odbiornika IR RC jest zaledwie trochę powyżej 0.1 dolara. -Jaki klawisz naciśnięto na pilocie i jakiego systemu uzyskując pokazany oscylogram ?

-Obserwując oscyloskopem sygnał odbiornika IR RC przyporządkuj numery pilotów do standardów RC

-Jak uzyskuje się kodowanie bifazowe czyli Manchester ?

-Narysuj diagram State Machine do sprzętowego / programowego dekodowania kodu RC-5. SM działa według reguł kodowania dekodowania.

Dla ułatwienia pokazano przykładowe SM dla różnych kodów. ( Przy realizacji programowej wyjście odbiornika RC podano do przerwania mikrokontrolera )

2.Kod kreskowy czyli Barcode opatentowano w USA w 1952 roku. Szerokie i wąskie paski w tym patencie nadrukowane na etykiecie albo wprost na opakowaniu towaru odpowiadają kresce i kropce w kodzie Morsea. Kod ten praktycznie zastosowano dopiero w 1974 roku. Używane są obecnie różne kody.

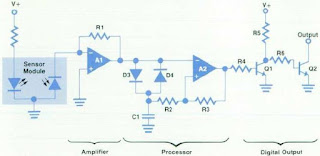

Czytniki kodu kreskowego do mikrokomputera w postaci „pióra” pojawiły się już pod koniec lat siedemdziesiątych. Za specjalnym transoptorem odbiciowym na IR był wzmacniacz prądu fotodiody odbiorczej i analogowy „procesor”. Użyto podwójnego wzmacniacza operacyjnego. Wypracowany sygnał binarny podano do przerwania mikrokontrolera. Mimo prostoty ten czytnik działa co widać na oscyloskopie.

-Opisz algorytm działania analogowego „procesora” czytnika kodu kreskowego pokazanego na schemacie

3.Zapoznaj się ze zdjęciami oraz dokumentacja automatu do sprzedaży i filmem pokazującym jego produkcje.

-Jakich użyto sensorów

-Jakich użyto aktuatorów

-Co to jest MDB Standard ?

-Jakie będą następstwa sytuacji gdy automaty produkują automaty ?

4.Zapoznaj się z Service Manual do ECR – Electronic Cash Register.

-Jak centralny procesor komunikuje się ze swoją klawiaturą - ekranem, wagą, drukarką, czytnikami kodu paskowego, czytnikiem kart kredytowych, modemem ?

-Jakich peryferiów jeszcze nie wymieniono powyżej ?

-Na jakich pamięciach ( numery IC ) wykonano pamięć fiskalną ?

-Czy łatwo jest sfałszować zawartość pamięci fiskalnej ?

-Po co jest pamięć fiskalna skoro ECR najczęściej pracuje w sieci z komputerem

-Omów zasadę pracy laserowego skanera kodu kreskowego

Odnośnie energetyki.

OdpowiedzUsuńW latach 70-tych XX w. zaprzestano ostatecznie badań nad reaktorami bazującymi na stopionych solach fluorków. Gdyby ludzkość poszła tą drogą to, najprawdopodobniej reaktory te byłyby dziś najbezpieczniejszymi, najtańszymi i praktycznie nie emitującymi odpadów źródłami taniej energii elektrycznej. Brak woli decydentów by czerpać z wiedzy A.M. Weinberg'a i jego ekipy, moim zdaniem potwierdza tezę że, nie o klimat i planetę tu chodzi, ale o strzyżenie baranów.

Coraz więcej firm otwiera się na automatykę. Na początku nie zdając sobie może sprawy z tego, jak spore usprawnienia może ona przynieść później doceniamy. W obecnych czasach automatyka jest bardzo często spotykana, tak na prawdę niewielki odsetek firm nie korzysta z nowoczesnych rozwiązań. Musimy iść z duchem czasu.

OdpowiedzUsuń