Laboratorium zaawansowanej elektroniki i automatyki 91

Executive Order 6010 czyli Dekret prezydenta Roosevelta skonfiskował Amerykanom ich złoto nie będące osobistą biżuterią. USA w czasie wojny zgromadziły z handlu ogromną ilość złota od Świata co pozwoliło dać po II Wojnie dolarowi jako walucie światowych rezerw oparcie w złocie. Ostatecznie zlikwidowano je w 1971 roku.

Na wykresie pokazano 200 lat globalnej produkcji złota w poszczególnych krajach świata. „Barbarzyński relikt” był i jest ważny.

To że od amerykańskiej gorączki złota w 1848 roku wzmocnił i utrwalił się wzrost gospodarczy USA nie było wcale przypadkowe !

Rosnące w stalinowskim ZSRR wydobycie złota zatrzymał najazd Niemców.

Gdy Chiny skończyły z szaleństwami Mao i od 1978 roku rozpoczął się ich rozwój od razy zaczęły wydobywać złoto. Zatrudnionych jest przy tym tylko około 28 tysięcy pracowników.

Yuana jest bardzo mało w rezerwach walutowych świata ale pamiętać należy o tym że dolarem się głównie spekuluje i rabuje! Płatność za realne transakcje handlowe to margines transakcji dolarowych świata.

W 2022 roku nastąpiło zamrożenie rezerw walutowych rosyjskiego banku centralnego. Wszyscy zrozumieli, że Waszyngton może odebrać rezerwy walutowe, komu chce i kiedy chce. Podważono zaufanie do dolara.

Zanim obecny światowy ład pieniężny przejdzie do następnego etapu ewolucji, mocnej redukcji wymaga wiele zobowiązań niemożliwych do realizacji. W historii działo się to poprzez niewypłacalność lub inflację albo jednoczesną kombinację tych dwóch czynników. Stolik wywraca też wojna.

Najbardziej zaufanie do dolara podrywa jednak drukowanie pierdyliardów dolarów przez FED dla zadrukowania kosmicznego deficytu handlowego USA.

Nie ma już potrzeby dalszego okłamywania skolonizowanych Polaków co do własności gospodarki w Polsce.

https://businessinsider.com.pl/gospodarka/kardynalne-bledy-polakow-na-niemieckim-rynku-polski-eksport-to-dzielo-niemieckich/6jk0zee

"Niby eksport z Polski do Niemiec idzie pełną parą, ale niech nie zmylą nas pozory. Większość to dzieło niemieckich firm, które pobudowały zakłady na terenie naszego kraju."

Plan inwestycyjny Volkswagena na 5 lat opiewa na 180 mld Euro. Firma przestawia się na produkcje elementów do swoich samochodów elektrycznych. Praktycznie nie ma inwestycji w Polsce.

https://moto.rp.pl/na-prad/art38330481-180-mld-euro-w-5-lat-gigantyczny-plan-inwestycyjny-volkswagena

Trwa kryzys demograficzny w wielu krajach. Realna automatyzacja może być lekarstwem na tą chorobę. Port w Tianjin jest całkowicie zautomatyzowany przez Huawei. Praktycznie nie ma pracowników na terenie operacyjnym portu.

W Polsce głoszone prorodzinne slogany populistyczne dały w efekcie pogrom demograficzny.

“Koniec dywidendy demograficznej, inflacja i stagnacja, czy adaptacja technologiczna?” Pytanie bez odpowiedzi.

AI czyni zbędnym osoby z wykształceniem społecznym i humanistycznym. Artykuł „Occupational Heterogeneity in Exposure to Generative AI” , https://papers.ssrn.com/sol3/papers.cfm?abstract_id=4414065 zawiera tabele z 774 zawodami najłatwiejszymi do likwidacji przez AI. Na czele tych zawodów do likwidacji jest telemarketer.

W Polskich urzędach i w parlamencie zasiadają nieomal wyłącznie osoby które mogą być zastąpione przez AI. Premierzy Tusk i Morawiecki są z „wykształcenia” historykami ale wersja historii którą posiadają jest w 90% dezinformacją. Jednostka ma świadomość sytuacyjną i intuicje. Złodzieje po Spółkach Skarbu Państwa rocznie biorą więcej niż zarobili w całym swoim dotychczasowym życiu. Przez 8 lat politycy tyją po 20 kg i otyłym tłuszcz wylewa się na twarzy. Może oni podświadomie wiedzą że czekają ich ciężkie czasy i gdy jest ich 5 minut muszą się nażreć bo to jedyna taka okazja w plugawym podłym życiu.

W tabeli podano życiowe zarobki Bachelor-a ( to tylko w grubym przybliżeniu jest nasz licencjat w naszym systemie nazw ) z całego życia w podziale na zawody/dyplomy. Dodatkowa premia za tytuły MA, PHD i MBA wynosi 30%-75% ale jest nieregularna. Widać jakie zawody są w cenie.

W grudniu 2022 roku pod Bydgoszczą spadł samosterujący manewrujący poradziecki pocisk Ch-55. Ma on 6.03 m długości i waży 2 tony. Napędzany silnikiem odrzutowym ma zasięg do 2800 km. Początkowo miał tylko głowice termojądrowa o mocy 200 KT ale Rosja wyposażyła te pociski też w głowice konwencjonalną circa milion razy słabszą od jądrowej. Wymieniono też sowiecką elektronikę na współczesną.

Elegancko to przemilczano, żeby nikogo nie niepokoić i dalej okradać budżet. Żeby nikt o nic nie pytał. Wszelkie radary niczego nie zarejestrowały ( rzekome śledzenie okazało się kłamstwem ) ale końcowa faza lotu widoczna jest na przypadkowych filmach ze smartfonów. Skompromitowało się Wojsko Polskie ale też i NATO. Pocisk taki leci na wysokości poniżej 100 m i faktycznie śledzić go można z kosmosu lub z samolotu z odpowiednim radarem. Jego ślad termiczny nie jest duży.

Ale cztery i pół miesiąca później, kiedy ludzie znaleźli go w lesie, wojsko go zabrało i „ma hipotezy” !

Państwo pasożytnicze w całej krasie ! Gdyby pocisk był zabłąkany prawdopodobnie by eksplodował. Mógł być bez głowicy jako ostrzeżenie ze strony Rosji - patrzcie jesteście zupełnie bezbronni ! Przestańcie wariować !

"Kupujemy Himarsy, a brakuje obuwia. Przyjeżdża minister i idą poważne pisma, żeby wytrzasnąć jednakowe buty choćby tylko dla kompanii honorowej" W zeszłym roku mundur zdjęło prawie 19 tysięcy żołnierzy.

Pozostaje wiara w cuda.

Duże są różnice w religijności między Zachodem a Wschodem Europy.

Produkowana od 1979 roku podstawowa termojądrowa amerykańska głowica taktyczna W80 ma regulowaną moc do 150 kiloton. Waży 130 kg. Długość 80 cm, średnica 30 cm. Zamontowana jest w bombach lotniczych B61 stacjonujących w Europie. Szacunkowy koszt to co najmniej 40 mln dolarów ale dokumenty National Nuclear Security Administration są mało wiarygodne lub utajnione. Może to być nawet ponad 100 mln dolarów.

Rozwój cywilizacji nie jest liniowy i lokalnie w wielu miejscach świata się ona mocno cofała.

Na rysunku rewolwer sześciostrzałowy z zamkiem kołowym. Niemcy, 1600 rok ! Wojna trzydziestoletnia spustoszyła i lokalnie wyludniła Niemcy. Relatywnie wzmocniło to Francję i w gruncie rzeczy doprowadziło do I i II Wojny.

Archiwum. „Optymalizacja 1

1..Żyjemy obecnie w okresie trzeciej rewolucji przemysłowej. Rewolucji automatyzacji, której napędem są elektronika i komputery.

Człowiek swoimi złożonymi sensorami odbiera informacje od otoczenie. Najważniejszym zmysłem jest wzrok. Słuch służy głównie do komunikacji mową z innymi ludźmi.

Produkowane sensory są bardzo proste na tle sensorów człowieka ale zarazem niesamowicie dokładne. Kombinacja sygnałów z kilku sensorów analogowych lub binarnych jest sensorem Virtualnym.

Philips jako pierwszy oferuje konkurencyjne sensory CCD do małych kamer zamiast Vidikonów. Do użytecznego rozpoznawania obrazów ( mnóstwo potencjalnych zastosowań, najprostsze to odcisk palca i tęczówka oka) z kamery CCD potrzeba procesorów mocniejszych od obecnych 100-1000 razy co według prawa Moore'a dokona się przecież całkiem niedługo !

Sensory człowieka w ogóle nie dokonują pomiarów jakie wykonuje coraz większa ilość przeróżnych sensorów i analizatorów. Obrazy USG czy tomograficzne powstają tylko dzięki elektronice.

System automatyki składa się z sensorów, systemu przetwarzania informacji i aktuatorów.

Koniem roboczym regulacji jest nadal regulator PI-PID z różnymi istotnymi modyfikacjami.

O szybkości ustalenia pętli regulacji decyduje opóźnienie obiektu. Tam gdzie jest ono bardzo duże na tle oczekiwanego ustalenia poziomu wyjścia obiektu, regulacja w pętli zamkniętej traci sens. W systemie OLOF ( Open Loop Optimal Feedback ) obiekt jest odpowiednio sterowany (mierzalne zakłócenia są kompensowane ) w pętli otwartej tak aby uzyskać pożądaną odpowiedź ale dynamika obiektu jest cały czas jest identyfikowany aby znać jego zachowanie. Między innymi ta idea jest stosowana w systemie wielowymiarowym MPC – Model Prediction Control. Na świecie praktycznie większość nowoczesnych rafinerii i zakładów petrochemicznych ( ponad 3000 ) pracuje z systemami MPC. Oczywiście wypracowywane przez MPC wartości zadane są podawane do realizacji licznym regulatorem PI-PID.

Procesy fizyczne i informacyjne na zautomatyzowanym stanowisku pracy sprzedawcy są zupełnie inne niż wykonywane przez sprzedawcę bez automatyzacji. Czytnik kodu paskowego ( w „Sensory Interfejsy i zastosowania” podano schemat samego ręcznego czytnika-skanera kodu paskowego koncernu HP) odczyta kod z opakowania towaru konfekcjonowanego. Towar na wagę momentalnie zważy elektroniczna waga. Sprzedawca musi tylko wybrać rodzaj towaru. Skanero – wago – kasa momentalnie obliczy należność i zaraportuje centralnemu komputerowi sklepu ( jeśli taki jest w systemie ) po zamknięciu szuflady kasy sprzedaż towarów.

Waga takiego systemu może być okresowo zerowana ale tylko w bardzo małym zakresie. Gdy więc sprzedawca naciśnie klawisz polecenia rozliczenia zakupów i otwarcia kasy system może ewentualnie troszkę podzerować wagę ( przykładowo do 0.1% skali ) lub dać ostrzegawczy sygnał sprzedawcy świadczący o tym że coś na wadze jest lub jest ona brudna. System w dwuznacznej sytuacji może się zablokować i odblokować może go tylko uprawiony pracownik.

N.B.Przemysłowych, laboratoryjnych i naukowych zastosowań SG-LC jest naprawdę dużo i Polska w tej mierze bardzo niekorzystnie odstaje od liderów.

Mostki piezorezystancyjne mimo iż mniej dokładne i stabilne od typowych SG-LC mają ponad 10 x razy większą czułości i układ kondycjonera sygnału dla nich jest łatwy i tani.

Cena jednego bitu zapisanego w pamięci masowej maleje i maleje. Twardy Dysk HD jest pojemny i dyspozycyjny ale archiwizacja danych na taśmie magnetycznej jest dziesiątki razy tańsza ale czas dostępu jest setki razy dłuższy.

Parametry procesów (zwłaszcza) w dużej chemii tradycyjnie rejestrowano na wstędze papieru. Już obecnie ich zapis na HD jest tańszy no i bardzo wygodny. Po czasie dane z HD można archiwizować w pamięci taśmowej lub zastąpić nowymi danymi gdy stare są bezużyteczne. Długie zapisy parametrów złożonego procesu są bardzo użyteczne do „nauki” systemu MPC.

W zautomatyzowanej produkcji nowoczesnej, próżniowej, bardzo czystej mikroelektroniki człowiek bezpośrednio nie uczestniczy w operacjach produkcyjnych i nie może uczestniczyć.

Mimo iż postępy z automatycznym rozpoznawaniem sygnałów EKG i ich klasyfikacji są znaczne i optymistyczne to lekarze jeszcze długo będą potrzebni.

Automatyzacja ma podnosić wydajność pracy i dochód narodowy. Nie brakuje nam sprzedawców i automatyzacja tego stanowiska nie jest pilna i w nadchodzących latach nie będzie istotna.

Za to rafinerie i petrochemie mamy prymitywne i cierpi na tym cała gospodarka narodowa. Przykładowo produkcja w Polsce plastików per capita jest mała na tle produkcji w NRD i CSRS a co dopiero RFN. Paliwa silnikowe są zasiarczone co negatywnie wpływa na trwałość silników, środowisko naturalne i zdrowie ludzi. Zatem zastosowanie do nowoczesnej technologicznie – produktowo petrochemii automatyzacji z systemem MPC da nam ogromne korzyści !

Nasz skromny eksport w dużej części finansuje zakupy ropy naftowej za dolary. To co z niej produkujemy duży wpływ na dochód narodowy. Oszczędność zużycia w transporcie towarowym przez silniki Diesla ( benzynowe powinny być dawno wycofane) i osobowym przez silniki benzynowe z elektronicznym wtryskiem paliwa i zapłonem ma duże znacznie.

2.Jaką dynamikę sygnałów można osiągnąć w funkcji napięcia zasilania systemu elektronicznego ? Na dynamikę składa się zdolność operowania słabym sygnałem a z drugiej strony moc na wyjściu. Moc wszystkich źródeł we wszechświecie jest 10E80 razy większa niż najsłabszych zjawisk znanych fizyce. Moc sygnału odbieranego wielkimi kierunkowymi antenami parabolicznymi z sond kosmicznych Voyager może spaść do 10E-19 W. Z przykładów bardziej przyziemnych to moc światła odbieranego w kompletnej ciemności po długiej akomodacji ludzkim okiem i moc sygnału FM odbieranego dobrym radiotelefonem FM na granicy szumu wynosi 2 x 10E-16 W.

Dopuszczalna w USA moc ERP ( Effective Radiated Power czyli z uwzględnieniem zysku energetycznego z kierunkowości anteny nadawczej ) stacji UKF FM wynosi do 50 /100 KW. Wyjściowa ceramiczna „technologiczna” lampa z BeO zasilana jest napięciem anodowym > 3-15 KV. Ale małe lokalne stacje mają już nadajnik tranzystorowy mocy poniżej 200 W z zasilaniem 28V. Moc ERP stacji telewizyjnej na zakresie UHF wynosi aż do 10 MW. Klistron stacji TV-UHF zasilany jest napięciem rzędu 20-60 kV. Oczywiście licencje na potężne moce nadajników wydawane są jednostkowo i niezwykle rzadko. Typowe stacje mają ułamek podanych maksymalnych mocy.

Moc impulsu strategicznego radaru dalekiego zasięgu przekracza 100 MW a napięcie zasilania jest ogromne i dochodzi do 400 KV.

Generalnie im większa jest moc tym większe jest napięcie zasilania i wyjściowe. Ale z części informacyjnej systemu automatyki delikatny sygnał analogowy czy cyfrowy jest dopiero podany do Wykonawcy Mocy.

Częstotliwość graniczna Ft i wzmocnienie prądowe tranzystora bipolarnego wzrastają wraz Uce a jednocześnie spada nieliniowa pojemność Cbc. Wzmocnienie rośnie tylko do pewnego prądu kolektora Ic z dalej spada. We wzmacniaczach selektywnych LC, Ft jest równie ważna jak mała pojemność Cbc. We wzmacniaczu pośredniej częstotliwości odbiornika TV zaledwie trzy zoptymalizowane tranzystory BF pracujące z optymalnym prądem Ic z Uce ponad 15V dostarczały wzmocnienia aż >90 db !

Ale w totalnie odmiennej filozofii stopnie wzmacniacza ogranicznika z demodulatorem FM w scalonym układzie TBA120 pracowały z napięciem Ube bliskim zeru. Załączony tranzystor w układzie „ECL” również ma napięcie Ucb bliskie zeru a nawet ujemne. Były różne rodziny układów ECL i mowa o układach Motoroli ( licznie naśladowanych ) które jako jedyne są produkowane na rynek a nie tylko do własnych wyrobów.

Prąd tranzystora bipolarnego rośnie wykładniczo z napięciem Ube które przy średnich prądach w temperaturze pokojowej wynosi 0.7V. Z tego powodu nie można zbudować układu bipolarnego o dobrych parametrach zasilanego napięciem mniejszym od 1.2 V czyli napięcia ogniwa akumulatora.

Natomiast w fizyce tranzystora MOS nie ma odpowiednika napięcia Ube i napięcie Ugs czyli i zasilania z jakim może pracować szybki system MOS ( IC zbudowany technologią o dużej rozdzielczości ) może być mniejsze od 1 V ale pojawia się problem znacznego prądu upływu spowodowany zjawiskiem tunelowym. Z kolei wzmocnienie napięciowe takiego tranzystora MOS jest małe co sprawi trudności w konstrukcji układu analogowego jak OPA. Ale pomysłowość ludzka jest nieskończona.

3.Zjawisko starzenia się jest powszechne.

Skutkiem depolimeryzacji celulozy papierowa izolacja transformatorów olejowych starzeje się tym szybciej im wyższa jest temperatura i zawartość wody w oleju. Zależnie od temperatury trwałość tej izolacji spada dwukrotnie przy wzroście temperatury o 6-9 C.

Duże natężenie pola elektrycznego w kablu HV przyśpiesza zmiany w polietylenie izolacji kabla.

Starzeje się też izolacja cieplna z włókien i pianek.

Skutkiem obciążeń dynamicznych rozwijają się w metalowych częściach mikropęknięcia.

Współczynnik rozszerzalności cieplnej metali sprawia że przy zmianie temperatury powstają naprężenie mechaniczne i konstrukcja traci trwałość.

Korozja niszczy metale.

Trwałość elementów półprzewodnikowych spada o połowę przy wzroście temperatury o 7-10 C ale dopiero powyżej ca 30 C bowiem wilgoć też niszczy układy. Zywotność półprzewodnikom skraca też za wysokie napięcie pracy.

Starzeje się wszelka przyroda ożywiona.

Skutkiem starzenia się elementów biernych następuje zmiana ich parametrów.

4.Uchwytny statystycznie rozwój gospodarczy i technologiczny rozpoczął się w połowie XVIII wieku ale już wcześniej przy małych i długich różnicach tempa rozwoju kraje były zróżnicowane w bogactwie.

W dziejach wykształciło się wiele profesji, które już zniknęły - bednarz, cyrulik, druciarz, folusznik, garncarz, karpiniarz, klikon, klucznik, kołodziej, konwisarz, ludwisarz, łaziebnik, maziarz, powroźnik, rymarz, sitarz, zdun. I tak dalej.

Smieszą obecnie stare przewidywania futurystów. Przewidywanie przyszłości jest bardzo ryzykownym zajęciem ale rządy i szefowie koncernów jednak muszą przewidywać przyszłość.

Do sterowania złożonych wielowymiarowych obiektów przemysłowych o bardzo dużym opóźnieniu stosuje się z powodzeniem algorytmy Model Prediction Control. MPC jest z dobrym rezultatem stosowany w nowo budowanych nowoczesnych rafinerach i zakładach petrochemicznych a nawet w modernizowanych. Zatem jednak predykcja czyli przewidywanie ma sens. Coraz lepsze są prognozy pogody.

Niepewność predykcji wzrasta wraz z odległością horyzontu by w końcu zmienić się w bajania futurologów.

5.Optymalizacja rozwoju gospodarczego. Historia gospodarcza świata dostarcza nam różnych przykładów rozwoju krajów Zachodu, USA i Japonii. Wszędzie miała miejsce koncentracji i mobilizacja kapitału ( wszystko jest kapitałem ) i dobra alokacja go w inwestycje. Wszędzie byli premiowani za swój wysiłek wynalazcy, innowatorzy i mądrzy przedsiębiorcy. Wszyscy stosowali i stosują protekcjonizm. Bez sprawnego państwa z jego instytucjami nie ma rozwoju.

Od 1866 roku zaczęło narastać napięcie między Prusami jednoczącymi Niemcy podzielone na bezsilne księstwa a Francją, która chciała temu zapobiec widząc z tym przyszłe zagrożenie swojej pozycji. Napoleon III w 1870 roku wypowiedział Prusom wojnę którą przegrał. Na mocy pokoju frankfurckiego zawartego 10 V 1871 we Frankfurcie, Francja musiała m.in. zapłacić jako odszkodowanie wojenne 5 mld franków w złocie i inne kwoty co dawało 1450 ton złota ! Niemcy te środki zainwestowali w rodzący się przemysł elektrotechniczny, chemiczny, metalurgie i dokapitalizowali banki. Wszystkie wielkie obecne zachodnioniemieckie koncerny i banki otrzymały środki z tych reparacji ! Gdyby te pieniądze skierowano na konsumpcje zakończyłoby się to potężną inflacją i destabilizacją gospodarki. Choć do spekulacji użyto tylko cząstki tych środków i tak doszło do pewnej destabilizacji.

Nasz północny sąsiad jest jednym z najbogatszych krajów świata ale jeszcze w połowie XIX wieku był biedny. Mocny rozwój Szwecji przyniosła dopiero druga rewolucja przemysłowej w okresie 1890-1930. Tak samo jak nazwiska niemieckich, nazwiska szwedzkich wynalazców, innowatorów i przemysłowców stały się znane w całym świecie. Inwestycje finansowała Sztokholmska Giełda Papierów Wartościowych założona w 1866 roku oraz cała sieć banków rzetelnie nadzorowana przez Szwedzki Bank Narodowy stworzony już w 1668 roku. Był on pierwszym bankiem centralnym w świecie. Do finansowania industrializacji pchał się też masowo obcy kapitału. Szwecja przed I Wojną Światową była jednym z większych dłużników w świecie. W czasie wojny szwedzkie firmy handlowały ze wszystkimi i w rezultacie w wojnie Szwecja spłaciła długi i stała się po wojnie jednym z większych wierzycieli świata. Szwecja de facto kolaborowała z Hitlerem i w czasie II Wojny jej gospodarka rozwijała się gdy kontynent legł w gruzach.

W końcu rozsądek zapanował w Chinach i oczywiście zaczęły się one rozwijać !

6. Hasła „optymalna alokacja kapitału w inwestycje” (od niej zależy szybkość rozwoju ) nie da się jeszcze automatycznie przetworzyć w ciąg decyzji.

Wadliwy ustrój gospodarczo – społeczny wyklucza optymalność.

Algorytm programowania liniowego Simplex opracował w 1947 roku George Dantzig. W czasie wojny pracował nad metodami planowania dla US Army a po wojnie usiłował proces zmechanizować. Pod koniec lat pięćdziesiątych algorytm zaprogramowano na komputerach. Na największych maszynach udoskonalony (macierze są bardzo rzadkie ) algorytm rozwiązuje zadania z ponad 10 tysiącami zmiennych !

Simplex i wiele innych algorytmów optymalizacji tworzą gałąź Badań Operacyjnych, która jest w pożytkiem stosowana na Zachodzie a szczególnie w Japonii.

W czasie wojny badacze optymalizowali alianckie naloty na III Rzeszę i kolaborującą z nią Francję.

R.Stark, R.Nichols, Matematyczne podstawy projektowania inżynierskiego, PWN 1979 podaje przykłady stosowania metod optymalizacji.

Procedury optymalizacji są czasem dostępne w bibliotekach. Wydruki trochę starych programów zawiera J.Kucharczyk, M.Sysło, Algorytmy Optymalizacji w języku ALGOL 60, PWN, 1977.

Dlaczego w Polskiej gospodarce metody Badań Operacyjnych nie są stosowane ?

Dlaczego w Polsce metody Optymalizacji w inżynierii nie są stosowane ?

Prawdopodobnie dlatego że trudno jest sensownie sformułować zadanie.

Prawdę powiedziawszy stosowanie w Polsce komputerów w księgowości daje szkody a nie pożytek dlatego że zatrudnienie po „komputeryzacji” działu rośnie ! Między prostackim zastosowaniem komputerów w księgowości a optymalizacją jest przepaść w trudności.

Metody badań operacyjnych usiłuje wdrożyć radzieckie planowanie ale w gospodarkach RWPG ceny są fikcyjne ( one niosą bezcenną informacje ) i zadanie jest niewykonalne. W nakazowo rozdzielczej planowej gospodarce niedoboru i inflacji biurokratyczne ceny są fikcyjne jako szum.

7.Żaden z krajów Zachodu, nawet USA i Japonia, nie jest samodzielny technologicznie i produkcyjnie. Siemens jest potężnym narodowym koncernem elektrotechnicznym RFN. DataBook 1980/81 „ICs for entertaiment Electronics” jest o układach scalonych głównie do TVC i sprzętu Audio. Układy były nowoczesne ale jest ich niewiele ale produkowanych masowo. Oferta IC do systemów elektroniki przemysłowej a w tym automatyki też nie jest duża. Ale są to układy trafione do większych potrzeb. Do mniejszej produkcji finalnej IC są importowane ! Firmy niemieckie niczego tej klasy co AD i BB nie produkują bowiem jest to niecelowe!

Polska to realnie 1/8-1/10 gospodarki RFN. Nasze Cemi jest po prostu dużo za małe aby mieć szeroki asortyment produkcji !

Inicjatorem kontroli technologicznego zachodniego eksportu COCOM są USA ale część krajów słabo przestrzega ograniczeń . Jednym z nich jest Francja prowadząca od zawsze politykę niezależną od USA. Na początku lat siedemdziesiątych kupiliśmy technologie mikroelektroniczną od Francji ale nie potrafiliśmy jej modernizować i rozwijać. Tak samo było z technologią kupioną od Thomsona, RCA, Grundiga, AEG. Zatem bez ulepszenia systemu gospodarczego kolejne zakupy technologii, choć możliwe, nie mają sensu.

Postęp technologi w Polsce polega na imporcie technologii a zatem trzeba wypracować nadwyżki handlowe ze światem. Znów optymalizacja.

8.Co decyduje o poziomie płac w krajach świata ? Decyduje o tym ( dobrze wyjaśniona danymi hipoteza autora ) własny eksportowy sektor dóbr handlowalnych międzynarodowo. Gdy eksportowane są drogie nowoczesne, konkurencyjne na światowym rynku wyroby płace są wysokie jak w Zachodnich Niemczech. Gdy eksportowany jest węgiel ( lub inne surowce ) jak z Polski płace są bardzo niskie.

Nowoczesny eksport mają tylko kraje posiadające silną naukę i zdolność tworzenia nowoczesnej technologii. W Polsce biurokraci udają naukowców.

O rozwój technologi dbają wielkie koncerny które są oczkiem w głowie rządów. Znakomicie rozwój technologiczny w USA pchnął do przodu program kosmiczny Apollo. Produkująca znakomite sensory ( a nawet analizatory ) obecnie duża firma Rosemount mocno wyrosłą na tym programie. Mała demograficznie bogata Szwecja ma silne nowoczesne koncerny „światowe” a wśród nich ASEA. Siemens jest narodowym koncernem elektrotechnicznym Niemiec. USA szybko zdały sobie sprawę że likwidacja niemieckich koncernów uczestniczących w zbrodniach wojennych III Rzeszy zniszczy gospodarkę Niemiec Zachodnich i zrezygnowały z ich likwidacji założonej w procesie denazyfikacji.

Komunały – Tanio kupić i drogo sprzedać, Się nie narobić i dużo zarobić - mają zastosowanie w całych gospodarkach bogatych krajów. Po mechanizacji produkcji i postępach w automatyzacji obecnie w I Świecie zarabia się głową a nie wysiłkiem fizycznym mięśni !

Małe i średnie firmy nie kreują technologi, bogactwa i pozycji kraju. Mimo iż na Zachodzie piekarz, fryzjer, kierowca... zarabia wielokrotnie więcej niż Polak to wykonuje tą samą pracę to jego praca na światową pozycję kraju ma znikomy wpływ.

9.Konstruując urządzenie ( elektroniczne lub z wbudowaną elektroniką ) staramy się minimalizować stosunek kosztów do jakości-funkcjonalności. Wynika to wprost z algorytmu działania firmy kapitalistycznej pragnącej osiągnąć jak największy zysk ze sprzedaży na konkurencyjnym rynku. Dotowana firma socjalistyczna z kolei tak maksymalizuje zadowolenie społeczne i szybkość rozwoju gospodarki. Wymagana minimalna funkcjonalność jest często skwantowana normami państwowymi dla klas urządzeń.

Sformułowanie funkcji jakości – funkcjonalności jest trudne ale bardzo użyteczne.

10.Zachodnioniemieckie normy DIN przykładowo podają minimalne wymagania na sprzęt audio klasy Hi-Fi. Radzieckie normy GOST podają wymagania na sprzęt audio oraz odbiorniki TV i TVC w poszczególnych klasach jakości. Normy tego rodzaju ułatwiają konsumentom orientacja co do stosunku jakości do ceny produktu i podjęcie dobrej decyzji zakupu.

Są normy dotyczące dokładności sensorów.

Normy ( które są obowiązującym prawem ) muszą być stanowione rozsądnie i adekwatne do stanu technologii raju. Przyspieszają on wzrost gospodarczy i ułatwiają wszystkim życie a firmom prace. Normy nierozsądne opóźniają wzrost gospodarczy. Wydaje się że Polska w dziedzinie elektrotechniki winna tłumaczyć lub tylko okładkować międzynarodowe normy IEC.

11. Masowa produkcja o rosnącej wydajności powoduje wzrost dostępności cenowej i upowszechnienie konsumpcji wszelkich towarów i usług.

Najbardziej skomplikowanym masowym produktem elektroniki jest odbiornik telewizji kolorowej. Odbiorniki te mają coraz więcej funkcjonalności a mimo to ciągle realnie w świecie tanieją. Teletext jest systemem cyfrowej łączności komputerowej. Japońskie koncerny elektroniczne eksportują ogromną ilość elektroniki konsumpcyjnej faktycznie likwidując konkurencyjną produkcje jej w Zachodniej Europie i USA. Wschodzącą gwiazdą mikroelektroniki i elektroniki jest Korea Południowa.

Mimo współpracy wojskowej i form współpracy gospodarczej kraje paktu NATO ostro ze sobą rywalizują. Systemy kapitalistyczne Zachodu są dalece różne.

Trzeba szukać dla siebie optymalnej niszy do eksportu.

12.Monolityczne układy scalone upraszczają konstrukcje urządzeń z nimi i umożliwiają produkcje urządzeń o rosnących funkcjonalnościach i spadającej cenie . Komputer CDC6600 miał typowo około 400 tysięcy dyskretnych tranzystorów. Zbudowane z hybrydowych układów scalonych SLT duże komputery IBM S360 miały nawet ponad 20 tysięcy tych układów. Ale jednak najwydajniejsze maszyny w rodzinie S360 zbudowano na monolitycznych, niekomercyjnych układach ECL.

W ZSRR do elektroniki konsumpcyjnej produkowano ( możliwe jest że są jeszcze produkowane ) hybrydowe układy K2xxAxx zawierające monolityczny chip z 6 tranzystorami i płytkę z grubowarstwowymi rezystorami. Byłą to droga donikąd i uruchomiono produkcje monolitycznej linii K174 czyli kopii układów Philipsa i częściowo Siemensa. Zresztą już wcześniej kopiowano wcześniejsze układy monolityczne. Prawo USA zabranie kopiowania masek układów scalonych ale nie zabrania użycia tego samego schematu układu. Jednak zachodni „drudzy” producenci układów scalonych aby nie być pozwanymi z reguły schemat odrobinę zmieniają często ulepszając pierwowzór.

Zresztą koncerny Philips i Siemens w katalogach umieszczały schematy układów scalonych pod warunkiem że mieściły się na dwóch, trzech stronach a budowę ich omawiano w publikacjach koncernów i jej autorów w czasopismach naukowych.

Radziecki odpowiednik pierwszego monolitycznego układu OPA uA702 ma odrobinę zmieniony schemat i nominalnie gorsze parametry katalogowe. Proste radzieckie TTL serii K155 ( jak stare Texas Instruments rodziny 74XX ) miały podawany czas propagacji 20 ns a nie 10 ns jak oryginalne TI ale faktycznie czasy propagacji bywały takie same. Radziecka mikroelektronika ma rzekomo opóźnienie 8-10 lat do zachodniej.

Świadomość tego ze zapóźniona mikroelektronika jest hamulcem rozwoju wydaje się w ZSRR powszechna od dawna. W radzieckim Radio 1979/5 ( dla radioamatorów ) jest dwustronicowy artykuł „Mikroprocesory u nas doma” omawiający zastosowania mikroprocesorów i mikrokontrolerów w sprzęcie RTVC, Audio, grach TV ( program prostych szachów zajmuje rzekomo zaledwie 1 KB pamięci ROM programu), magnetowidach, domowych mikrokomputerach, kuchence mikrofalowej i pralce. W artykułach jest coraz więcej odnośników do zachodniej literatury.

Lata minęły i do tego można dodać tylko Teletekst do TVC.

Koszt projektu i oprzyrządowania sprawia że monolityczne układy są tanie tylko w masowej produkcji.

Radiofonia AM na zakresach fal długich i średnich jest zimnowojennym przeżytkiem. W myśleniu życzeniowym – magicznym potężne centralne radiostacje AM z wielkimi masztami antenowymi przetrwają zaskakujący atak wroga. Jakość odbioru jest niska a pojemność informacyjna tych fal jest znikoma. Siemens od dawna produkuje układ TCA440 ( Philips ma podobny ) odbiornika AM na fale długie i średnie. Ale odbiornik na 3 tranzystorach ma podobne parametry i niewiele więcej tanich elementów. Ale superheterodynę AM może też zrobić na dwóch współczesnych tranzystorach.

Wykonane na zachodzie Europy badania wskazują na znikomą słuchalność radiowych stacji AM.

Mają one racje bytu na ogromnych pustkowiach ZSRR i są dość popularne w odbiornikach samochodowych w USA gdzie gęstość zaludnienia jest mniejsza niż w Europie.

Zatem nie ma celu uruchamianie w Polsce produkcji kopii układu TCA440 lub podobnego.

Należy uruchomić produkcje czegoś z czego jest konkretny pożytek w dużej produkcji.

Technologią monolityczną produkowane są filtry SAW pośredniej częstotliwości do odbiorników TVC. Konstrukcja toru pośredniej częstotliwości jest bardzo uproszczona a jego jakość dzięki SAW dramatycznie wzrasta i możliwe jest ( płaska charakterystyka opóźnienia grupowego i brak zniekształceń sygnału ) użycie dekodera Teletekstu.!

13. Pierwsze układy OPA JFet składały się z monolitycznego bipolarnego OPA z dodaną wejściową parą tranzystorów JFet. Udawało się to zmieścić w obudowie TO100 gdzie typowo był obudowany monolityczny układ scalony OPA lub inny. Wyszły z użytku zastąpione przez układy monolityczne.

Równolegle z rozdzielczością technologii monolitycznej wzrasta rozdzielczość procesu fotolitografii do płyt drukowanych PCB. Bujnie rozwija się technologia montażu powierzchniowego SMD a oferta elementów SMD jest coraz szersza. Nowe modele tranzystorów i układów scalonych mają już równolegle do obudowy klasycznej obudowę SMD. Dawniej elementy SMD nazywane były elementami do układów hybrydowych.

Wydajna linia do montażu elementów SMD na PCB może ich w ciągu godziny zmontować ponad 700 tysięcy. Wydajność pracy skomputeryzowanych maszyn jest więc ogromna a jednostkowy koszt montażu wręcz znikomy. Zatem ich użycie do masowej produkcji na eksport stwarza duże szanse rozwoju. Czyli trzeba znaleźć optymalną nisze dla eksportu.

14.Rynek światowy płaci za produkty nowoczesne i złożone. Coraz mniej płaci za prostą pracę fizyczną i proste produkty.

Są istotne informacje jawne, półjawne i tajne. Znane są schematy różnych scalonych układów analogowych i cyfrowych ale w miarę ich komplikacji wewnętrzne schematy przestają być dostępne. Zresztą już w 1969 roku nie podano schematu ideowego ( na poziomie Q i R ) ALU 74181 rodziny TTL a tylko schemat logiczny.

Znany jest tylko ideowy schemat 4 bitowego mikroprocesora Intel 4004. Układ jest prymitywny.

W naszej próbie produkcji mikroelektroniki skorzystaliśmy z importu linii produkcyjnej od firm z Francji i zakupu kompletów gotowych masek do produkcji. Za zasłoną licencji na amplituner Elizabeth dostaliśmy trochę starych masek od Sanyo. Za zasłoną licencji na kineskop PIL od RCA też dostaliśmy trochę starych masek i prawo do kupowania chipów tranzytów i tyrystorów.

Gdy rynek światowy został zawalony układami do kalkulatorów, które bardzo staniały, racjonalne było tanie kupienie do produkcji na potrzeby kraju kompletu masek i dokumentacji od producenta który się wycofał z tego interesu. Gdy po 1978 roku brakło dolarów na import rozwój Cemi się zakończył.

Polska nie musi produkować mikroelektroniki ale bez jej stosowania w złożonych wyrobach szanse rozwoju i dorównania Zachodowi są małe.

Kraje „rozwijające się” korzystają z renta zapoźnienia i Polska też z niej powinna intensywnie korzystać.

Jednak bez szczegółowych danych optymalny kierunek zmian dla eksportu jest niemożliwy do wyznaczenia.

O rozwoju technologicznym kraju nie decydują piekarnie, fryzjerzy …. ale koncerny.

15.Sensory stanowią istotną część kosztu systemu automatyki przemysłowej. Produkcją ich trudnią się narodowe koncerny elektrotechniczne jak Siemens i giganci jak General Electric i Honeywell oraz duże firmy jak Rosemount. Poważnie o sensorach w Polsce traktuje tylko Z.Trybalski.

Sensory ma też kontroler wtrysku paliwa do silnika samochodowego z mikrokontrolerem a perspektywy zastosowania tanich sensorów monolitycznych są kolorowe.

Wymagana dokładność sensorów jest różna. Sensor pracujący z regulatorem Slave w kaskadzie nie musi być z reguły dokładny. Ale sensory przepływu substancji rozliczanej handlowo ( ropa, paliwa , gaz ,woda ) muszą być dokładne. Sensory są źródłem sygnału o mierzonej (a nawet analizowanej ) wielkości. Drogą nowością jest interface cyfrowy sensora.

Impedancja wewnętrzna sensorów może być bardzo różna.

Źródłem sygnału są też mikrofony.

-Mikrofon wstęgowy o małej oporności daje bardzo mały sygnał zawsze podniesiony transformatorkiem z rdzeniem permalloyowym o ogromnej przenikalności. Moc sygnału za transformatorkiem jest jednak trochę mniejsza.

-Sygnał z mikrofonu dynamicznego o średniej impedancji nie potrzebuje transformatora i można go małoszumnie wzmocnić

-Mikrofon pojemnościowy jest zasilany napięciem stałym rzędu >50V lub używa trwale naelektryzowanego elektretu. Pojemność jest niewielka i impedancja wewnętrzna jest ogromna. Stosowany jest mały tranzystor JFet jako wtórnik źródłowy lub kondensator jest elementem obwodu RF z demodulatorem FM. Sygnał z mikrofonu pojemnościowego ( DC lub elektretowego ) z wtórnikiem jest największy a w złożonym systemie RF sygnał jest dowolny.

Źródłem sygnału są wkładki gramofonowe:

-Impedancja nowoczesnej wkładki Moving Coil jest mała ale mały jest też sygnał i potrzebny jest specjalny układ przedwzmacniacza

-Impedancja standardowej wkładki Moving Magnet jest średnia ale średni sygnał jest łatwy do wzmocnienia

-Impedancja podłej wkładki piezoelektrycznej jest duża ale sygnał sięga 1 Vac !

16.Urządzenia elektroniczne dzielą się na profesjonalne (w tym militarne) produkowane niewielkimi seriami i elektronikę konsumpcyjną produkowaną masowo.

W koszcie elektroniki profesjonalnej dominuje koszt opracowania urządzenia a w tym stworzenia programu dla mikrokontrolera i komputera jeśli jest używany w systemie.

W masowej elektronice konsumpcyjnej dominuje koszt wszystkich elementów elektronicznych i mechanicznych i ich montażu. Nic dziwnego że bardzo mocna w automatyzacji i robotyzacji Japonia swoim eksportem elektroniki wypiera firmy zachodu z ich rynku.

Polska jest dużym światowym eksporterem nienowoczesnej, taniej broni. Bez wyposażenia czołgu T-72 w system kierowania ogniem z dalmierzem laserowym oraz stabilizacją działa stanie się on niesprzedawalny na rynku światowym. Mimo taniości.

Wbudowana elektronika profesjonalna ma obecnie coraz większy wpływ na funkcjonalność i cenę całego urządzenia.

Wyrafinowanym urządzeniem z mikrokontrolerem oraz sensorami jest samochodowy komputerek sterujący wtryskiem paliwa oraz zapłonem. W samochodach jest generalnie coraz więcej elektroniki. Bez tego komputerka samochody na Zachodzie będą niesprzedawalne.

Elektronika profesjonalna jest bardzo droga i z reguły objęta kontrolą eksportu ze strony Zachodu.

Korzyści z automatyzacji są potężne i wysokie koszta szybko się amortyzują.

17.W układach elektronicznych występują następujące szumy fizyczne:

A.Szum termiczny Johnsona ma stałą gęstość widmową. Przypadkowe ruchy elektronów w przewodniku są proporcjonalne do temperatury T. Napięcie tych szumów na przewodniku o oporności R w paśmie B wyraża równanie Nyquista. Szum ten nie zależy od wielkości przepływającego prądu. En=sqrt(4kTRB) gdzie k to stała Boltzmana.

B.Szum Schottky czyli szum kwantowy ma stałą gęstość widmową. Wynika z tego że elektron jako nośnik ładunku w prądzie jest najmniejszą jednostką (=kwantem) ładunku.

Prąd tego szumu generowany przez złącze wynosi In=sqrt((2qI+4qIo)B) gdzie q to ładunek elektronu a I to prąd płynący przez przewodzące złącze lub (tylko jeden z nich ) Io prąd wsteczny złącza.

C.Gęstość widmowa szumu różowego „flicker noise” 1/f rośnie ze spadkiem częstotliwości. Ma on stałą energie w każdej dekadzie lub oktawie. Jego energia w pełnym paśmie częstotliwości od 0 Hz byłaby nieskończona. Źródła tego szumu są dalej częściowo nieznane mimo wysiłku fizyków. W półprzewodnikach powodują go m.in. zaburzenia siatki krystalicznej. Poziom i staranność technologi decyduje o wielkości tych szumów w półprzewodnikach. Występują one też w rezystorach węglowych a w rezystorach drutowych są bardzo małe. Szum 1/f jest proporcjonalny do prądu stałego Idc płynącego przez przyrząd !

Wejściowy napięciowy szum 1/f Mosfetów dominuje przy częstotliwościach niższych od 10-100 KHz i jest ogromny mimo iż dwubramowe Mosfety mają najniższe całkowite szumy w zakresie 10-1000 MHz ze wszystkich elementów aktywnych mając przy tym największe wzmocnienie z możliwością jego regulacji napięciem stałym. W układach bipolarnych szum 1/f dominuje poniżej częstotliwości 1 Hz – 1 KHz a więc różnice w jakości producentów są przeogromne.

W OPA NE5532 do zastosowań Audio przy częstotliwości 1 KHz szum prądowy daje na rezystorze 7 KOhm takie napięcie jakie jest napięcie szumów wejściowych. Ale przy częstotliwości 100 Hz jest to tylko 2.6 KOhm. Szum wejściowych prądów 1/f rośnie zatem znacznie szybciej niż szum napięciowy.

Z uwagi na powolność szumu 1/f można go zapisać rejestratorem używanym w przemyśle na taśmie papieru lub zarejestrować komputerem z przetwornikiem ADC.

Na wykresie pokazano efekt okresowego co 100 okresów autozerowania szumu typu 1/f. Jest to filtrowany dolnoprzepustowo szum nie Gaussowski. Autozerowanie mocno zmniejszyło jego wartość skuteczną.

D.Szumy lawinowe występują przy przepływie prądu przez wstecznie spolaryzowane złącze pn. Są one bardzo duże i mają stałą gęstość widmową. Maleją wraz z przepływającym prądem co wyklucza stosowanie diod Zenera w układach mikromocowych. W układach scalonych najlepiej jest ich nie używać. Można ich użyć jako normalnie nie działających elementów zabezpieczenia.

E.Szumy wybuchowe „popcorn” wzięły nazwę z podobieństwa dźwięku tych szumów do smażonego popcornu. Występują tylko w starszych „brudnych” technologiach półprzewodnikowych.

Nie wszystkie szumy mają rozkład Gaussowski mimo iż dominuje on w zjawiskach przyrody.

Szum Gaussowski o wartości skutecznej 1 chwilowo, średnio (!) przekracza wartość 3 przez 0.3% czasu. Czyli przez 99.7% czasu szum ma wartość mniejszą od 6 peak – peak. Wartość międzyszczytowa p-p jest użyteczna z racji łatwości obserwacji obwiedni procesu !

Z wymienionych szumów tylko szum termiczny Johnsona i szum kwantowy Schottky mają rozkład prawdopodobieństwa Gaussa !

Zakłóceniem jest wszędobylskie pole elektromagnetyczne 50/60 Hz od linii energetycznych oraz fale radiowe. Normy limitują wielkość wytwarzanych zakłóceń radiowych przewodzonych (0.15-30 MHz ) i promieniowanych ( aż do mikrofal ) tak aby były on wielokrotnie mniejsze od nadawanych fal radiowych niosących informacje.

18.W kompletnych ( czyli z sensorem ) systemach pomiarowych ( pomijając nieliniowość ) występuje błąd Zera i błąd Skali.

W układach precyzyjnych zastosowanie technologii MOS / CMOS z racji ogromnych szumów napięciowych 1/f było niemożliwe do czasu pionierskiego zastosowania okresowego autozerowania w układzie miernika CMOS ICL7106 (zerowanie w każdym pomiarze, najczęściej 2 na sekundę ) i wzmacniacza operacyjnego ICL7650 (z reguły 400 Hz).

Najlepszym wzmacniaczom operacyjnym podaje się dryft starzenia. Dryft miesięcznego starzenia wynosi często tyle ile dryft wejściowego napięcia niezrównoważenie na jeden stopień C. Jest on większy niż wynikający z szumu 1/f !

W systemie pomiarowym z sensorem zerowanie ( raz na dzień - rok - 10 lat ) przeprowadza się gdy wielkość fizyczna jest zerowa. Na przykład gdy na wadze nie ma żadnego przedmiotu.

Z wymienionych szumów Zerowanie dotyczy tylko i wyłącznie szumów 1/f o bardzo niskich częstotliwościach. Przede wszystkim pokrywa zmiany starzeniowe elementów systemu.

Algorytm Zerowania można zatem stosować tylko eliminując pozostałe szumy co jest trudne. Zły algorytm jest antytezą Zerowania i powiększa błędy systemu ! Sprawa kompensowania wpływu temperatury jest kontrowersyjna i Zerowanie powinno być przeprowadzone w stanie ustalonym pracy nagrzanego urządzenia.

Zmiany wartości elementów biernych i parametrów układów czynnych skutkują błędami Zera i Skali.

19.Wzmacniacze Operacyjne OPA i Wzmacniacze Pomiarowe IA produkowane są w technologi bipolarnej, bipolarnej z użyciem tranzystorów Super Beta, BiFet, BiMOS oraz CMOS. Względną nowością są wzmacniacze operacyjne CMOS z autorównoważeniem.

Modułowe wzmacniacze elektrometryczne pracowały z modulatorem z diodami pojemnościowymi. Inne wzmacniacze modułowe pracowały z przetwarzaniem sygnału czyli chopper.

Zjawiska szumów generowanych przez tranzystory okazują się nie do końca jasne.

Producenci tranzystorów podaję gęstości spektralne generowanych przez tranzystory wejściowych szumów napięciowych i prądowych zależne od prądów i częstotliwości pracy lub wygodniej współczynnik szumów dla różnych rezystancji źródła sygnału. Tranzystorom ogólnego przeznaczenia szumy podawane są dla częstotliwości akustycznych i trochę większych a dla tranzystorów RF w sugerowanych zakresach częstotliwości ich zastosowań.

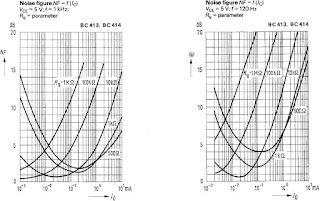

W Siemens Data Book 1980/1981 „Transistors” wykresy szumów dla wszystkich rodzin tranzystorów małosygnałowych BC wydają się te same !

Im wyższa jest częstotliwość 120 / 1000 / 10 KHz pomiarów tym odrobinę większy dla danej Rg jest optymalny prąd kolektora i niższy optymalny współczynnik szumów. Z uwagi na rezystancje rozproszenia bazy Rbb ( zależnie od prądu kolektora Ic sama rezystancja rozproszenia bazy Rbb jest w przedziale 100-500 Ohm ) uzyskanie przy małych opornościach źródeł małych szumów jest niemożliwe. Dla małych rezystancji źródła sygnału Rg mniejsze szumy uzyskamy z tranzystorami o większej powierzchni i z większym prądem kolektora.

Oczywiście w układzie wzmacniacza szumy wnoszą też dalsze stopnie. Jednak w poprawnie skonstruowanym układzie OPA winny one być bardzo małe na tle szumów pary wejściowej. Ta jest w ogromnej większości OPA.

N.B.To że drugi stopień wzmacniacza może wnieść duże szumy nie dociera do polskich konstruktorów sprzętu Audio.

Już przy częstotliwości 120 Hz szumy przy za dużym prądzie kolektora przy dużej rezystancji wejściowej źródła potrafią być duże a nawet wielkie. Dla tych tranzystorów częstotliwość poniżej której dominują szumy typu 1/F wynosi poniżej 50 Hz i prawdziwie duże szumy mamy przy małych częstotliwościach rzędu mHz i uHz.

Moc szumów odnosimy do mocy sygnału źródła. Ale chociaż moc sygnału z termopary nie jest mała to nie ma OPA który by miał mały poziom szumów z taką małą opornością źródła.

Szumy typu 1/F w przyrodzie występują w wielu zjawiskach. Badania wskazują że nie ma najmniejszej częstotliwości przy której szumy 1/F przestają rosnąć !

W bipolarnych OPA uA741 prąd emiterów wejściowej pary różnicowej wynosi 15 uA a precyzyjnym LM725 10 uA a w układzie z tranzystorami SuperBeta LM108 wynosi 8 uA. Odpowiedniki tych układów są produkowane w krajach RWPG ale układu LM108 tylko w ZSRR jako K140UD14.

Tylko umownie powyżej częstotliwości 0.1 Hz są szumy a poniżej jej dryfty !

Prezentacja tego jak mocno szumy 1/F potrafią zakłócić pomiar małego napięcia z termopary lub Load Cell (mostek tensometryczny) trafia każdemu do przekonania i uświadamia grozę szumów 1/F ! Producenci podjęli ulepszające technologie monolityczną środki do zmniejszenia szumów 1/F.

Wzmocnienie tranzystorów SuperBeta w układzie LM108 wynosi około 5000 tysięcy i wejściowy prąd polaryzacji wejść układu lM108 wynosi w temperaturze pokojowej 0.8 nA a prąd niezrównoważenia wynosi 0.05 nA z dryftem 0.5 pA / C. Podany na wykresie Offset Error podwaja się przy rezystancjach wejściowych ca 10M Ohm a Drift Error przy ca 8 MOhm ale szumy podwajają się już przy rezystancji ca 150 KOhm !

Lampowe wzmacniacze operacyjne zasilane były napięciem aż +-350 V. Obecnie w systemach część analogowa może mieć zasilanie +-15V a część cyfrowa 5V.

Dla krzemu iloczyn materiałowy Ft x Uceo jest stały co oznacza ze szybkie tranzystory mają małe napięcie Uceo. Generalnie im wyższe jest napięcie Uceo tranzystora bipolarnego tym mniejsza jest jego częstotliwość graniczna Ft i większy czas wyjścia z nasycenia oraz coraz większy obszar quasi nasycenia i mniejsze wzmocnienie prądowe. Ts dla tranzystora o Uceo = 800 V wynosi 10 usec a dla tranzystora o Ft>10 GHz i Uceo=9 V wynosi 1 nsec. Tranzystory o małym Uceo mają duże Ft, duże wzmocnienie prądowe i małe napięcie nasycenia. Są w każdym aspekcie przeciwieństwem tranzytów wysokonapięciowych !

W układach logicznych ECL nowych rodzin Ft tranzystorów przekracza 5 GHz a Uceo tranzystorów wynosi około 10 V. Tak więc zasilane niskim napięciem układy OPA wykonane współczesną technologią o dużej rozdzielczości mogą mieć potencjalnie bardzo szerokie pasmo i małe szumy.

W analogowym regulatorze PID znaczne napięcie zasilania było korzystne dla redukcji błędu całowania I i różniczkowania D. Ale gdy sygnał z sensora podajemy do przetwornika ADC duże napięcia nie są faktycznie potrzebne pod warunkiem odpowiedniej konstrukcji OPA lub IA.

Zakres sygnału 0-5V już pozwala go przetworzyć z dokładnością ponad 16 bitową.

Dla dużych rezystancjach źródeł sygnału lepsze od bipolarnych są wzmacniacze BiFet. Wzmacniacze BiFet z celowo małymi rozmiarami tranzystorami pary JFET z dodatkową dobrze aranżowaną topgate są zdecydowanie najlepsze w grupie „wzmacniaczy elektrometrycznych”

Systemy automatyki mają określony do współpracy z sensorami standardowy sygnał 0..10V, 0/1-5 mA lub 0/4-20 mA. Zasilane energią elektryczną ( w różny sposób ) sensory (a nawet analizatory ) mają zatem własna wbudowaną elektronikę. Wyjątkiem są duże grupy sensorów RTD jak PT100 i termopar ( najczęściej K ) oraz potencjometrów. System automatyki może z nimi pracować bezpośrednio. Sensory te nie mają zatem swojej elektroniki i są znacznie tańsze.

20.Tranzystor polowy złączowy znany był już teoretycznie w 1936 roku ale nie było technologii do wytworzenia użytecznych tranzystorów. Masową ich produkcje podjęto w latach sześćdziesiątych.

Gro produkcji to modele o przeciętnej geometrii. Tranzystory a najczęściej pary różnicowe „Small Geometry” mają bardzo małe wymiary i bardzo małe prądy bramki. W temperaturze pokojowej pary tranzystorów 2N5902...5909 mają przy prądzie drenu Id=30 uA i niedużym napięciu Uds prąd bramki rzędu 0.1 -0.2 pA ! W JFetach występuje prąd jonizacji zderzeniowej i dla małego prądu bramki prąd drenu i napięcie Uds powinny być małe. Szumy rosną z temperaturą. Tranzystory JFet o dużej geometrii mają moc start do 2 W. Prąd bramki tranzystora JFet podwaja się co 10 C i przy wzroście temperatury od 25 C do 125 C rośnie tysiąc razy.

Mniejsze prądy bramek mają tylko Mosfety ale i szumy typu 1/F przy małych częstotliwościach są ogromne a w JFetach znośne. Do ochrony bramki JFeta wystarczy szeregowy rezystor a bramka Mosfeta musi być chroniona elementami aktywnymi ( D i DZ ) które dają „potężny” upływ na tle samej bramki !

Napięcie szumów JFetów spada wraz z rosnąca powierzchnią tranzystora i rosnącym prądem drenu. JFety Small Geometry mają circa 2-3 razy większe napięcie szumów niż seria standardowa. W zastosowaniach do „sensorów elektrometrycznych” te tranzystory także w monolitycznych OPA są nie do pobicia i z zapasem wystarczające.

Zachodnie tranzystory JFet o większej powierzchni niż standardowe jak P8002 Texas Instrument w obudowie TO202 o mocy 2W nie przyjęły się mimo pewnych zalet. Ale japońskie JFety 2SK170 w obudowie TO92 o dużym Idss i dużym nachyleniu pracując z prądem Id=1 mA przy częstotliwości 1 KHz mają współczynnik szumów bliski 0 dB z rezystancją źródła 200 Ohm – 100 KOhm ! Ponieważ powierzchnia jest znaczna i pojemność zwrotna bramki Cdg wynosi aż 6 pF to może być konieczna praca w kaskodzie z tranzystorem NPN. Są ( i podobne , także pary różnicowe ) powszechnie stosowane w japońskim sprzęcie Audio wysokiej klasy i ośmieszają konkurencję.

JFet 2SK170 ma (>1KHz ) i Id=1 mA widmową gęstość szumu napięciowego 0.95 nV/pHz czyli para ma szum 1.41.. x 0.95 = 1.34 nV/pHz. Z większy prądem Id szum jest trochę mniejszy ale przyrost temperatury podnoszącej szumy może zniweczyć ten efekt. Para różnicowa ze „small geometry” JFetami ma 60 nV/pHz ! Zatem różne JFety mogą obsługiwać zarówno źródła sygnału o małej oporności wewnętrznej jak i największej czyli ogromnej.

W masowych małomocowych wzmacniaczach operacyjnych serii TL061,2,4 oraz LF441,2,4 zastosowano w wejściowej parze różnicowej tranzystory o zmniejszonej powierzchni. W rezultacie w temperaturze pokojowej prąd polaryzacji wejść wynosi<5 pA zamiast 30-50 pA jak we wzmacniaczach standardowych. Ale szumy napięciowe są 1.5-2 raza większe.

Fizyka Mosfeta i JFeta używana jest w odkrytych sensorach Biochemicznych:

ADFET: ADsorption FET

ISFET: Ion Sensitive FET

-detection of DNA hybridization

-biomarker detection from blood

-antibody detection

-glucose measurement

pH sensing

ENFET: ENzymemodified FET

ChemFET: Chemical FET

PRESSFET: PRESSure sensor FET

GASFET: GAS sensor FET

CFT:Charge flow transistor

Wadą wzmacniaczy BiMOS i BiCMOS oraz CMOS ( najpopularniejsze są tanie CA3130 i 3140 ) są bardzo duże szumy 1/f.

21.CMOS

Na przełomie lat 60/70 procesor minikomputera zbudowany z układów MSI i LSI (ROM mikroprogramu ) mieszczący się na jednej bardzo dużej płycie drukowanej nazwano mikroprocesorem. Nazwa ta niedługo przylgnęła do scalonych procesorów !

Mikroprocesor Intel 8008 ( późniejszy o dwa lata 8080 jest mocno ulepszony ) zastąpił procesor zbudowany z ponad 100 układów TTL. Na razie scalone mikroprocesory gonią za minikomputerami i komputerami ale gdy je prześcigną powstanie poważne pytanie o architekturę superprocesorów przyszłości !

Technologia PMOS jest najprostsza produkcyjnie i znacznie gęstsza niż bipolarna. W tej samej rozdzielczości tranzystor P jest circa 3 razy wolniejszy niż N i układ PMOS wymaga większego napięcia zasilania. Niemniej technologia PMOS w ilości produkowanych mikrokontrolerów i przeróżnych układów specjalizowanych dominowała przez pewien okres. Proste 4 bitowe mikrokontrolery Texas Instrument rodziny TMS1000 wykonane w technologii PMOS są wystarczające do pralki czy prostego urządzenia z grupy RTVC, gry telewizyjnej, inteligentnej zabawki lub kalkulatora.

W trudniejszej technologi CMOS można wykonać szybki procesor ale także jednocześnie złożony układ analogowy i cyfrowy.

Mankamentem tranzystorów Mosfet są przeogromne szumy 1/f.

W znakomitym układzie miernika ICL7106 w technologii CMOS (zawiera przetwornik ADC z podwójnym całkowaniem ) z ekranem LCD zintegrowano dwa wzmacniacze operacyjnych jako wtórni i jako integrator. Zastosowano autozerowanie co cykl ( 2-3 cykle na sekundę ) przetwarzania. Natomiast w OPA ICL7650 autozerowanie jest z częstotliwością circa 400 Hz co pozwala mocniej zredukować szumy 1/f. Układ ICL7106 produkowany jest masowo ( także w ZSRR ) a mierniki z nim ciągle tanieją mimo dokładania im kolejnych funkcjonalności !

Producent podaje aplikacje ICL7106 dla zakresów napięcia wejściowego 200 mV i 2 V. Na zakresie 200 mV szumy nie powodują zaburzenia wyświetlanego Zera. Ale gdy czułość powiększymy do 100 mV to Zero bywa zaburzane i trzeba się przyjrzeć pętli Autorównoważenia. Ma ona dynamikę 2 rzędu z dodatkowym zerem. Dla podanych zakresów 200 mV i 2 V elementy RC są jak najbardziej poprawne i wiadomo jakie mają być optymalne dla dowolnego zakresu.

Szumy napięciowe tranzystorów Mosfet maleją z powierzchnią i z prądem pracy. Można by wykonać układ ICL7106' z większymi tranzystorami par różnicowych OPA i większym prądem zdolny pracować z zakresem 50 mV lub nawet mniejszym co jest bardzo pożądane dla bezpośredniej pracy z sensorami.

Ale:

-Zwiększony pobór mocy byłby wadą (!) w masowym DVM

-Z uwagi na duża pojemność Cgd zwiększonych tranzystorów par różnicowych konieczna byłaby praca w kaskodach co zmniejszyłoby dopuszczalny zakres napięć wspólnych co redukuje elastyczność aplikacyjną i możliwości zastosowań.

Wniosek jest prosty. Projektanci doskonale wiedzieli do czego dążą chcąc opanować jak najwięcej sektorów rynku ! Dążenie do zysku okazało się zbawienne dla wszystkich !

Układ ICL7106 ma prąd wejścia około 1 pA co pozwala pracować z wejściowym dzielnikiem napięcia o rezystancji aż 10 MOhm. Ale dzięki temu w tanim masowym dzielniku wydziela się znikoma moc i jego dryft skutkiem nagrzania nie występuje. Możliwa jest też prosta ochrona wejść szczególnie w konfiguracji omomierza.

W taki sposób bardzo drogi DVM który był kiedyś tylko dostępny w laboratorium trafił pod strzechy !

Ilość scalanych tranzystorów szybko rośnie. Potrzebna będzie wyobraźnia na nowe nieistniejące jeszcze produkty !

22.OPA i IA

W świecie nowe technologie tworzą firmy kapitalistyczne. Kapitalizm ( jest jego wiele odmian ) cechuje:

-Istotny wpływ właściciela na firmę zainteresowanego wzrostem wartości firmy

-Rynkowa alokacja kapitału inwestycyjnego i kapitału na prace D&R

-Istotny w systemowym działaniu firmy motyw zysku

Poszukuje się, projektuje i produkuje towary poszukiwane przez klientów na rynku.

Optymalizuje się stosunek Ceny do Funkcjonalności.

Stworzenie funkcji Funkcjonalności jest trudne. Faktem jest że różne parametry są częściowo wymienne przy nieprzekraczaniu wartości granicznych przy takiej samej sumarycznej funkcjonalności układu scalonego czy urządzenia.

W czasopismach naukowych i naukowo – technicznych ten temat oceny funkcjonalności, jakże ważnej dla decyzji firmy, praktycznie nie istnieje mimo iż jest ogromnie ważny.

Idea wzmacniacza operacyjnego ( Operational Amplifier = OPA ) powstała razem z wynalezieniem pary różnicowej w 1937 roku. Wzmacniacze operacyjne rozwinęły się w czasie II Wojny Światowej. Lampowe wzmacniacze operacyjne miały w zasadzie tylko wejście odwracające a sygnał był odniesiony do GND systemu. Idea Goldberga przetwarzania sygnału celem zmniejszenia dużego dryfu lampowego wzmacniacza też mogła być stosowana tylko do wzmacniacza odwracającego. Po niedługim okresie dominacji tranzystorowych modułowych różnicowych wzmacniaczy operacyjnych zawitał pierwszy układ monolityczny uA702. W konstrukcji jego doskonale widać ewolucyjny rozwój nauki i technologii. Był częściowo inspirowany konstrukcją układów lampowych.

Stałoprądowe wzmocnienie OPA wynosi 70-140 dB i zmienia się z temperaturą i napięciem zasilania. Charakterystyka jest też mało liniowa.

Małe dryfty uzyskuje się m.in. drogą symetrii różnicowej pary wejściowej i minimalizacją wpływu drugiego stopnia. Duże tłumienie sygnału wspólnego uzyskuje się drogą symetrii pary wejściowej oraz wykorzystaniem dużej oporności wyjściowej tranzystora w układzie WE (zwłaszcza z rezystorem emiterowym Re ) i czasem WB.

Przy identycznych rezystorach kolektorowych i gdy błąd wprowadza tylko para różnicowa (czyli drugi stopień w OPA jest idealny ) wejściowe napięcie niezrównoważenia 1 mV daje jego dryft 3.3 uV/C.

W katalogowych danych OPA im większe jest napięcie niezrównoważenie tym większy jest jego dryft termiczny. W precyzyjnym układzie uA725 o dryfcie 2 uV/C po trymingu napięcia niezrównoważenia do Zera spada on do 0.4-0.6 uV/C ale ulepszonym układzie OP07 przy fabrycznym trymingu w najlepszej odmianie wynosi tylko 0.2 uV/C. Niestety tryming napięcia niezrównoważenia do zera standardowych bipolarnych OPA dryft w części układów zwiększa !

Przy trymingu istnieje napięcia niezrównoważenia przy którym dryft ma najmniejszą wartość. Analiza prowadzi do wniosku że cześć tego napięcia ma taka genezę jak napięcie w źródle BandGap.

Przy identycznych tranzystorach pary różnicowej gdy błąd wprowadzają tylko rezystory kolektorowe ich 1% różnica oporności daje wejściowe niezrównoważanie 260 uV i wynikający z tego dryft temperaturowy.

W przypadku wejściowej pary różnicowej JFET wielkości te są dużo, dużo większe.

W temperaturze pokojowej przy napięciu bramki Up+0.63 V współczynnik temperaturowy prądu drenu Id jest zerowy. Na wykresie dla pary tranzystorów AD3954 ( jest to wariacja monolitycznej pary JFetów 2N3954 ) o Idss=2 mA wynosi on 180 uA. Dla prądu drenu 1 mA współczynnik temperaturowy TC napięcia Ugs wynosi 2.7 mV/C. Ale istotniejsza jest wrażliwość tego TC na prąd drenu. Jak widać przy prądach drenów tej pary około 180uA 1 % różnica w prądach ( na przykład z powodu 1% różnic rezystorów w drenach ) daje dryft napięcia niezrównoważenia 5 uV/C czyli circa 19 razy większy niż dla bipolarnej pary różnicowej. Wykres sugeruje ze korzystna dla dryftu jest praca dużymi prądami drenu ale jest dokładnie odwrotnie bo przecież chodzi o wrażliwość na względne (wyrażone w %) zmiany prądu drenu.

Konstrukcja precyzyjnych OPA BiFet jest złożona a prąd do pary Jetów pochodzi z dokładnych źródeł prądowych !

OPA zawsze pracuje ze sprzężeniem zwrotnym. Wyjątkiem jest stosowanie go jako komparatora.

W dokładnych bipolarnych OPA (uA725 i ulepszony jako OP07, LM108... ) wejściowa para różnicowa ma wyjściowe rezystory kolektorowe o kompromisowej wartości. Mankamentem tego rozwiązania jest małe dopuszczalne napięcie różnicowe.

Złożony wejściowy układ różnicowy NPN+PNP (począwszy od uA741 i LM101 ) lub Darlingtony ma uniwersalnie duże dopuszczalne napięcie różnicowe ale znacznie większy dryfy napięcia niezrównoważenie. W takiej sytuacji zastosowanie na wyjściu pary desymetryzującego lustra prądowego i asymetrycznego stopnia napięciowego nie pogarsza mocno parametrów OPA.

Monolityczny Instrumentation Amplifier ( = IA Wzmacniacz pomiarowy ) powstał znacznie później niż OPA.

IA może być zbudowany z jednego, dwóch lub trzech OPA oraz precyzyjnych rezystorów.

Układ z jednym OPA ma na wejściu ujemnym dużo mniejszą oporność dynamiczną (!) co jest podstawową wadą eliminującą go z wielu zastosowań.

Dla określonej odchyłki rezystancji od idealnej Iloraz wzmocnienia G przez CMRR jest praktycznie stały. Dla G=1 odchyłka wartości jednego rezystora o 0.1% daje CMRR 2000 tysiące czyli 66 dB. Dla wzmocnienia 1000 będzie to 126 dB.

W układzie IA z 3 OPA wyjściowy wzmacniacz jest identyczny do IA z jednym OPA i ma korzystnie wzmocnienie 1 a dwa wejściowe wzmacniacze wzmacniają sygnał różnicowy pozostawiając sygnał wspólny niezmieniony. W implementacji monolitycznej pierwsze frontowe dwa wzmacniacze są bardzo specyficzne i często mają tylko jedną wspólną parę różnicowa i w rezultacie termiczny dryft jest przy dużych G taki jak pojedynczej pary w OPA !

Z punktu widzenia CMRR wysokie (identycznie jak poprzednio ) są wymagania tylko na R2 , R2' i R3 , R3'. Jeśli funkcje CMRR identycznych frontowych wzmacniaczy są identyczne to błędy ( dominujące błędy I rzędu ) od nich się kasują. Gdy przetwornik ADC ma wejście różnicowe ( on sam ma duże tłumienie CMRR ) i toleruje występujące napięcie wspólne to nie stosujemy trzeciego wzmacniacza i do ADC podajemy sygnały Va i Vb z dwóch frontowych wzmacniaczy co potania i upraszcza rozwiązanie!

Rozwiązanie takie eksperymentalnie zastosowano przed podwójnie całkującym 13 bitowym przetwornikiem ADC ICL7109 ( część analogowa podobna jak w ICL7106 ) pracującym z komputerkiem ZX Spectrum. Jako dwóch OPA użyto precyzyjnych układów MAA725 Tesla równoważnych uA725. Z przypadkową LC z 10 metrowym kablem system trzyma Zero całymi dniami. Także po położeniu ciężaru pomiar jest stabilny.

Układ IA z dwoma wzmacniaczami OPA jest statycznie najdokładniejszy i ma najmniejsze szumy ale CMRR szybciej spada w funkcji częstotliwości co może być czasem istotne.

Pierwszym udanym układem monolitycznym IA był układ AD520 z 1973 roku. Poniżej jest jego schemat blokowy.

N.B.Idea kompozycji i pracy IA - AD520 jest łatwa do zastosowania w układzie IA w technologii CMOS.

IA jest na tle OPA bardzo drogi. Monolityczne IA produkuje kilka firm z USA i jeden koncern z Japonii. W krajach RWPG nie są produkowane. Objęte są kontrolą eksportu czyli embargiem.

Wysokie tłumienie sygnału wspólnego CMRR w IA uzyskuje się:

-Stosując w układzie z 2 lub 3 OPA precyzyjne rezystory i OPA o dużym CMRR.

-Wykorzystując w monolitycznym IA jak AD520 dużą oporność wyjściową tranzystora w układzie WE ( zwłaszcza z rezystorami Re w emiterach ujemnego sprzężenia zwrotnego ) i czasem WB oraz dokładne rezystory.

Współczynnik termiczny oporności metalizowanych rezystorów o tolerancji 0.1% wynosi 10-25 ppm/K. Ale współczynnik różnicowy pary (lub większej ich ilości sprzężonych cieplnie ) takich cieńkowarstwowych rezystorów scalonych wynosi poniżej 1 ppm/K co wykorzystuje się m.in. w drabinach R-2R do przetworników DAC nawet 16 bitowych.

Współczynnik termiczny rezystorów o tolerancji 0.01% wynosi poniżej 5 ppm/K a rezystora 1% 50-100 ppm / K. Precyzyjne rezystory są drogie.

Najlepsze własności mają rezystory o średnich wartościach rezystancji. Gorsze parametry mają zarówno rezystory o małych opornościach ja i dużych a szczególnie bardzo dużych.

Pierwszym mostkiem stałoprądowym był układ Wheatstona. Również w XIX wieku powstały także mostki zmiennoprądowe. Zrównoważenie mostka stałoprądowego detekowano czułym galwanometrem świetlnym.

Jeśli mostek ma zasilacz który nie doskonałej izolacji w stosunku do GND układu sygnałowego (lub z tym GND jest połączony) odbierającego sygnał wyjściowy z mostka powstaje problem tłumienia napięcia wspólnego Uc – common. Uc na tle napięcia użytecznego na wyjściu mostka może być bardzo duże.

Zaleta mostka jest mały względny dryft identycznych elementów czyli wykorzystuje on tą samą idee (!) co para różnicowa tranzystorów lub para ( lub większa ilość ) rezystorów.

Na odniesiony do wejścia bilans błędów Zera równoważnego napięcia składa się:

-Wejściowe napięcie niezrównoważanie zsumowane z dryftem termicznym

-Wejściowy prąd niezrównoważania wejść pomnożony przez oporności na wejściu zsumowany z dryftem termicznym oraz iloraz różnic oporności na wejściach pomnożony przez prąd polaryzacji zależny od temperatury

-Zmiany napięcie wspólnego podzielone przez CMRR. Może się ono zmieniać pod wpływem temperatury.

-Napięcie dryftu długoczasowego i prąd dryftu ( to w zasadzie są szumy 1/f na bardzo małych częstotliwościach ) pomnożony przez oporność na wejściu

W typowych zastosowaniach IA z uwagi na małe rezystancje na wejściach błędy powodowane prądami są bez znaczenia.

Bilans błędu minimalizujemy kierując się względami ekonomi czyli redukujemy to co da się tanio zredukować.

W automatyce przemysłowej świata najpopularniejsze są sensory temperatury i ciśnienia / przepływu.

W sensorach ciśnienia stosowane są mostki tensometryczne ale są też inne metody pomiaru.

Natomiast Load Cell służące do pomiaru wagi są na 5 miejscu popularności sensorów ale w Polsce spotykane są niestety rzadko. W automatyzacji są bardzo cenne i użyteczne !

Od 1960 roku obowiązuje w świecie międzynarodowy system miar International System of Units (SI) w którym zdefiniowano siedem podstawowych jednostek: czas, długość, masa, prąd elektryczny, temperatura termodynamiczna, ilość substancji i strumień światła. Wszystkie pozostałe jednostki są pochodnymi tych 7 bazowych.

W odróżnieniu od wcześniejszych systemów nie ma w SI żadnych przedmiotów - jednostek czyli etalonów.

I tak sekunda to okres 9192631771 przejść subtelnych w atomie Cezu 133.

Metr to dystans pokonywany przez światło w próżni w ciągu 1/299792458 sekundy...

W piramidzie systemu światowej metrologii pod SI są narodowe instytuty metrologi a pod nimi laboratoria kalibracyjne ( powinny mieć akredytacje jako dowód rzetelnej pracy ) a pod nimi laboratoria przemysłowe i testowe.

Dla standaryzacji i unikania błędów i nieporozumień wydawane są przez komitety normalizacyjne Słowniki pojęć i objaśnienia.

Znanych jest kilkadziesiąt grup przyrządów pomiarowych i ponad 200 rodzajów przyrządów.

Pierwszym znanym etalonem był wzór długości w Egipcie 29 wieków p.n.e. Próby stosowania jednostek podjęto 3-4 wieki p.n.e.

Wygodny w użyciu system metryczny narodził się we Francji w Czasie Rewolucji Francuskiej. W świecie przyjmowano go do 1875 roku. W Sevre pod Paryżem przechowywano etalony jednostek miar.

Stworzona w 1955 roku międzyrządowa International Organization of Legal Metrology promuje w świecie zunifikowane wymagania i procedury techniczne oraz formaty raportów testów dla wzmocnienia zaufania do pomiarów w handlu. OIML publikuje liczne raporty.

Polskie Normy dla klas przyrządów elektrycznych podają maksymalne błędy (odniesione do FS- Full Scale ):

klasy 0,1 i 0,2 - Przyrządy wzorcowe

klasa 0,5 - Przyrządy laboratoryjne

klasy 1 i 1,5 - Przyrządy do pomiarów przemysłowych

klasy 2,5 i 5 - Przyrządy orientacyjne

Powinny być jednak osobno specyfikowane Błędy Zera i Skali

Na całkowity błąd składa się błąd Zera i Błąd Skali i ewentualnie błąd skwantyzowania. Za błędy mogą odpowiadać różne elementy i systemy a czasem odpowiadają one za oba w różnym stopniu. Stąd też alokacja części całkowitego błędu na Błąd Zera i części na Błąd Skali powinna wynikać z optymalizacji ekonomicznej.

-W przypadku układu miernika CMOS ICL 7106 jako woltomierza / amperomierza prądu stałego DC za Zero odpowiada algorytm autozerowania a błąd skali wynika z błędów ADC z napięciem odniesienia w układzie ICL oraz niedokładności rezystorów dzielnika napięcia i rezystorów do pomiar prądu.

-W przypadku mostka z RTD PT100 niedokładność części rezystorów i niezrównoważenie OPA dają błąd Zera a części błąd Zera i Skali

-W przypadku IA bazującego na OPA niedokładne rezystory dają błąd Zera równy napięciu wspólnemu podzielonemu przez CMRR i jednocześnie błąd skali czyli wzmocnienia

Rozdzielczość najlepszych woltomierzy DVM DC w świecie sięga absurdalnych 8.5 cyfr ( firmy Solartron) ale dokładność jest oczywiście dużo mniejsza. Szczególnie mała jest ona na zakresach zmiennoprądowych.

Polskie licencyjne mierniki cyfrowe z archaicznymi wyświetlaczami NIXIE już tylko tylko śmieszą.

Normy różnych krajów i IEC podają 3 lub 4 klasy dokładności dla sensora PT100 w konwencji błąd Zera (Zero przy temperaturze pokojowej) i błąd skali w %/K.

Normy różnych krajów i IEC podają 2 klasy dokładności ( mogą to być wykresy ) dla różnych termopar w konwencji błąd Zera (Zero przy temperaturze pokojowej) i błąd skali w %/K.

23.Strain Gauge i Load Cell.

Rezystory tensometryczne lub tensometry czyli Strain Gauge (=SG) mogą być wprost swoim podłożem przyklejone do badanej mechanicznej konstrukcji. Regułą jest łączenie ich w mostek pomiarowy. Najczęściej jednak są one fabrycznie przyklejone do stabilnego, odkształcanego mierzoną siłą, odpowiedniego przedmiotu ze stali narzędziowej czy innego metalu i połączone w mostek. Trymowany (szlifowanie) jest zarówno sam ten przedmiot jak i rezystory ( delikatne ścieranie lub laserowo ) mostka. Jest to Load Cell (=LC). Nazwa ta nie ma niestety polskiego odpowiednika.

Ogromna większość mostków tensometrycznych ma rezystancje 350 Ohm. Mniej popularne są oporności 120 i 1000 Ohm. Strain Gauge mają bardzo mały współczynnik temperaturowy oporności i zalecane jest (w przypadku oporności 350 Ohm ) zasilanie 10 V (symetryczne +-5V) przy którym w mostku wydziela się niebanalna moc 286 mW. Gniazdo na Load Cell i wtyk dla kabla połączeniowego są zestandaryzowane ale gniazda i wtyki nie zawsze są stosowane i kabel może być przylutowany na stałe.

Powierzchnia rezystorów SG /LC jest chroniona przed czynnikami środowiskowymi i są one stabilne długoczasowo. Dzienny dryft średnio intensywnie używanego SG-LC wynosi 5-8 ppm.

Wyjściowe Sygnały nazywają się S+ i S- a zasilanie E+ i E- lub Ex+ i Ex- od Excitation. Czasem stosowane połączenia Kelwina do zasilania nazywają się Sen+ i Sen- od Sensing.

Zależnie od zastosowania kabel do Load Cell może być krótki, średni lub długi i o różnym przekroju.

Niech każdy przewód zasilający LC Rp+ i Rp- ma rezystancje Rp. Miedz (są też miedziane sensory RTD ) kabla ma duży dodatni współczynnik temperaturowy rezystancji a rezystory mostka mają znikomy współczynnik. W rezultacie bez środków zaradczych przy stabilnym napięciu zasilania wejścia kabla podwyższenie temperatury kabla powoduje pewien spadek napięcia na samym mostku.

Weźmy dwa skrajne przypadki.

-Niech kabel z przewodami AWG24 o średnicy miedzi 0.5 mm ma długość 50 m czyli długość obu przewodów zasilających wynosi razem 100 m a ich oporność w temperaturze 20C wynosi 8.75 Ohm. Miedź ma współczynnik cieplny oporności +0.386%/K. Z przyrostem temperatury 30 C do 50 C oporność przewodów wyniesie 9.76 Ohma. Zatem z przyrostem temperatury 30 C napięcie spadnie (350 + 8.75) / (350 + 9.76) = 0.997 napięcia w temperaturze 20 C czyli czułość spadła o 0.3%.

-Niech kabel z przewodami AWG18 o średnicy miedzi 1 mm ma długość 5 m czyli długość obu przewodów wynosi 10 m a ich oporność w temperaturze 20C wynosi 0.219 Ohm.....

W tym drugim wypadku spadek czułości spowodowany przyrostem temperatury przewodu o 30 C wydaje się być dopuszczalny.

Czułość SG/LC wynosi tylko 2-4 mV/V napięcia zasilania na pełną, 100% zakresu, siłę.

Wzmacniaczom operacyjnym i Pomiarowym wejściowy dryft napięciowy podaje się w uV/K. Dryft SG/LC podaje się inaczej. Przykładowy dobrej klasy LC o czułości 2mV/V-FS (FS = Full Scale) ma dryft: 0.002% FS per F co w systemie parametrów OPA IA przy zasilaniu 10 V oznacza dryft 0.4 uV/F czyli 0.72 uV/K.

Wyjaśnia się zatem dlaczego dedykowany do Strain Gauge / Load Cell Wzmacniacz Pomiarowy IA ma dryft tylko 0.5 uV/C i jest tak drogi. Ma on tłumienie sygnału wspólnego aż 140 dB ale przy wzmocnieniu >1000.

-Na pierwszym rysunku do kabla zasilającego LC podano napięcie zasilania Vr ( r od reference czyli odniesienia ) i GND. Napięcie odniesienia Vr podano też do przetwornika ADC i system jest ratiometryczny. Przy idealnym mostku napięcie wspólne sygnału wyjściowego wynosi 0.5 Vr i nie zmienia się z temperaturową zmianą rezystancji przewodów Rp+ i Rp-. Zatem wielkie tłumienie sygnału wspólnego CMRR nie jest tu potrzebne. Dla zachowania dokładności kabel do LC musi być krótki lub bardzo krótki i mieć duży przekrój. Użycie do ADC napięcia odniesienia z przewodu Sen+ kompensuje tylko połowę błędu i nie ma sensu.

-W drugim układzie napięcie z połączeń Kelvina Sen+ i Sen- podano do różnicowego wzmacniacza błędu OPA1 do którego podano też napięcie odniesienia Vr. Stabilizowane jest zatem napięcie na samym mostku i wpływ rezystancji Rp+ i Rp- przewodów zasilających jest eliminowany. Rezystory samego wzmacniacza różnicowego z OPA1 nie powinny być małe na tle rezystancji przewodów Rp i Rp-. Przewód Rp- dołączony jest GND systemu. Napięcie wspólne sygnałów za kablem jest sumą połowy napięcia zasilania samego mostka i spadku na rezystancji Rp- przewodu.

Zatem napięcie wspólne zmienia się z temperaturą przewodu i potrzebne jest duże tłumienie sygnału wspólnego CMRR.

Napięcie zasilające na mostku jest stałe w funkcji temperatury a połowa tego napięcia wchodzi do napięcia wspólnego. Pod wpływem temperatury rośnie rezystancja przewodu Rp- i spadek napięcia na niej co wchodzi w sumę napięcia CMRR. Dla przykładowego kabla z przewodami AWG24 o średnicy miedzi 0.5 mm i długość 50 m przy zmianie temperatury o 30 K zmiana oporności wyniosła 0.5 Ohma co przy prądzie zasilania 28.6 mA dało dryft 14.3 mV czyli podobny maksymalnego sygnału z mostka !

Niech ten dryft podzielony przez CMRR IA będzie taki jak dryft termiczny napięcia niezrównoważenia 1 uV/K dla zmiany temperatury 30 K. CMRR ma wynieść tylko 477 razy czyli około 54 dB ! Jeśli CMRR będzie większy to stanie się w bilansie mało istotny.

Nieoczekiwanie wymagane CMRR jest szokująco niskie. Z krótkim grubym kablem sytuacja jest jeszcze bardziej komfortowa !

-W trzecim układzie mostek jest zasilany symetrycznymi napięciami. Na przykład +-5V. Dodatnie zasilanie to Vr. Napięcie z połączeń Kelwina jest sumowane identycznymi rezystorami i podane do wejścia ujemnego wzmacniacza OPA1 wytwarzającego symetryczne ujemne napięcie. Do przetwornika ADC podane jest napięcie z przewodu Sen+. Mimo iż napięcie samego mostka odrobinę zmienia się z temperaturą to czułość całego systemu jest stała i jest on ratiometryczny. Alternatywnie można dodatkowo dodatnie napięcie stabilizować na samym mostku dodatkowym wzmacniaczem z użyciem połączenia Kelwina. Wyjściowy sygnał wspólny jest bliski zeru i tłumienie sygnału wspólnego nie musi być wielkie.

-W czwartym układzie mostek jest zasilany prawie symetrycznymi ( gdy mostek jest symetryczny i nie pobudzony napięcia są idealnie symetryczne ) napięciami. Od góry zasilany jest napięciem Vr. Do przetwornika ADC podane jest napięcie z przewodu Sen+ odrobinę mniejsze od Vr o spadek na przewodzie Rp+. Mimo iż napięcie samego mostka odrobinę zmienia się z temperaturą to czułość całego systemu jest stała i jest on ratiometryczny. Alternatywnie można dodatkowo dodatnie napięcie E+ stabilizować na samym mostku dodatkowym wzmacniaczem z użyciem połączenia Kelwina.

Do ujemnego wejścia wzmacniacza operacyjnego OPA1 podano jedno wyjście mostka i wzmacniacz wytwarza ujemne napięcie zasilania E- takie że sygnał z tego wyjścia mostka jest zerowy. Sygnał z drugiego wyjścia jest wzmocniony przez OPA2 a nie przez IA. OPA1 i OPA2 są identyczne. OPA1 winien pracować z kompensacją dwubiegunową pętli dla najlepszej likwidacji zakłóceń AC. Napięcia wspólnego tu w ogóle nie ma.

-W piątym układzie mostek jest zasilany prądem proporcjonalnym do Ur. Napięcie wspólne zmienia się wraz z napięciem na przewodzie Rp- i wymagany jest wysoki CMRR.

-W szóstym układzie mostek od góry zasilany jest napięciem Ur a od dołu napięciem -Ur wytworzonym odwracającym wzmacniaczem operacyjnym. Do przetwornika ADC podane jest napięcie z przewodu Sen+ Alternatywnie można dodatkowo dodatnie napięcie E+ stabilizować na samym mostku tak ja omawiano wcześniej. Napięcie wspólne jest bliskie zeru i wystarczy dla IA niewielki CMRR

-W siódmym układzie mostek jest zasilany asymetrycznie Vr / GND a wzmacniacz różnicowy z napięć na połączeniach Kelwina rekonstruuje napięcie na samym mostku i ono jest podane do ADC.

Napięcie wspólne wynosi 0.5 Vr i się nie zmienia.

-W ósmym układzie mostek jest z Vr i GND zasilany rezystorami. Ewentualnie (gdy potrzeba ) wzmocniony spadek napięcia na dolnym rezystorze proporcjonalny do prądu zasilania mostka podano do ADC. Napięcie wspólne wynosi 0.5 Vr i się nie zmienia.

-W dziewiątym układzie zasilacz mostka używający połączeń Kelwina (gdy połączenia są długie ) jest izolowany a jedno wyjście mostka połączone jest z GND systemu z ADC. Nie ma sygnału wspólnego. Uzwojenie transformatora izolowanego zasilacza musi być starannie podwójnie ekranowane aby nie przedostawały się do wyjścia mostka zakłócenia. Mimo tego resztki zakłóceń z transformatora usuwa filtr dolnoprzepustowy i rozwiązanie to nie nadaje się do szybkich sygnałów. System nie jest ratiometryczny co jest wadą !

-W dziesiątym układzie zasilacz systemu ADC jest izolowany a jedno wyjście mostka połączone jest z GND tego pływającego, ekranowanego systemu z izolacja transoptorami lub transformatorkami impulsowymi od części cyfrowej.

Uzwojenie transformatora izolowanego zasilacza musi być podwójnie ekranowane aby nie powstawały zakłócenia. Zasilacz mostka używa połączeń Kelwina. System nie jest ratiometryczny co jest wadą !

24.Inne Sensory mostkowe

National Semiconductor kompletne komercyjne grubowarstwowe układy do pomiaru ciśnienia oferuje od 1977 roku a sam katalog o sensorach jest z 1977 roku. Sam mostkowy sensor jest monolityczny. Układ grubowarstwowy zawiera zasilacz, wzmacniacz pomiarowy i układ kompensacji temperaturowej.

Każdy różnicowy sensor ciśnienia można też zastosować w systemie z przewężką do pomiaru przepływu.

Układy NS można stosować w samochodach, automatyce przemysłowej, w diagnostyce maszyn, hydraulice, pneumatyce, w systemach pomp, systemach HVAC, chłodnictwo, oceanografii i w maszynach spawalniczych ale tez w akcelerometrach, altimetrach ( przykład w transponderze ) i Load Cell oraz w zastosowaniach akustycznych i do pomiaru temperatur i do monitoringu kabli HV i NN z izolacją gazową. W urządzeniach medycznych ( pomiar ciśnienia krwi, tympanometr, tonometr, puls, monitoring porodu, wydolność płuc ) te sensory można stosować tam gdzie nie ma krytycznej funkcji podtrzymania życia.

Wspomniany „Pressure Transducer Handbook” jeśli chodzi o aplikacje sensorów jest wart polecenia. Kompletne sensory mają odporne obudowy adekwatne do zastosowań ale cena była niestety wysoka.

Za pewnik można przyjąć że taka kompletna funkcjonalność zostanie w końcu scalona monolitycznie po niskiej cenie co wywoła eksplozje wielkości produkcji sensorów i ich zastsowań.

Ci którzy te zastosowania stworzą sporo zarobią.

Philips w 6 pinowej obudowie DIP z króćcem na grzbiecie oferuje niedrogi monolityczny sensor ciśnienia z piezorezystancyjnym mostkiem tensometrycznym

Przy zasilaniu mostka sensora KP101A o zakresie pomiaru 0-1.2 bar napięciem 5V jego nominalna czułość wynosi 100 mV / bar ze współczynnikiem temperaturowym aż -0.22% / C.

Sygnał wspólny na wyjściu sensora wynosi 0.5 napięcia zasilania i wysokie tłumienie CMRR układu IA jest zbędne.

Zatem temperaturowa kompensacje czułości tego sensora trzeba przeprowadzić programem a system musi mieć też sensor temperatury dostarczający potrzebnej informacji.