Laboratorium zaawansowanej elektroniki i automatyki 30

Automatyzowane są przemysłowe procesy ciągłe, wsadowe i dyskretne. W procesach ciągłych regulowane są głównie strumienie substancji procesowych i energii. Strumień można regulować serwo zaworami lub napędami elektrycznymi zasilanymi z falowników.

Oczywiście kontrolowany proces musi być sprawny i nadawać się do regulacji bowiem z „pustego i Salomon nie naleje”.

System wychwytu dwutlenku węgla i składowania go pod ziemią (CCS) firmy Chevron w zakładzie eksportu skroplonego gazu ziemnego Gorgon w Australii nie działa jak trzeba. Od uruchomienia w 2019 roku zamiast poziomu wychwytu CO2 ponad 80% jest poniżej 30%. Zamiast 15 mln ton CO2 wtłoczono pod Ziemie mniej niż 5 mln ton. Sam system wychwytu pożera energie i produkowanych jest więcej CO2 niż bez niego. Szczególne problemy stwarza regulacja ciśnienia. Proces jest prowadzony ręcznie a nie automatycznie. Według Royal Dutch Shell, aby ograniczyć globalne ocieplenie, w ciągu najbliższych pięćdziesięciu lat należy zbudować około 10 tysięcy dużych obiektów CCS. W 2020 roku było ich mniej niż 50 i żaden CCS nie działa poprawnie.

Niepowodzenia z nową dopiero co opracowywaną technologią nie powinny dziwić. Ale korupcja może doprowadzić do porażek z technologią używaną od 100 lat.

Oddany do użytku w maju 2021 roku, zbudowany kosztem 4.3 mld złotych, a więc bardzo drogo, blok energetyczny mocy 500 MW elektrowni Turów po miesiącu pracy awaryjnie odstawiono. Po wielkim zawale w kopalni węgla brunatnego w 2016 roku węgiel jest gorszej jakości niż „powinien” być. Nowy blok ani przez chwile nie pracował w modzie regulacji automatycznej a sterowali nim „awaryjnie” operatorzy.

Im większe jest opóźnienie w pętli / pętlach regulacji tym gorszy jest efekt regulacji. Prawidłowość ta jednakowo dotyczy obiektów z jednym wejściem i wyjściem jak i skomplikowanych obiektów z wieloma wejściami i wyjściami, szczególnie nieliniowych.

Automatyczne mechanizmy rynku ( nie należy ich blokować ) tam gdzie opóźnienia są małe i sprawna jest infrastruktura rynku działają całkiem dobrze. Warunki te są restrykcyjne i rynek dość często zawodzi. Także rynek pracownika a w szczególności lekarzy. Czas na „wyprodukowanie” lekarza wynosi 7 do 15 lat, zależnie od wymaganych kwalifikacji. Zatem opóźnienie w pętli regulacji jest ogromne i ona nie działa poprawnie. Trzeba stosować optymalne sterowanie w pętli pół otwartej.

Funkcjonowanie ochrony zdrowia wymaga pracy lekarzy, pielęgniarek, ratowników i salowych. Wymaga budynku oraz kosztownego sprzętu diagnostycznego oraz lekarstw. W przypadku Polski sprzęt diagnostyczny i większość lekarstw są importowane a jak wiadomo każdy import księgowo obniża PKB i tworzy ryzyko kursowe i ryzyko destabilizacji waluty.

Polska podobnie jak wiele innych krajów stara się rozwijać imitacyjnie czyli naśladowczo ale selektywnie.

Trudne studia medyczne trwają 6 lat a następnie lekarz przechodzi praktyki i może podjąć specjalizacje. Jeśli w krajach świata brakuje lekarzy to właśnie brakuje lekarzy specjalistów. W części krajów świata uzyskanie II stopnia specjalizacji ( pomijając nazewnictwo i nomenklaturę ) jest trudniejsze niż uzyskanie na uniwersytecie stopnia doktorskiego. Nic dziwnego że rynek ( tam gdzie funkcjonuje) wysoko ocenia prace lekarzy specjalistów bo faktycznie tylko oni są w stanie pomoc mocniej choremu w sytuacji gdy lekarz rodzinny jest systemowym bramkarzem, który ma nie wpuszczać chorych do mocno deficytowych specjalistów. Chory ma zatem do wyboru zapłacić za prywatną wizytę lub uzyskać skierowanie od lekarza rodzinnego i czekać na wizytę u specjalisty nawet kilka lat. Chociaż są już w Polsce prywatne kliniki chirurgiczne to wykonują one tylko drobniejsze zabiegi ponieważ już ich koszt jest prohibicyjnie wysoki. Znaczniejsze zabiegi wykonuje tylko publiczna służba zdrowia.

Najmniej ze służby zdrowia korzystają osoby w średnim wieku, które jednocześnie są największym płatnikiem. Trochę kosztów generują dzieci a najwięcej kosztów generują osoby starsze.

Średnia długość wieku dożycia w Polsce rosła od 30 lat ale 6 lat temu przestała rosnąć i do Zachodu Polsce wiele brakuje w tej mierze.

Zatem widząc 30 lat temu nadchodzący rosnący popyt na lekarzy i usługi należało zmienić parametry systemu i podać sygnał zadany aby:

-Spokojnie latami rozbudowywać bazę materialną i personalną akademii medycznych adekwatnie do rosnącej liczby studentów

-Zwiększać nabór studentów medycyny nie obniżając wymagań i uruchamiając na przykład wspomagające dodatkowe kursy dla aplikujących

-Wprowadzić odpłatność studiów z jednoczesnym „automatycznym” kredytowaniem ( rutynowe zabezpieczenie - nieruchomość lub podżyrowanie rodziców / rodziny ) z umarzaniem kredytu w skali kredyt za każdy rok studiów umarzany po 3 latach pracy. Czyli po 18 latach pracy kredyt jest automatycznie umorzony. Zapobiegłoby to dużemu wyciekowi lekarzy za granicę. Oczywiście lekarz lub jego zagraniczny pracodawca może kredyt spłacić.

Predykcyjne „Pętle regulacji” do osiągnięcia powyższych celów można było zakodować w postaci ustaw i rozporządzeń. Predykcją celu mogły być (i teraz mogą być ) średnie stany znane na „gonionym” Zachodzie ale po uwzględnieniu różnych odmienności w gospodarce, społeczeństwie i środowisku.

Polska jest od 30 lat gospodarką Taniej Siły Roboczej dla zachodnich firm. Zatem alokowanie środków na ochronę zdrowia ( głównie dla osób starszych ) zabranych firmom, pracującym i dzieciom obniżyłoby tempo rozwoju gospodarczego.

Zatem prawdopodobnie celowo nie inwestowano racjonalnie w służbę zdrowia aby populacja starszych emerytów ( im lepsza ochrona zdrowia tym dłuższe życie ) obciążająca społeczeństwo nadmiernie nie urosła.

Małą liczbę urodzin uzyskano mocno, wieloaspektowo pogarszając sytuacje młodych ludzi. Spadki wspomożone zostały zmianami kulturowymi. Młodzi - dorośli mają pracować jako Tania Siła Robocza a nie niańczyć dzieci. Jednorazowa Dywidenda Demograficzna jest przeogromna ale jej wadą jest jej jednorazowość. Doświadczenia ze świata wskazują że luki stanu pracowników nie eliminuje imigracja, szczególnie niskiej jakości.

Automatyzacja była kolejnym ewolucyjnym krokiem po Mechanizacji. Urządzenia mechaniczne osiągnęły całkiem sporą komplikacje. Pierwsze kombajny zbożowe w latach osiemdziesiątych XIX wieku w USA ciągnięte były przez kilkanaście koni. Szybkość mechanizacji rolnictwa była bardzo nierówna i okresami nie było żadnego postępu w budowie maszyn do rolnictwa. W rolnictwie kombajn to ogólnie wieloczynnościowa maszyna rolnicza do zmechanizowanego zbierania plonów:

-zbóż

-ziemniaków i buraków

-bawełny

-ogórków, cebuli, marchwi, kapusty.

-jabłek, malin, porzeczek, agrestu, borówki, orzechów...

Krzaki bawełny czy inne, posadzone rosną równo w rzędach w odległości dokładnie dopasowanej do rzędów kombajnu.

Kamienie na polu na którym pracuje kombajn mogą uszkodzić jego mechanizmy. Mogą też uszkodzić inne maszyny rolnicze. Stąd są też maszyny – kombajny do zbierania z pola kamieni i to nawet niemałych ale duże trzeba wcześniej usunąć.

Chwasty na polach są pielone ręcznie ( temat czeka na automatyzacje ) lub używane są w dużej ilości pestycydy.

W kombajnach stosuje się system:

-automatycznego prowadzenia LPS (Local Positioning System)

-automatycznego prowadzenia GPS (Global Positioning System),

-mapowania plonu

-telemetrię.

W spopularyzowanych w czasie II Wojny Światowej karabinach automatycznych mechanizm napędzany jest energią gazów z ładunku miotającego pocisk. Szybkostrzelne wielkokalibrowe karabiny – działka i działa mają już równolegle pracujące mechanizmy i logikę hydrauliczne. Mechaniczno – hydrauliczne automaty ładujące działa czołgów zastosowano w latach sześćdziesiątych co zwiększyło zdolności bojowe czołgu.

Popularna w świecie włoska okrętowa armata ( długość lufy 62 kalibry ) Oto Melara kalibru 76 mm jest zdolna do prowadzenia ognia z faktyczną szybkością 120 pocisków na minutę. Ma wydajny automatyczny podajnik amunicji. Standardowy zasięg pocisku wynosi 8-16 Km ale ze specjalną amunicją do 40 km. Obecnie armata jest często elementem rozbudowanego systemu elektronicznego razem z działkiem 40 mm i kierowanymi pociskami rakietowymi. Gdy zatnie się automatyczny podajnik armaty 76 mm zadanie bojowe jest scedowane na armatkę 40 mm i pociski rakietowe lub odwrotnie. Energia pocisku działa 76 mm jest stosunkowo mała dlatego ze przy takiej szybkostrzelności nie jest możliwe odprowadzenie większej ilości ciepła z większego ładunku miotającego. Iran po jej rozpracowaniu produkuje sobie tą armatę bez licencji.

Dawniej sensorami kątów w serwomechanizmach ustawiających armaty były resolwery ale od dłuższego czasu używane są też kwadraturowe, impulsowe sensory optoelektroniczne z indexem.

Programowalne „sterowniki” w skomplikowanych urządzeniach mechaniczno – hydraulicznych używane są często do nadzoru i diagnostyki a nie do sterowania. Zanim automat szybko ładujący armatę się uszkodzi wcześniej zostanie wykryty początek anomalii.

Sensorami binarnymi nadzoru są przełączniki krańcowe, kontaktrony ze współpracującymi magnesami, transoptory szczelinowe i odbiciowe, indukcyjne przełączniki zbliżeniowe. Analogowymi sensorami są trwałe potencjometry oraz LVDT.

Nowe przełomowe technologie same z siebie nie przynoszą od razu wzrostu produktywności. Muszą być dopiero użyte w nowych inwestycjach albo w modernizacjach. Muszą zaistnieć w procesach biznesowych. Długo trwało upowszechnienie się maszyny parowej. Elektryczność w fabrykach szeroko zastosowano dopiero po około 20 latach od jej dostępności. Wygodne elektryczne napędy miejscowe wyparły centralną maszynę parową i długi wał napędowy napędzający wiele maszyn kołami i pasami.

Jak słusznie zauważył Noblista Solow komputery były długo niewidoczne w statystyce wydajności pracy. Zastosowane w Polsce w kwitnącej biurokracji komputery początkowo obniżyły wydajność pracy. Dopiero ich praca w rozbudowanych systemach sieciowych dużych firm dała zauważalny efekt.

Teraz algorytmy maszynowego ucznia się, rozpoznawanie obrazów i mowy oraz wielkie zbiory danych czekają na masowe zastosowania w biznesie.

Towary wymyślone i wyprodukowane w mniej lub bardziej zautomatyzowanym procesie trzeba w końcu sprzedać. Markę firmom i krajom buduje się dekadami czasem bardzo dużym kosztem. Japonia masowy eksport kiedyś rozpoczęła tanimi towarami średniej jakości nazywanymi pogardliwie japońszczyzną. Stereotyp ten został jednak szybko unicestwiony ofensywą eksportową towarów najwyżej jakości.

W raporcie Country Index najsilniejszych marek - krajów w świecie firmy Future Brand za 2020 rok, Polska spadła o 11 pozycji, na 55 pozycje. Zestawienie powstaje na podstawie ponad 20 kryteriów, zarówno makroekonomicznych ( na podstawie danych Banku Światowego), jak i badania opinii światowej. Załamanie nastąpiło zatem skutkiem gwałtownego pogorszeniu się postrzegania Polski na arenie międzynarodowej. Podobna sytuacja spotkała Węgry mające również ciągoty autorytarne. W raporcie o soft power państw za 2021 roku Polska jest na niższej 38 pozycji, spadając o trzy pozycje w porównaniu z 2020 rokiem.

Chiny jako marka - kraj są na drugim miejscu w świecie. Wysokiej jakości towary chińskich firm będą niedługo drogie! Tak samo było z Japonią. Gdy tylko zlikwidowana została ofensywą eksportową konkurencja ceny mocno poszły w górę.

W 2000 roku Europa miała 41 ze stu największych firm świata. Obecnie ma tylko 15. Szokujący spadek o 63% w dwie dekady ! W biznesie i polityce podstawowa zasada mówi by nigdy nie dać się złapać na wierzenie we własną propagandę i we własne narracje. Zawsze trzeba być świadomym logiki rządzącej konkretną sytuacją i procesem.

Jak wielki jest awans Chin i upadek USA pokazuje mapka światowego handlu z USA i Chinami. USA silnej niż Chiny handlują ( pomijając artefakty ) tylko z Kanadą, Kolumbią, UK, Francją, Włochami i Finlandią przy czym z krajami europejskimi niedługo nastąpi zmiana lidera.

Europa ma bardzo ważne dla świata firmy i nie rozgrywa tego atutu. Holenderski ASML to największy i najbardziej zaawansowany producent urządzeń do półprzewodników mający praktycznie światowy monopol a „imec” to najbardziej zaawansowany ośrodek badań nad półprzewodnikami na świecie.

Eunuchowaci politycy europejscy pozwalają aby USA grały ich kartami na szkodę Europy – ten zjazd o 63% to efekt tej bierności. USA są już w technologi półprzewodnikowej słabe i wykonują blokady Chin rękami Europy. USA chcą zablokować sprzedaż maszyn ASML do Chin. Przypomnieć należy że bardzo silną kiedyś fińską Nokie rozwalili właśnie Amerykanie.

Czy zastosowania mikroelektroniki i automatyka są pożądane i oczekiwane ?

Według dużego sondażu Fundacji Bertelsmanna z lipca 2021 we Francji, Włoszech, Niemczech, Hiszpanii i w Polsce 67% ludzi wolałoby żyć w przeszłości ! Nowoczesność więc wcale ludzi nie pociąga i uważają że raczej im zagraża niż polepsza życie. Faktycznie poza państwami szybko się rozwijającymi politycy nie oferują żadnego projektu i perspektyw na przyszłość.

Kiedyś postęp technologiczny i zmiany były szybkie co dawało ludziom nadzieje. Gdy popularyzowały się samoloty wszyscy patrzyli optymistycznie na ich prędkość i dostępność przyszłych podróży. Ale naddźwiękowe Concordy wycofano i samoloty latają z ekonomiczną prędkością a liczba pasażerów będzie w programach klimatycznych mocno redukowana.

Jeśli spojrzeć na procesy z odpowiedniej perspektywy to pesymizm jest raczej trochę przesadny.

Jest szansa na zmniejszenie emisji CO2 i innych toksyn. Ludne Chiny zastosowały zbyt restrykcyjną politykę „jednego dziecka” i się demograficznie kurczą. Są opinie że względnie łatwo można ustabilizować populacji Indii. Państw mających dodatnią reprodukcje pokoleń jest szczęśliwie coraz mniej i zaludnienie zatrzyma się na poziomie circa 10 mld ludzi i liczba ta zacznie spadać. Wszędzie tam gdzie do świadomości kobiet dociera że realnie lepsza jest szkoła a po niej praca, gwałtownie maleje przyrost naturalny. A telewizja satelitarna, telefon komórkowy i internet są prawie wszędzie. W Polsce 2019 roku 68% kończących studia magisterskie to dziewczyny ! Nawet w dzikich krajach dotąd powszechne gwałty ( i zpałodnienia) zaczynają być faktycznie karalne. Działają więc stabilizujące wielkość populacji sprzężenia zwrotne.

Co do wojen. Były i są złem ale przynoszą ciekawe efekty uboczne – powstają stabilne byty polityczne mało skonfliktowane z sąsiadami. Szwajcaria potrzebowała wojny domowej z 1847 do zjednoczenia państwa, które po tym jest stabilne. Garibaldi wojną zjednoczył Włochy w królestwo. Potrzebna była wojna francusko – pruska ( wypowiedzieli ją francuscy idioci ) i Bismarck aby zjednoczyć, zniszczone, podzielone i rzucone na kolana przez religijną wojnę Trzydziestoletnią Niemcy. Obecne Niemcy są krajem stabilnym ale za silnym na Europę. Ale zintegrowane Czechosłowacja i Jugosławia się rozpadły. Słowacja i Czechy są stabilne. Większy problem jest z państewkami powstałymi z rozpadu Jugosławii. Mniejszości etniczne w wielu krajach działają jako siły odśrodkowe i chcą dzielić terytorium państw na mniejsze, konfliktowe byty polityczne. Destabilizujące inicjatywy separatystyczne są wszędzie zwalczane przez państwa. Działania Chin temperujące ekstremistów i separatystów są głęboko słuszne.

II Wojna zdeklasowała Europę ale w końcu doprowadziła do zjednoczenia w Unie Europejską. Ma ona wiele wad ale od 76 lat nie było wojny a tylko lokalne konflikty. Rosja rozpacza nad utratą imperium ZSRR ale nie chce dużej wojny a jej rządzący złodziejscy oligarchowie trzymający majątki i nieruchomości na Zachodzi stracą w razie wojny wszystko. Rosja natomiast korzystając ze stwarzanych przez idiotów pretekstów odrywa ( wojna bez wojny ! ) małe kawałki lądu od słabieńkich państw i zamraża konflikt, który w każdej chwil może podjąć. Osłabione państwa upadłe z oderwanymi enklawami stają się z punktu widzenia prawa międzynarodowego „czarną dziura” omijaną przez inwestorów. Gdy Ukraińcy zapowiedzieli morderczą czystkę etniczną na wschodzie kraju, Rosja miała doskonały pretekst aby wkroczyć nogami „powstańców” do Donbasu.

Jedynym agresywnym państwem prącym do wojny są obecnie słabnące USA ale pozostaje mieć nadzieje że nie będzie wojny termojądrowej.

Można mieć nadzieje że ustawodawcy wymogą naprawialność wszelkiego sprzętu i skończy się produkcja krótko żyjącego sprzętu RTV i AGD, który zaśmieca planetę i tworzy statystykę PKB. Rozwiązaniem byłaby też długa, na przykład 10 letnia, gwarancja producenta. Gwarancja taka zmuszająca producenta do starania o jakość produktu mogłaby podnieś cenę sprzętu do 10-15% a więc stosunkowo niewiele.

Ostatnimi laty w Polsce rocznie produkuje się 25 mln pralek i lodówek o wartości 7 mld dolarów co daje firmom na terenie Polski ( Są to głównie firmy zachodnie a nie Polskie. Znaczny jest poziom mechanizacji i automatyzacji produkcji w tych zachodnich firmach ) drugą w Europie i czwartą pozycje na świecie pozycję, jeśli chodzi o czołowych eksporterów sprzętu AGD. Firmy z terenu Polski zaspokajają około 2 % światowego popytu na sprzęt AGD, co daje czterokrotnie większy udział w rynku AGD, niż wynosi 0.5% udział „polskiego” PKB w światowej gospodarce.

„Polskie” firmy specjalizują się w produkcji gotowych sprzętów jak pralki, suszarki do ubrań, zmywarki, lodówki oraz elementy plastikowych do AGD. Niestety duży jest import zaopatrzeniowy co bardziej skomplikowanych i wysokomarżowych elementów jak silnik z inwerterem czy kontroler z wyświetlaczem

„Polski” przemysł AGD zużywa rocznie około 1,3 mln ton surowców z czego stal stanowi 45%.

Fabryki te z Gospodarką Opartą o Wiedzę nie mają nic wspólnego.

Zresztą stan realnej edukacji nie daje punktu wyjścia do GOP. Aż 40 % Polaków nie rozumie tego, co czyta, a kolejne 30 % rozumie to w niewielkim stopniu. Co dziesiąty absolwent szkoły podstawowej nie potrafi czytać. Aż 10 milionów Polaków nie ma w domu ani jednej książki. Analfabetą funkcjonalnym jest co szósty magister w Polsce, najczęściej absolwent płatnych uczelni prywatnych „tego i owego”. Ponad 6 milionów Polaków znajduje się poza kulturą pisma, czyli nie przeczytało nic, nawet artykułu w brukowcu. 40 % Polaków ma problemy z czytaniem rozkładów jazdy czy map pogodowych. Ponad połowa nie rozumie dzienników telewizyjnych. Szkolnictwo zmniejsza udział przedmiotów ścisłych i zajmuje się zupełnie nieważnymi sprawami jak religia. Efektem jest faktycznie zerowa innowacyjność w Polsce. Piloci rządowego samolotu nie rozumieli powagi instrukcji lądowania i rozbili Tu-154M.

Planowana elektryfikacja transportu przyniesie wiele gruntownych zmian. Prawdopodobnie wprowadzenie zakazu rejestracji na terenie całej UE nowych ( być może też używanych ) samochodów spalinowych nastąpi w 2035 roku.

Przykładowo wyciekło że Toyota "wygasi" od 2025 roku fabryki w Wałbrzychu, gdzie powstają silniki spalinowe. Ponieważ układ przeniesienia napędu w EV jest prosty na tle rozwiązania z silnikiem spalinowym ponad 70% pracowników produkujących w Polsce te systemy będzie zbędnych. Firmy na terenie Polski eksportują rocznie części samochodowych za około 15 mld Euro.

Zaawansowanie elektryfikacji jest w Polsce znikome. W Holandii ( czerwiec 2021) jest 66 665 punktów ładowania EV a w dużo większej Polsce 1691 ładowarek.

JATO Dynamic podaje, że przeciętny samochód elektryczny jest obecnie aż o 75 % droższy niż jego odpowiednik z silnikiem spalinowym. Skokowy wzrost cen nowych samochodów spotęguje problem wykluczenia komunikacyjnego tam gdzie zlikwidowano publiczną komunikacje.

Udział w całości sprzedaży samochodów elektrycznych EV jest w Europie jest mocno skorelowany z PKB per capita i ogólnym bogactwem co pokazano na mapce.

Polska nie ma zresztą energii elektrycznej do ładowania dużej ilości samochodów EV.

O poziomie płac w gospodarce zdrowo, długofalowo decyduje głównie poziom technologi sektora dóbr handlowalnych międzynarodowo.

Ze zrewidowanych szacunków OECD na temat PKB na godzinę pracy wynika, że w Europie są 3 grupy wydajności - technologii:

1.Poziom 100% USA: Niemcy, Austria, Szwajcaria czyli niemieckojęzyczni a przy nich sojusznicza Skandynawia, przyboczny Benelux i Francja

2.Około 80% USA: UK, ITA, SPA, FIN

3.Poziom 45-60% USA: Europa Środkowo - Wschodnia, Portugalia, Grecja

Przy czym w ostatniej grupie wydajność windują obce inwestycje i Unijne transfery pomocy a rodzima gospodarka jest przestarzała.

O tym że poziom organizacji społeczeństwa jest w relacji z poziomem jego technologii ( to jeden z przejawów organizacji społeczeństwa ) świadczy wykres pokazujący udział biernych młodych dorosłych w UE którzy ani nie pracują, ani się nie uczą.

Sytuacja u liderów technologi jest o wiele lepsza niż u słabeuszy.

Garstka młodych biernych ma bogatych rodziców płacących za zwiedzanie przez nich świata i inne luksusy. Świadczenia socjalne nie tłumaczą pokazanej bezczynności lub lenistwa młodych. Tam gdzie młodzi są aktywni są one akurat wysokie. Promowanie nieróbstwa z jednoczesnym dojeniem i strzyżeniem, osób reprezentujących wiedzę, przedsiębiorczych i pracowitych jest demoralizujące i niebezpieczne dla każdego systemu.

Każda osoba kończąca edukacje powinna dostać propozycje pracy. Normalną sytuacją w zdrowej gospodarce jest poszukiwanie pracowników przez firmy ale statystycznie bezrobocie i tak istnieje bo niektórzy po prostu nie chcą pracować ale oni nie powinni dostać ani grosza żadnego zasiłku.

Prosty system powinien wskazać osoby z rodzin gdzie wystąpiła naganna bierność zawodowa i podejrzenie dziedziczenia tej patologii i w stosunku do nich trzeba skierować aktywność „urzędniczą”. Wspomniano już o tym że inwestycje w zdrowie i odżywianie dzieci dają gigantyczne (>570% ) stopy zwrotu w aktywności późniejszych dorosłych.

Inwestycja w zautomatyzowaną pomoc w znalezieniu przez młodych pracy może mieć jeszcze większa stopę zwrotu !

W PRL uważano że osoba zdolna do pracy, która nie uczy się i nie pracuje choć ma ofertę pracy, prowadzi pasożytniczy tryb życia czyli pasożytuje na całym społeczeństwa i obniża dobrobyt. Obiboctwo jako okoliczność mocno obciążającą stosowały w wyrokach sądy administracyjne czyli kolegia do spraw wykroczeń i sądy. PRL nie stosował jakichkolwiek form przymusu pracy po 1956 roku ale obiboków twardo zwalczał.

Obecnie realne stopy procentowe są w świecie ujemne. W latach siedemdziesiątych spadała wartość dolara i kredytobiorcom wydawało się że spłacą mniej niż wzięli pożyczki. Wydawało się aż do czasu wielkich stóp procentowych nowego przewodniczącego FED Volckera. Wywrócili się wówczas bankrutujący dłużnicy III Świata i Polska, wpadając w długotrwały kryzys niespłacalnego zadłużenia zagranicznego.

Jedynie człowiek potrafi abstrakcyjnie myśleć. Oznaczmy przez g stopę wzrostu gospodarczego a przez r stopą pożyczek. Jeśli w długim okresie średnio g=r i wzięliśmy pożyczki, na dajmy na to 10% dawnego PKB, to po latach trzeba oddać 10 % obecnego PKB.

Na wykresie pokazano stopy g i r w 60 letnim okresie dla Wielkiej Brytanii. Jak widać średnio g=r ale są okresy z g>r i są okresy g<r.

Tak więc jeśli na pewno będziemy się długo, szybko rozwijać przy tanim pieniądzu inwestycyjnym ( g>r ) to relatywny dług spadnie a jeśli będziemy się wolno rozwijać przy drogim długu to relatywny dług do spłacenia przez dzieci i wnuki wzrośnie ! Przejedzenie długu prowadzi do katastrofy ! Czy 60 - letni horyzont zdarzeń jest właściwy ? Jeśli już to jest za krótki bowiem długi państw są notorycznie rolowane. Polska gierkowskich długów de facto nie spłaciła tylko wzięła nowe pożyczki na ich spłacenie czyli je zrolowała.

W głowach tych którzy uważają że stopy procentowe realnie kontroluje teraz prezes NBP Glapiński wraz ze swoimi blondynami Pixie i Dixie, nie zachodzą procesy myślowe.

W Turcji 19% stopa procentowa nie jest obecnie w stanie powstrzymać głupio wzbudzonej inflacji !

Jądro wielu procesów jest całkiem proste. Bezwymiarowe równanie Lotki-Volterry ma tylko jeden parametr ! Rozwiązanie zależy oczywiście od stanu początkowego.

http://matusiakj.blogspot.com/2014/04/modelowanie-rownanie-lotki-volterry_12.html

„" Uklad dwoch nieliniowych rownan rozniczkowych zwyczajnych pierwszego stopnia Lotki-Volterry pokazuje przykladowo zmiany liczebnosci populacji dwoch gatunków ofiar-prey i drapiezników-predator zywiacych się ofiarami. Jest punktem wyjscia dla innych rownan rozniczkowych.

Oprocz biologi i ekologi stosowany jest nieomal w kazdej dziedzinie fizyki - w mechanice i mechanice kwantowej, hydrodynamice, astrofizyce. W medycynie wykorzystywany jest w neurologi i kardiologi. Stosowany w modelach ekonomicznych od 1965 roku - monopolu, duopolu, oligopolu, konkurencji, popytu, rynku i bezrobocia. Adekwatny do zjawisk w nieomal kazdej galezi gospodarki. Stosowany do modelowania zjawisk chaosu.”

Jak już wcześniej podano wraz z pojemnością pamięci masowych rosną też zbiory danych. Amerykańska NSA „podsłuchuje” ( także polityków europejskich !) lub próbuje szpiegować wszystkich na Ziemi gromadząc przeogromne zbiory danych. Także Emaile i dane z portali społecznościowych. Ale nie są one dalej głęboko analizowane !

Automatyczna analiza spływających on-line raportów i faktur VAT pozwala zapobiec oszustwom na podatku VAT. Ale w Polsce te dane nie są automatycznie analizowane i oszustwa na podatku VAT trwają w najlepsze co jest jedynie dowodem szalonej korupcji para - państwa !

Znane są proste wskaźniki wskazujące firmy dokonujące oszustw na podatku VAT. Przykładowo zapłacony CIT, ZUS pracowników + rozliczenie VAT muszą być dodatnie czyli firma, tak jak wszystkie normalne firmy, ma przynosić społeczeństwu korzyść. Automatyczna decyzja zwrotu podatku VAT wykluczy korupcje no chyba że administrator serwera sfałszuje na nim dane.

W Polsce danych medycznych pracochłonnie wklepywanych do komputerów nikt nie analizuje na potrzeby m.in. optymalizacji terapii i oceny jej sensowności a są one nawet ukrywane. Ktoś ujawnił makabryczne dane o śmiertelności chorych na Covid-19 pod respiratorami przekraczającej 85%.

„Szokujące dane ze szpitala tymczasowego, który został utworzony w Międzynarodowym Centrum Kongresowym w Katowicach. 86 proc. pacjentów z COVID-19, którzy trafili pod respirator w MCK umarło. Na 287 pacjentów pod respiratorem, przeżyło tylko 39 osób”

Łatwo można automatycznie wychwycić rozmaite defraudacje ale w Polsce defraudacje się przestępczo ukrywa !

W sprawie przeciwko oficerowi SOP, który ujawnił kryminalna aferę lotów Kuchcińskiego, kosztującą podatnika dziesiątki milionów złotych, Sąd nie uwzględnił wniosku Prokuratury o zastosowanie tymczasowego aresztowania. Mało tego, Sąd stwierdził brak jakiegokolwiek prawdopodobieństwa popełnienia przestępstwa. To jest kompromitacja zbirów prokuratorów.

Tylko w jednym kraju Europy prowadzenie biznesu jest trudniejsze niż w Polsce – w etatystycznej Francji. Lobbying i korupcja prowadzą do wielkiego gmatwanie przepisów i ukrywania luk dla wybranych.

Kreowana przez parlamenty biurokracja zależy od sprzętu jakim można dysponować w uprawianiu Office Automation.

Liderem w zastosowaniu komputerów w bankowości i administracji były oczywiście USA.

Drukarka wierszowa do centralnego komputera była szybka ale miała mały repertuar znaków i była hałaśliwa. Mogła być uzupełniona o funkcjonalność cięcia pasków papieru i umieszczania ich w kopertach. Jeden w dużym mieście lub województwie komputer obsługiwał dystrybucje prądu, drugi gazu, trzeci ZUS, telefony lub bank. Duża firma miała kadry i płace na komputerze drukującym paski z wyliczonymi wynagrodzeniami dla pracowników. Siłą rzeczy realizowane przepisy prawa nie mogły być skomplikowane.

Drukarka mozaikowa była wolniejsza i trochę hałaśliwa ale z mikrokomputerem mogła już drukować faktury. Ale przełom przyniosły dopiero tanie w eksploatacji, szybkie i względnie ciche drukarki laserowe. Można było komplikować przepisy, drukować i drukować w części małymi literami aby oszukiwać w kapitalizmie oszustw.

W pandemicznym 2020 roku Chiny umocniły się na pozycji największego eksportera świata z udziałem 14,7 %. Udział Stanów Zjednoczonych na drugim miejscu zmniejszył się do 8,1 % Natomiast udział Niemiec w globalnym eksporcie nie zmienił się w 2020 pozostając na poziomie 7,8 %.

Znacznie polepszyła się struktura eksportu Chin. Eksportowano głównie środki ochrony osobistej, sprzęt medyczny, sprzęt wykorzystywanych do nauki i pracy zdalnej oraz produkty związanych z budownictwem i wyposażeniem wnętrz. Eksport maseczek z Chin nie miał konkurencji zaspokajając ponad 90% popytu świata mimo iż próbowano lokalnie uruchomić produkcje co najczęściej się nie udało na czas. Chińscy producenci niezwykle sprawnie rozbudowali swoje moce produkcyjne w oparciu o szybko wyprodukowane maszyny i urządzenia. Sprawność całego łańcucha działań jest zaskakująco wysoka. Zupełnym zaskoczeniem jest eksport przez Chiny … układów scalonych.

Rekordowa różnica między wartością eksportu i importu Chin w 2020 roku wyniosła aż 535 mld dolarów

Według niemieckiej Federalnej Agencji Środowiska każda tona wyemitowanego CO2 spowoduje szkody w wysokości aż 640 euro w 2100 roku. Tak więc pozwolenia emisyjne CO2 będą coraz droższe i droższe. Skutkiem tego średnia cena hurtowa megawatogodziny w Polsce przekroczyła w lipcu 2021 aż 88 Euro.

Od 1 stycznia 2021 roku obowiązuje norma EURO 6d, która przewiduje, że dopuszczalny poziom emisji pojazdów osobowych to 95 g/km. W 2023 roku współczynnik ma zostać zmniejszony. Kolejna norma EURO 7 ma wejść w życie 2025 roku

Komisja Europejska w lipcu 2021 zapowiedziała, że nowy pakiet klimatyczny będzie zakładał dalsze wycofanie uprawień do emisji CO2. Komisja rozszerzy system uprawnień na sektory takie jak transport i budownictwo. Dostawcy paliw będą musieli kupować uprawnienia.

Z uwagi na geografie i wielkość nasłonecznienia generacja PV w Polsce nie będzie duża. Pozostają wiatraki i energetyka jądrowa. Fałszywe nadzieje kierowane są w stronę geotermii z mocą zainstalowaną 76 MWt przy mocy 54000 MWt zbiorowego ciepłownictwa.

"Na obszarze Polski temperatura wód podziemnych na głębokościach do 4 km wynosi od ok. 20 do 95 C. Nie udokumentowano zasobów wysokotemperaturowych, przekraczających 100 stopni. Przeważająca ilość wód termalnych charakteryzuje się niską temperaturą i wysoką mineralizacją, co powoduje, że potencjał wykorzystania energii geotermalnej jest mocno ograniczony... barierą są przede wszystkim wysokie koszty wykonania odwiertów”

Członek zarządu PKN Orlen Jan Szewczak podał, że transformacja energetyczna w Polsce potrzebuje kwoty rzędu biliona złotych. Szewczak podkreśla, że przejście na zieloną energię w Polsce będzie wymagać ogromnych inwestycji w nowe źródła energii i infrastrukturę.

Wydaje się że klasyczna energetyka z zapasem generacji odchodzi w przeszłość.

Bez przymusu prawnego nikt na giełdzie energii, nie kupi nieobliczalnej Zielonej Energi. Słońce świeci tylko w dzień głównie latem i już niewielkie zachmurzenie zmniejsza generacje. Upał czy podniesiona temperatura powoduje spadek generacji do 20%. Wiatr wieje gdy chce.

Ustawa o rynku mocy w art. 18 daje sensowną definicje KWD czyli Korekcyjny Współczynnik Dyspozycyjności. Jest on bardzo zbliżony do intuicyjnego znaczenia.

Prezes URE opublikował w czerwcu 2021 raport „Informacja na temat planów inwestycyjnych w nowe moce wytwórcze w latach 2020-2034”

Dotychczas w Polsce elektrownie na węgiel kamienny i brunatny miały dość wysoki KWD=92,6% czyli poza czasem remontów generują energie elektryczną w ilości na żądanie. Planowane wycofanie węglowych mocy wytwórczych z eksploatacji w tym okresie wynosi około 18,8 GW.

Korekcyjny współczynniku dyspozycyjności KWD dla PV=2,27%, offshore=20,34%, onshore=13,93% ! Są więc okropnie małe i dla PV wydaje się za mały!

Po zamknięciu starych elektrowni węglowych o wysokim KWD w nowym bilansie moc zainstalowaną PV trzeba pomnożyć przez 2.27% czyli 0.0227 ma co wiatraków przez 0.2034 i 0.1393.

W 14,2 GW nowych mocy, które planowo mają być zbudowane, ponad połowa to źródła OZE o niskiej produktywności i małym KWD, czyli elektrownie wiatrowe i fotowoltaiczne co w efekcie da faktyczny przyrost mocy systemu po uwzględnieniu KWD jedynie o 6,9 GW.

Powstaje więc potężna dziura w systemie energetycznym !

Czy ambitne plany UE redukcji emisji CO2 są realne i mają globalny sens ? Przecież Europa wytwarza tylko 8% globalnych emisji.

Sektor ropy i gazu ziemnego (wydobycie, oczyszczenie, transport i ewentualny eksport) w PKB rosyjskiej gospodarki stanowią 15 – 21 % zależnie od światowych notowań cen tych surowców. Ale są najważniejszym przedmiotem eksportu Rosji. Są więc dla Rosji bardzo ważne. W 2020 roku w USA jest to 8%, Norwegii 14%, ZEA 30%, Arabii Saudyjskiej ponad 50%. Państwa arabskie bez eksportu węglowodorów nie mogą istnieć bowiem importują nieomal wszystko łącznie z żywnością.

W Europejskim modelu podatkowym bardzo wysokie podatki od paliw silnikowych są podstawowym wpływem budżetowym. Przy umiarkowanej światowej cenie ropy litr paliwa kosztuje w Norwegi i Holandii ponad 2 Euro. Przy elektryfikacji transportu energia elektryczna będzie musiała być obłożona wysokimi podatkami aby budżet się spinał.

Europa emituje mniej niż USA i Chiny. Problem klimatyczny wywołały USA i szybko rozwijające się Chiny i inne rozwijające się kraje.

Postkolonializm i imperializm blokowały ambicje rozwojowe biednych krajów potężną korupcją elit III Świata, sztucznym zadłużeniem, grabieżą surowców, prowokowaniem konfliktów i wojen, najazdami zbrojnymi, kolorowymi rewolucjami, sankcjami, wywoływaniem przeróżnych kryzysów. Znamienny jest dokument amerykańskiej NED z 1989 roku mówiący o tym że gdy nie uda się „zdemokratyzować” Chin to one długo i szybko się rozwijając stworzą zagrożenie dla interesów Zachodu.

USA chcąc zaszkodzić ZSRR nie wahały się szkodzić wszelkimi sposobami Polsce w odsłonie PRL.

Zachodnia ekonomia nie jest nauką ale elementem dywersyjnej, imperialnej propagandy. Podaje ona „prawdy do wierzenia” niczym religia. Śmieszne jest centralne pojęcie produktywności wyrażonej w dolarach PKB na godzinę pracy. Polski kierowca takiego samego autobusu jak niemiecki kierowca wykonujący identyczną pracę, ma 3-4 krotnie mniejszą produktywność. Przecież to nie jest nauka ale kabaret ! Polski piekarz pracując tak samo, taka samą technologią i z taką samą fizyczną wydajnością jak amerykański ma 4 x krotnie mniejszą produktywność.

Sens ma natomiast porównywanie fizycznej produktywności czyli przykładowo produkcje energii takich samych elektrowni cieplnych na pracownika. Ale nawet w tym wypadku trzeba brać pod uwagę że jedna elektrownia może sama mieć swój serwis czyli pracowników a druga korzystać z usług zewnętrznych firm. Sens ma porównywanie sprawności podobnych elektrowni.

Nie ma żadnego sensu porównywanie wydajności głębinowego wydobycia węgla kamiennego, zwłaszcza z trudniejszych złóż, z wydobyciem odkrywkowym które może być fizycznie stokrotnie wydajniejsze. To jest jak porównywanie arbuza z pszenicą.

Poziom płac stanowiący totalnie o produktywności wyznacza własny, nowoczesny sektor eksportowy. Zrujnowane wojna Niemcy i Japonia szybko stały się wielkimi, nowoczesnymi bogatymi eksporterami. Za nadwyżki eksportowe można kupić w świecie co tylko jest potrzebne.

Jak teraz Zachód może zablokować ambicje rozwojowe biedniejszych krajów ?

Kraje te są głęboko niesamodzielne technologicznie i produkcyjnie. Gdy zachodnie koncerny odmówią tam budowy elektrowni węglowych to mogą je tylko zbudować Chiny, Indie lub Rosja. Indie są zależne od USA a w przypadku wyboru Chin lub Rosji zaatakują tuby imperialnej propagandy i dywersanci. Zachód obecnie atakuje gigantyczny infrastrukturalny plan Jedwabnego Szlaku i nie ma najmniejszego zamiaru niczego alternatywnego budować u biedaków i wyciągać ich z biedy.

W Polsce elektrownie jądrowe mogą wybudować Korea, Chiny, Rosja i Francja. Firmy z USA już dawno straciły kompetencje. Chiny i Rosja odpadają ze względów ideologicznych natomiast Niemcy zablokują budowę przez Koreę. Realnie więc pozostaje Francja, która potrafi zneutralizować akcje Niemiec. Francja elektrownie jądrowe buduje jednak przerażająco długo i bardzo drogo. Realnie polskie podmioty mogą partycypować kapitałowo – właścicielsko w rosyjskiej Bałtyckiej Elektrowni Jądrowej bowiem Rosja nie pozwala nikomu mieszać się do swoich spraw. Potrzebna jest tylko „niedroga” ( na tle kosztu elektrowni ) linia przesyłowa. Otwartą sprawa jest też import energii z Białoruskiej elektrowni jądrowej. Polska w dużej ilości importuje węgiel kamienny z Rosji i nie ma powodu aby nie kupować energii elektrycznej w ilości nie większej niż 10-15% bilansu.

W Polsce i innych krajach III Świata masowo kupowane są tanie samochody używane z Zachodu. Przy silnej redukcji produkcji stali pierwotnej z rudy i koksu w Europie spowodowanej wysokimi opłatami emisyjnymi stal można kupić w Chinach lub Rosji ( gdzie jednostkowa emisja jest większa niż w Europie !) ale już niedługo import będzie obłożony bardzo wysoką, wyrównawczą dopłatą emisyjną. Zamiast „eksportować” używane samochody, trzeba będzie je złomować i w mini - hutach z piecami łukowymi przetapiać złom na nową stal. Proces przetopu ma znacznie mniejszą emisyjność niż produkcja pierwotnego żelaza. Produkcja pierwotnego żelaza potrzebna była głównie u wielkich eksporterów a złom „pracuje” w obiegu zamkniętym recyklingu.

Zużywającym się elementem samochodu elektrycznego jest akumulator którego cena stanowi nawet połowę ceny nowego samochodu. Kupno samochodu EV z wyczerpanym akumulatorem nie ma żadnego sensu.

Programy klimatyczne wprost są wymierzone są w biednych świata. Mają nie budować tanich elektrowni węglowych ! Jak biedacy Indii mają kupować EV za 50 tysięcy dolarów ?

Z powodu zaostrzania norm emisyjnych w ciągu 3 lat ceny nowych samochodów wzrosły o circa 30%.

Średnio sytuowani zachodni użytkownicy zwiększają okres używania samochodu tym bardziej że nie będzie można już samochodów spalinowych rejestrować po circa 2030-2035 roku a jest szansa że nowe samochody elektryczne będą tańsze i lepsze.

W 2020 roku do Polski sprowadzono 848 tysięcy używanych samochodów osobowych. Były one średnio o 2 miesiące starsze od aut sprowadzonych w 2019 roku.

Temat perfidnej blokady rozwoju biedniejszych krajów jest obszerny i tylko go zasygnalizowano.

Zachód ma zatem możliwości blokady awansu i rozwoju światowych biedaków prowadzące do ogromnego wzrostu światowej konsumpcji paliw czyli emisji CO2 i oni słusznie zwracają oczy w stronę Chin. Jednak muszą się liczyć na odwetowy wściekły atak USA, które jednak widocznie słabną. USA po 20 latach od inwazji na Afganistan i okupacji pozostawiły go zrujnowanego i pogrążonego w wojnie wewnętrznej a Talibowie stopniowo obejmują władzę w kraju. Produkcja „eksportowanych” narkotyków wzrosła ponad 10 razy.

Dalmierz laserowy

Idea triangulacji narodziła się w starożytnej Grecji w VI wieku p.n.e. Niestety w Europie idea ta została na długo zapomniana. Idea przeżyła jednak w Chinach. Triangulacja ponownie odżyła w Europie dopiero w XVI wieku.

Długości boków trójkątów w państwowej sieci triangulacyjnej wynosi 25 km i więcej. Oznaczone wierzchołki trójkątów stanowią osnowę geodezyjną czyli układ odniesienia dla państwowej geodezji i kartografii.

Już w XIX wieku uzyskano wyniki triangulacji niewiele odbiegające od współczesnych pomiarów dalmierzami i pomiarów satelitarnych dodatkowo przetworzonych programem komputerowym. Stosowano wielokrotne pomiary w różnych porach dnia i system wielu poprawek. Triangulacja pozwoliła określić kształt kuli ziemskiej i jej wymiary

Wyniki triangulacji używane są w budownictwie infrastrukturalnym, nawigacji, naprowadzaniu, metrologi i astronomii. Dane potrzebne są od dekad precyzyjnej artylerii dalekiego zasięgu i samosterującym pociskom manewrującym.

Współrzędne potrzebne są do wszelkich budów – dróg, linii kolejowych, wodociągów, ropociągów, gazociągów, linii energetycznych, budownictwa mieszkalnego, komunalnego i przemysłowego.

Dopiero IX Konferencja Międzynarodowej Unii Geodezyjnej i Geofizycznej w Brukseli w 1951 zaleciła wprowadzenie we wszystkich krajach świata jednolitego odwzorowania kartograficznego do analitycznego opracowania wyników pomiarów geodezyjnych czyli triangulacji oraz do map topograficznych.

Dobrze ze sprawa ujednolicenia współrzędnych na globie zdaje się zmierzać do unifikacji. Przeliczenia współrzędnych wymagają użycia powolnych funkcji trygonometrycznych.

Działanie dalmierza optycznego polega na obserwacji przedmiotu za pomocą dwu prawie równoległych obiektywów, umieszczonych na kilkumetrowej bazie i pomiarze kąta paralaksy osi optycznych obu obiektywów. Dalmierze optyczne topograficzne po zwiększeniu dokładności stosowano w czasie II Wojny jako artyleryjskie i artyleryjskie przeciwlotnicze.

Radziecki dalmierz przeciwlotniczy DIA-6 z 1945 roku o wadze 205 kg służy do wyznaczenia odległości i wysokości celu, oraz współrzędnych kątowych: azymut i elewacja. Baza wynosi 3 m. Parametry pomiaru: odległość - od 2000 do 50000 m, wysokość - od 200 do 20000 m, elewacja celu --4 - 00 (-24°) to 15-00 (90°). Parametry optyczne: powiększenie - 8x, pole widzenia - 7° 30 '.

Skuteczność obrony przeciwlotniczej z takim dalmierzem była nieomal zerowa. Dopiero wprowadzenia elektronicznego sensora zbliżeniowego do zwalczanego samolotu aktywującego detonator pocisku czyli Fuse oraz radaru z przelicznikiem automatycznie prowadzącego działa radykalnie zwiększyło skuteczność zwalczania wrogich samolotów.

Znacznie dokładniejsze były późniejsze dalmierze mikrofalowe i laserowe.

Wydajny dalmierz powinien mieć nieulotną pamięć do wcześniejszego zapisania współrzędnych przez komputer z danych z opracowanego komputerowego planu i zapisu współrzędnych z pomiarów w terenie.

Dalmierze mikrofalowe są z reguły dalmierzami fazowymi. Generator mikrofalowy wykonywano na klistronie lub generacyjnych diodach mikrofalowych.

Źródłem światła w dalmierzach elektrooptycznych były lampy rtęciowe z modulatorem na falach krótkich ( radiowych ) Kerra a później lasery gazowe a później diody laserowe. Odbiornikiem odbitego światła był fotopowielacz a później lawinowa, powielająca fotodioda – APD.

Zaletą dalmierza z pomiarem fazowym jest bezpieczna, niewielka moc pracującego ciągle nadajnika i duża dokładność. Wadą jest względna powolność pomiaru.

Dalmierz laserowy jest bardzo użyteczny w czołgu. Czasy świetności czołgu dawno minęły i obecnie jest to broń przestarzała, do wycofania i wycofywana. Czołg ma ma oblicza. Jest przede wszystkim bronią ofensywną ale zarazem defensywnym środkiem zwalczania obcych czołgów i innych sił wroga. Czołg jest obecnie bronią bardzo przestarzałą i od lat już nierozwijaną. Na współczesnym polu walki jest narażony na uderzenie inteligentnych rakiet i wczesne wykrycie przez stada dronów, jest tylko ofiarą. W sieci www jest duża ilość filmików z wojny ormiańsko - azerskiej z 2020 roku pokazujących jak drony bezlitośnie niszczą czołgi i opancerzone wozy bojowe. Ani jeden czołg nie zniszczył drona ani mu nawet nie zagroził.

Krytyczna dla siły bojowej czołgu jest orientacja sytuacyjna czyli zdolność wykrycia celu co wspomaga sieciocentryczność i zdolność szybkiego zaatakowania z jak największej odległości. Dalmierz ( o zakresie pomiaru do 5000 m ) zastosowano dopiero w trzeciej generacji amerykańskich czołgów M60A3 produkowanych w okresie 1978 -1982 zastąpionych w roli MBT przez Abramsa.

Zastosowano w nim impulsowy laser ciała stałego. Po rozkazie, sensor wirującego zwierciadła Q przy odpowiednim kącie obrotu poprzez tyrystorek wyzwalał generator wysokiego napięcia aktywujący pompująca lampę błyskową rozładowującą energie z dużego naładowanego przetwornicą kondensatora.

Słabiutki odbity impuls światła przez układ optyczny odbierał fotopowielacz. Szybki sygnał z niego podano do wzmacniacza szerokopasmowego a z niego do detektora pętli AGC i komparatora pomiarowego liczników. Szybko zmieniając napięcia zasilania dwóch ostatnich dynod fotopowielacza w bardzo szerokim zakresie regulowano jego wzmocnienie. Wzmocnienie rosło z czasem od momentu emisji impulsu światła przez laser bowiem impuls wraca coraz słabszy, dodatkowo ograniczając je sygnałem z pętli Automatic Gain Control czyli ARW (Automatyczna Regulacja Wzmocnienia ) aby szumy „świetlne” otoczenia nie przesterowały toru odbiorczego. Poziom AGC czyli odebranych fotopowielaczem szumów był znacznie niższy niż próg działania komparatora. Zakres detekcji odległości był wstępnie wybrany przez obsługę ale ponieważ wracający odbity impuls jest ekstremalnie słaby komparator mógł zadziałać parę razy i w lepszym rozwiązaniu notowano czas każdego „impulsu” ( do trzech ) aby na długim dystansie komputer wybrał najbardziej prawdopodobny czas powrotu impulsu czyli zmierzony dystans. Impuls lasera impulsowego jest niebezpieczny dla oczu żołnierzy.

Czołg ten miał komputer M21 otrzymujący sygnały z dalmierza i z sensorów o położeniu czołgu i jego prędkości, sile wiatru, temperaturze i wilgotności powietrza aby momentalnie optymalnie ustawić serwomechanizmem do precyzyjnego strzału armatę czołgu. System kierowania ogniem ma skomplikowaną optykę i był drogi.

Starcie w Wojnie w Zatoce całkiem niezłych irackich czołgów T72 ale z kiepskim SKO z amerykańskimi sieciocentrycznymi Abramsami z dalmierzem laserowym i systemem kierowania ogniem wykazał miażdżącą przewagę nowoczesnego czołgu. Jednak ogromna większość czołgów T72 poległa atakowana przez helikoptery i samoloty z powietrza.

W ZSRR i w Polsce dalmierz laserowy i lepszy System Kierowania Ogniem miały (?) tylko wybrane czołgi dowódcze T72 ale mało kto je widział. Natomiast znane były części tego dalmierza.

Bardzo skuteczną niemiecką bronią w II Wojnie Światowej było 88 mm działo przeciwlotnicze i przeciwpancerne. Ponieważ ciężki pocisk miał dużą szybkość początkową, działo miało dobrą celność na dużym dystansie co pozwalało ustrzelić kilka czołgów w kolumnie zanim w ogóle zorientowano się gdzie jest mordujący, odległy zamaskowany wróg, który dalej strzelał i niszczył czołgi. Oczywiście najlepszy był atak z boku a nie mało sensowny atak czołowy. To trochę zmodyfikowane działo miał też spóźniony ciężki czołg Tygrys.

W istocie więc Amerykanie wdrożyli w projekcie dalmierza laserowego i komputera doświadczenia z II Wojny – najlepiej jak atakowany nawet nie wie kto go atakuje ! Sowieci swoje błędy zrozumieli po czasie i się poddali słusznie uważając że wojna termojądrowa oznacza zagładę wszystkich i nie ma żadnego sensu.

Czołg miał i ma silny pancerz tylko z przodu. Nowsze Abramsy mają równoważną grubość pancerza: przód kadłuba (dolna słabo pochylona powierzchnia) 550–650 mm, przód kadłuba (górna silnie nachylona pod kątem 80 stopni powierzchnia) 80 mm, burty kadłuba (2/3 górnej powierzchni) 80 mm, burty kadłuba (1/3 dolnej powierzchni w miejscu montażu zawieszenia) 30–50 mm, tył kadłuba 40 mm, dno kadłuba 40 mm, burty wieży 350–400 mm, jarzmo działa 380–400 mm, strop wieży 70–40 mm, tył wieży 40 mm. Większość danych na temat czołgów Abrams jest utajniona i nie są one żadnym cudem.

Inteligentny pocisk rakietowy nie atakuje silnego pancerza czołowego czołgu ale większą część powierzchni gdzie czołg jest mało odporny lub wręcz bezbronny.

Celem racjonalizacji produkcji militarnej oraz planowania operacji militarnych pod koniec II Wojny w Niemczech stworzono Index Siły Bojowej. Dotyczy on sprzętu ale także oddziałów i pododziałów w typowym ich zastosowaniu. Pojęcie to wyszło jednak z użytku z uwagi na utajnienie istotnych danych i trudności w porównaniach.

„Modernizacja armii krajów postkomunistycznych zakończyła się w chwili rozpadu czerwonego imperium. Najnowszym czołgiem, jaki pozostał w tych armiach, jest groźny radziecki

czołg T-72, którego indeks siły bojowej wynosi 225. Indeks amerykańskiego czołgu Abrams M-1 wynosi około 500. Jego poważną wadą są bardzo wysokie wymogi infrastrukturalne. Indeks dość nowoczesnego radzieckiego bojowego wozu piechoty BWP-2 wynosi „tylko” 48. Indeks siły nowoczesnego, w pełni wyposażonego wielozadaniowego samolotu bojowego dochodzi do 10 000. Samolot musi mieć jednak sprawne zaplecze infrastrukturalne, bez którego użyteczność samolotów jest problematyczna. Od 1985 roku armia USA posiada samobieżne wielo - wyrzutnie rakietowych pocisków taktycznych MLRS z satelitarna korekcja toru lotu i naprowadzania. Wyrzutnia MLRS ma indeks 8 080. Indeks siły bojowej rakiet balistycznych z wieloma głowicami termojądrowymi liczy się w milionach.”

Fundamentem siły militarnej jest gospodarka. W okresie II wojny światowej produkcje zbrojeniową w USA, ZSRR, Wielkiej Brytanii i III Rzeszy rozwinięto na ogromną skale. Śmieszyć musi obecne kupowanie kilkudziesięciu samolotów czy 200 czołgów.

Fala radiowa ( oraz światło) przebywa w ciągu circa 3.3 ns jeden metr w powietrzu. W fazowych dalmierzach mikrofalowych i laserowych częstotliwość modulacji amplitudowej fali musi być taka aby pomiar był jednoznaczny czyli tym mniejsza im większy jest mierzony dystans. Można kolejno dla zachowania jednoznaczności i polepszenia rozdzielczości i dokładności zastosować rosnące częstotliwości pomiaru wraz z odpowiednim algorytmem scalenia danych z pomiarów przesunięcia faz.

W fazowych dalmierzach mikrofalowych pomiar przesunięcia fazy uzyskiwano metodą kompensacji poprzez wydłużenie lub skracanie drogi fali pomiarowej lub poprzez wprowadzenie w torze sygnału elektrycznego skalowanych wartości przesunięcia fazy spiralnymi liniami opóźniającymi.

Cyfrowy pomiar przesunięcia fazy licznikami jest tym trudniejszy im wyższa jest częstotliwość sygnału. Na rysunku pokazano rozwiązanie problemu.

Sygnał z generatora wzorcowego o częstotliwości Ww podano do nadawczego lasera i mieszacza 1 a sygnał odebrany z dodatkowym przesunięciem fazy fi ( proporcjonalne do mierzonej odległości ) do mieszacza 2. Do obu mieszaczy podano sygnał z generatora odniesienia ( heterodyny ) Wo o częstotliwości z reguły różnej o kilka ( często 4 lub 5 KHz ) kiloherców. Przesuniecie fazy fi jest takie samo w sygnałach na wyjściach mieszaczy a ich częstotliwość dużo mniejsza i cyfrowy pomiar przesunięcia fazy jest łatwy. Jest jednak pewne ale... Sygnał odbity jest opóźniony i w wyniku pomiaru pojawia się dryft będący funkcją różnicy szumów faz obu generatorów z czego wniosek że wymóg ich stabilności jest proporcjonalny do mierzonej odległości i wymaganej dokładności.

O ile w prostych dalmierzach laserowych małego zasięgu oba sygnały mogą pochodzić z dwóch syntezatorów pętli PLL z tą samą częstotliwością podstawy z rezonatora kwarcowego to dla większych odległości oba sygnały muszą pochodzić z niskoszumnych rezonatorów kwarcowych a różnica częstotliwości ( 4 – 5 kHz) i fazy jest pilnowana pętlą synchronizacji fazowej PLL odrobinkę podstrajającą jeden generator kwarcowy.

Pokrótce omówimy „Total Station” koncernu HP produkowany od 1980 do precyzyjnych pomiarów odległości i kątów oraz współczesny ręczny dalmierzyk laserowy.

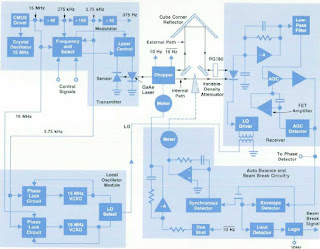

W Total Station do podczerwonej diody laserowej o długości fali 835 nm podany jest sygnał z generatora kwarcowego o częstotliwości „15” MHz lub podzielony circa 375 KHz lub 3.75 KHz co przy przesunięciu o kąt 360 stopni odpowiada maksymalnej mierzonej odległości 10m, 400m i 40 km. W obudowie lasera jest fotodioda która z pętlą sprzężenia zwrotnego stabilizuje moc emisji lasera.

Odbiornikiem sygnału optycznego odbitego od „Cube Corner Reflector” w miejscu mierzonym, wzmacniaczem i mieszaczem jest fotodioda lawinowa APD pracująca ze wzmocnieniem około 80 razy. Sygnał heterodyny podany jest mieszającej APD transformatorkiem od strony GND. Sygnał ze wzmacniacza podano do 8 biegunowego filtru środkowoprzepustowego o częstotliwości środkowej 4 KHz i dalej do detektora AGC i wzmacniacza o regulowanym wzmocnieniu.

Z laserem i fotodiodą współpracuje mechaniczny chopper napędzany regulowanym silnikiem który z częstotliwością 10 Hz raz wiązkę światła lasera kieruje na zewnątrz do pomiaru odległości a raz poprzez tłumik na fotodiodę co pozwala ustalić odległość zerową do kompensacji pomiaru. Szary klin regulacyjny jest solenoidem wpychany tak głęboko aby tłumił światło lasera tak samo jak ścieżka zewnętrzna.

„Local Oscillator Module” ma dwie pętle fazowe i dwa podstrajane niskoszumne generatory kwarcowe VCXO. Dostarcza sygnał heterodyny fotodiodzie lawinowej. Redukcja częstotliwości sygnałów zachodzi tak jak już wcześniej omówiono. Uśrednianych jest licznikami 100 pomiarów różnic faz którymi dyryguje wbudowany prosty i nietypowy mikrokontroler.

Koncerny HP i wydzielone z niego później firmy od lat siedemdziesiątych był i są producentem bardzo nowoczesnej optoelektroniki dostępnej komercyjnie i na zamówienie. Specjalnie dla Total Station wyprodukowano odpowiedni laser. Produkowana w małych ilościach TS była horrendalnie droga ale bardzo użyteczna w wielu zastosowaniach.

W standardowym powietrzu ( 15C i 760 mm Hg ) światło rozchodzi się z prędkością 299792,5 km /s i stąd wybrano z marginesem częstotliwość generatora „15” MHz 14.987087 MHz. TS ma wyrafinowany teleskop i układ optyczny.

We współczesnym ręcznym dalmierzyku laserowym o zasięgu 40 m ( pewny zasięg jest jednak mniejszy ) również zastosowano idee pomiaru przesunięcia fazy sygnałów i heterodynowego obniżenia częstotliwości sygnałów.

Na rysunku sygnał dla lasera o częstotliwości 150 MHz i heterodynę 150.005 MHz wypracowuje podwójny scalony syntezator PLL Si5351A. Syntezator otrzymuje od mikrokontrolera rozkazy szeregowym interface I2C i faktycznie częstotliwości są tym mniejsze im większy jest mierzony dystans.

W odróżnieniu jednak od Total Station dalmierzyk nie ma choppera mechanicznego wraz z układem optycznym i nie ma w związku z tym automatycznego „zerowania” odległości. Stąd użycie analogowego, selektywnego filtru środkowo przepustowego wnoszącego znaczne i zmienne przesuniecie czasu nie wchodzi w rachubę.

Użyty mikrokontroler z rodziny ARM ma znaczną wydajność i filtracje sygnałów analogowych próbkowanych z częstotliwością 50 KHz przeprowadzono cyfrowo. W takim zastosowaniu doskonały jest filtr o skończonej odpowiedzi impulsowej FIR o stałym opóźnienieniu lub Goertzel algorithm ( opisany w 1958 ) będący specjalizowana wersją, wariacją algorytmu dyskretnej transformaty Fouriera DFT ale w odróżnieniu od niej nie daje wszystkich punktów a tylko wybrane ( faktycznie potrzebne) co na przykład pozwala łatwo i tanio dekodować tony z kodowania telefonicznego DTMF. Zaletą algorytmu jest użycie liczb rzeczywistych a nie zespolonych. Jest on bardziej efektywny od FFT tylko dla małej ilości wymaganych punktów.

Ponieważ fotodioda lawinowa APD ( także jako wzmacniacz i mieszacz ) wprowadza ze zmianą temperatury szkodliwe przesuniecie fazowe mierzona jest termistorem temperatura i odległość jest programowo korygowana.

Mikrokontroler sygnałami PWM poprzez układy peryferyjne i filtry ustala napięcia zasilające fotodiody APD czyli jej wzmocnienie oraz polaryzacje diody laserowej prądem stałym czyli jej moc wyjściową która powinna wynosić do 1 mW.

Ponieważ w ramach produkowania nie naprawialnych urządzeń i utrudnienia życia konkurencji schematy są tajne przytoczone są schematy zdjęte z PCB dostępne na WWW w procesie reverse engineeringu chociaż mają one błędy i braki. Idea pracy urządzenia jednak jest ze schematów doskonale widoczna. Jednym mieszaczem jest APD a drugim para diod.

Optymalne dla szumów kompletnego systemu, wzmocnienie fotodiody lawinowej APD zależy od użytego w niej półprzewodnika i szumów wzmacniacza. Przy znacznym sygnale optycznym jest ograniczone wielkością mocy strat czyli prądu wyjściowego.

Na wykresie pokazano wzmocnienie fotodiody APD rodziny C309XX używanej w ćwiczeniu w funkcji napięcia polaryzacji.

Im niższa jest temperatura pracy tym lepsze są parametry APD i systemu z nią. Wymagane wzmocnienie uzyskuje się przy niższej temperaturze przy mniejszym napięciu wstecznym i przy dużo mniejszym prądzie ciemnym. Stąd przy stałym wzmocnieniu napięcie polaryzacji APD rośnie z jej temperaturą mierzoną termistorem NTC. W filtrze RC na wyjściu podwyższającej napięcie przetworniczki, rezystor ogranicza maksymalną moc strat w fotodiodzie APD. Układy scalone do odpowiednich przetworniczek są dostępne i względnie tanie, jak choćby na schemacie ręcznego dalmierza.

W wymagających rozwiązaniach APD ma w obudowie chłodzące ogniwo Peltiera ale taka APD jest znacznie droższa.

Jedna strona ogniwa Peltiera z APD działa jako chłodnica, a druga jako grzejnik odprowadzający ciepło do obudowy. Obudowę APD z ogniwem Peltiera trzeba więc chłodzić w biernym tego słowa znaczeniu. Mankamentem ogniwa Peltiera jest wymagany stosunkowo duży prąd zasilania. Generalnie w dużych modułach sięga on 50 A ale w APD jest roboczo znacznie poniżej 1A. Chłodzenie zastosowano w APD C30902SH-TC i C30902SH-DTC w dużych złoconych obudowach TO-66.

W wersji -TC maksymalny prąd wynosi 1.8A przy napięciu 0.8V a w wersji -DTC 1.4A przy napięciu 2V.

Ogniwa Peltiera używane są też do chłodzenie diod laserowych, których parametry także psuja się z temperaturą oraz innych sensorów.

Wymagane napięcia polaryzacji APD oczywiście spada w miarę doskonalenia technologii produkcji. APD jest bardzo szybkim i podstawowym odbiornikiem w komunikacji światłowodowej.

Koncern Hewlett - Packard był liderem w optoelektronice. Produkował też na rynek półprzewodnikowe elementy mikrofalowe. Natomiast układy scalone, zwłaszcza procesory, produkował tylko do swoich wyrobów. Dział półprzewodników optoelektroniki i mikrofalowych wydzielono jako Avago, które przejął Broadcomm.

Dawniej HP podawał schematy blokowe i ideowe jak dla transceivera HFBR-2416 o szybkości 125 Mbits/sec gdzie oczywiście zastosowano wejściowy wzmacniacz transkonduktancyjny. Napięcie polaryzacji odbiorczej fotodiody nie jest podwyższone ale ma zintegrowany filtr zakłóceń od zasilania.

Od 2015 roku oferowane są „poczwórne” transceivery Ethernet o równoważnej szybkości ponad 40 Gbits/sec:

-Avago QSFP-40G-ER4 zgodny z 40GBASE-QSFP-ER4 QSFP+ 1310nm, 40km DOM LC SMF Optical Transceiver Module kosztuje około 700 dolarów.

-Avago AFBR-79EEPZ zgodny z 40GBASE-ESR4 QSFP+ 850nm, 400m DOM MTP/MPO MMF Optical Transceiver Module kosztuje około 50 dolarów.

Wymienialne moduły są identyczne poza zasięgiem i ceną. Moduł o zasięgu maksymalnym 400 m jest tani a moduł o zasięgu do 40 Km jest drogi. Zasięg 40 Km jest już raczej domeną licencjonowanej i regulowanej telekomunikacji i można tanio tworzyć własną, prywatną szerokopasmową komunikacje. Cena 700 dolarów przy takim zasięgu wcale nie jest wysoka.

W katalogu Broadcomm oczywiście podano schematy blokowe różnych urządzeń komunikacji w zakresie mikrofalowych i proponowane do implementacji wyroby. Tabela ma ciąg dalszy.

XIX wieczną amerykańską „wojnę” prądu stałego Edisona z prądem zmiennym Westinghouse i Tesli wygrał oczywiście prąd zmienny, który był bardzo wygodny w dużej generacji oraz przesyle wysokim napięciem i dystrybucji energii. Jednak ekonomicznie uzasadniony poziom strat przesyłu wielkiej mocy Najwyższym Napięciem stałym jest około dwukrotnie niższy niż napięciem zmiennym ale tylko na duże dystanse.

Stałe sieciowe napięcie zasilania w nowoczesnym świecie ma dużo zalet. Zbędny jest w maszynie CNC i robocie kosztowny inwerter wejściowy umożliwiający zwrot energii hamowania do sieci zasilającej. Zbędny jest inwerter do PV i do transferu energii z akumulatora samochodu (!) do sieci AC. Zbędny są w SMPS moduły PFC o niebagatelnej cenie do zmniejszenia zniekształceń prądu i polepszenia współczynnika pobieranej mocy

Większość urządzeń elektronicznych a w tym TVC LED /LCD nie ma już wyłącznika sieciowego

Zasilające sieciowe napięcie stałe nie jest pozbawione znacznych wad:

-Wyłącznik prądu zmiennego nie rozłączy znacznego prądu stałego

-Przekaźnik o stykach mocy 10A/250 Vac może rozłączać prąd stały o natężeniu tylko 100 mA.

Łuk na każdym styku z przerywanym prądem zmiennym gaśnie po przejściu prądu przez zero. Przy prądzie stałym zapali się łuk !

-Bezpiecznik topikowy na prąd 10 Aac o wystarczającej do mieszkania zdolności zwarciowej ma wymiar 5x20mm ale do prądu stałego musi mieć rozmiar co najmniej 6x30mm. Obecnie różnica w cenie takich bezpieczników jest znaczna ale przy masowej produkcji drugiego typu bezpiecznika znacznie się zmniejszy do poziomu nieistotnego.

-Napięciem stałym nie mogą być zasilane urządzenia z transformatorem 50/60 Hz i silnikiem indukcyjnym. Ale kuchenki mikrofalowe mają już inwerter z tranzystorem IBGT i transformatorem ferrytowym a napęd talerza i wentylator stanowią silniczki BLDC zasilany z zasilacza impulsowego koniecznego do zasilenia elektroniki kuchenki.

-Napięciem stałym nie można zasilić pralki automatycznej nawet z silnikiem z inwerterem dlatego że zaworami operują triaki sterowane przez mikrokontroler a pompę wody napędza silnik indukcyjny a grzałkę załącza przekaźnik mocy a obwód grzałki rozłączają też przełączniki bezpieczeństwa.

-Stare lodówki z mało sprawnym jednofazowym silnikiem asynchronicznym wypierane są przez modele z silnikiem BLDC i inwerterem. Siec DC jest dla nich doskonała. Wentylatorek napędza tani silniczek BLDC z wbudowanym sterownikiem.

-Napięciem stałym nie można zasilać żadnego urządzenia z bimetalem a więc czajnika wody, żelazka, kuchenki oporowej, zmywarki. Ale kuchenki oporowe wychodzą z użycia jako ze płyty indukcyjne ( nie mają mechanicznego wyłącznika ) mają lepsza sprawność.

Jak zatem załączać odbiorniki dużej mocy czyli grzałki do sieci prądu stałego ?

-Można użyć kombinacji dwóch przekaźników i PTC. Takie coś produkowane masowo można umieścić w jednej obudowie

-”Wolno” przełączające tranzystory IGBT na 450V ( sterowane poziomem logicznym sygnału ) mają stosunkowo niewielki spadek napięcia Uce i są tanie. Muszą być jednak chronione w takim zastosowaniu przez tanie warystory. Ponieważ awaria klucza i nie wyłączenie grzałki grozi pożarem, awaryjnie zasilanie zwiera tyrystor Crow Bar wymuszający działanie bezpiecznika. Dla redukcji strat mocy tranzystor IGBT może być zbocznikowany stykami przekaźnika załączającego i wyłączającego bezprądowo.

-Można jako redundantny klucz szeregowo połączyć dwa tranzystory IGBT. Wystarcza jeden sygnał do sterowania obu, który do bramki górnego klucza podany jest przez izolującą wstecznie diodę.

Klucz IGBT może być jednak sterowany co nabiera znaczenia w przypadku stosowania Internet Of Thing.

Silnik asynchroniczny może zastąpić uniwersalny silnik komutatorowy.

Silnik uniwersalny regulowany triakiem w odkurzaczu i wiertarce nie ma przy zasilaniu z sieci prądu stałego regulacji i pracuje ma maksimum. Zastosowanie tam IGBT / Mosfeta i regulacji PWM zamiast regulacji fazowej nie zwiększy istotnie ceny wyrobu ale w obu zastosowaniach już stosowane są silniki BLDC gdzie sieć DC jest idealna.

Sprawdzenie.

-Do dokładnego pomiaru odcinków czasu ( na przykład w dalmierzach laserowych ) stosuje się dodatkowo do szybkich liczników analogowe interpolatory czasu, metodę pojedynczego noniusza elektronicznego i metodę podwójnego noniusza elektronicznego.

Podaj w przybliżeniu ( przy zastosowaniu takich samych elementów i ich technologii ) relatywne rozdzielczości i błędy pomiaru odcinków czasu tymi trzema metodami.

-Odwrotnie użyty algorytm Goertzel-a daje syntezę sinusoidy. Ile mnożeń i dodawań trzeba na jedną próbkę ?

Ćwiczenie

1.Oscyloskop jest dołączony ( szeregowy opornik zapobiega wzbudzaniu się wzmacniacza ) do wyjścia wzmacniacza nieselektywnie wzmacniającego wyjściowy prąd z odbiorczej fotodiody lawinowej w ręcznym dalmierzyku laserowym.

-Wyjaśnij dlaczego nie jest to ładny, czysty sygnał sinusoidalny.

-Od czego zależy poziom zakłóceń ?

2.Oscyloskop jest uniwersalnym przyrządem ale poważnym mankamentem jest uziemienie jego pomiarowego GND co uniemożliwia pomiar z jakimkolwiek napięciem wspólnym. Sygnał różnicowy z niechcianym sygnałem wspólnym można zmierzyć dwoma kanałami oscyloskopu ale tłumienie CMRR jest bardzo słabe a pływający sygnał jest przy tym przeciążony impedancją kabla do GND a nie lokalnego odniesienia. Można oscyloskop zasilić poprzez izolujący transformator ( oscyloskop nie jest bezpiecznie uziemiony !) lub użyć oscyloskopu z zasilaniem bateryjnym.

Philips do swoich oscyloskopów produkował izolowaną sondę PM8940 z zasilaniem bateryjnym z analogową optoizolacją. Pasmo wynosi około 2 MHz. Dedykowane analogowe transoptory mają jedną diodę LED i dwie fotodiody. Jedna fotodioda pracuje w układzie serwo po stronie nadawanego sygnału linearyzując i eliminując wszelkie dryfty. Te transoptory są jednak powolne toteż w sondzie zastosowano dwa szybkie transoptory. Fotodiody są w nich ekranowane co bardzo mocno zmniejsza zakłócenia common.

Driver CMOS IR2110 typowo steruje sygnałami prostokątnymi 10 Vpp o częstotliwości ca 500 kHz bramki półmostka z dwóch Mosfetów. Prąd napięcia zasilania dla półmostka z typowego zasilacza krzyżowego 30V jest ustawiony nisko aby tranzystory nie uległy uszkodzeniu przy zakłóceniach. Nie wolno go podnosić.

-Zarejestruj sygnał na bramce górnego Mosfeta z prostokątnym sygnałem wspólnym 30 Vpp oscyloskopem zasilanym przez izolujący transformator sieciowy 1:1, różnicowo dwoma kanałami oscyloskopu i sondą PM8940. W rzeczywistości sygnał jest identyczny jak na bramce dolnego Mosfeta. Wyjaśnij skąd są tak duże różnice

-Przy połączeniu końcówki kabla pomiarowego z GND - ekranem dołączonym do wyjścia mostka ( dalej z transformatorem izolującym sieć ) wyjaśnij jak ( co dodać ?) zminimalizować ten zakłócający pomiar sygnał wspólny.

-Zmierz ( jak wyżej ) jakie jest tłumienie przez sondę PM8940 sygnału wspólnego 30 Vpp – 500 KHz.

-W sondzie dwa transoptory oznaczone na schemacie i PCB jako D204 i D206 opisano w wykazie elementów dokumentacji ( pdf ) jako „Opto Coupler Sel”. Na elementach w sondzie nazwy są usunięte. Posługując się opasłym „katalogiem” Hewlett Packard 1997 ustal nazwę transoptorów.

Bardzo przydatny artykuł. Wysoki poziom.

OdpowiedzUsuńWitam Staram się zamieszczać użyteczne informacje

UsuńRewelacyjny jest ten wpis. Ogromna porcja informacji.

OdpowiedzUsuńWitam. Informacje mogą być przydatne projektantowi.

Usuń